简介

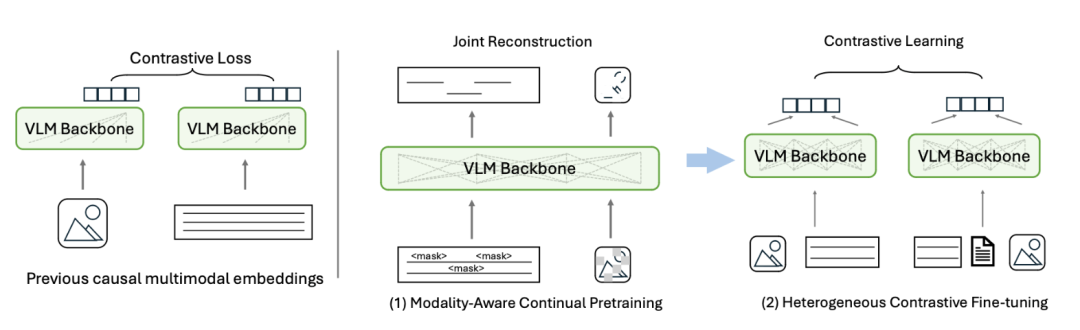

随着 GPT-4o、Qwen-VL 等生成式视觉-语言模型(VLM)大放异彩,通用多模态表示的需求也急速升温;然而,直接用这些 VLM 做检索或理解任务时,单向因果注意力机制往往限制了表示质量。为应对这一问题,来自中国人民大学、微软亚洲研究院、斯坦福大学、普林斯顿大学等机构的研究者提出了MoCa框架,是一个“持续预训练 + 异构对比微调”的两阶段框架,可将单向注意力 VLM 轻量化地训练成 SOTA 级双向多模态编码器。

TLDR:本文首次提出针对双向多模态表征模型的持续预训练方法,来高效利用无监督的多模态数据。

Paper:https://arxiv.org/abs/2506.23115

HomePage:https://haon-chen.github.io/MoCa/

研究动机

尽管 VLM 生成能力强,但直接拿来做嵌入仍有三大痛点:

-

单向因果注意力机制不利于表示学习现有多模态嵌入模型大多沿用 VLM 的单向因果注意力机制,导致上下文利用受限,表示质量逊于双向编码器。

-

训练目标与数据分布单一传统方法主要在短图文对上做单一对比学习,难以激发 VLM 已具备的复杂跨模态推理能力,也易对特定分布过拟合。

-

高质量成对数据难以扩展对比学习依赖人工或规则筛选的图文对,获取成本高且无法利用海量未配对的多模态信息。

MoCa 针对以上痛点提出:

-

用联合重建任务引入双向注意力; -

高效利用大规模非标注数据,提升多模态嵌入模型的双向理解和泛化能力; -

利用多样化的对比学习数据进一步提高模型的鲁棒性和泛化性能。

MoCa 框架

MoCa 由两个阶段构成:

(1)针对不同模态的持续预训练(Modality-aware Continual Pre-training)

通过引入联合重建任务,模型以双向的方式同时还原被随机遮盖的文本 token (Masked Language Modeling, MLM)和图像 patch(Masked Autoencoding, MAE),打破原有因果掩码的限制,使模型充分捕获跨模态与跨语言的细粒度语义关系。

(2)异构对比学习微调(Heterogeneous Contrastive Fine-tuning)

在微调阶段,MoCa 利用多样化的异构数据,包括:

-

长文档检索对:增加长文本语义推理能力; -

传统短图文对:维持基础的图文对齐; -

纯文本对:补充语义多样性与泛化能力。

并通过任务感知批采样策略提高训练效率,有效提升难负样本的多样性和区分度,最终强化多模态嵌入的泛化能力。

实验结果

总体结果

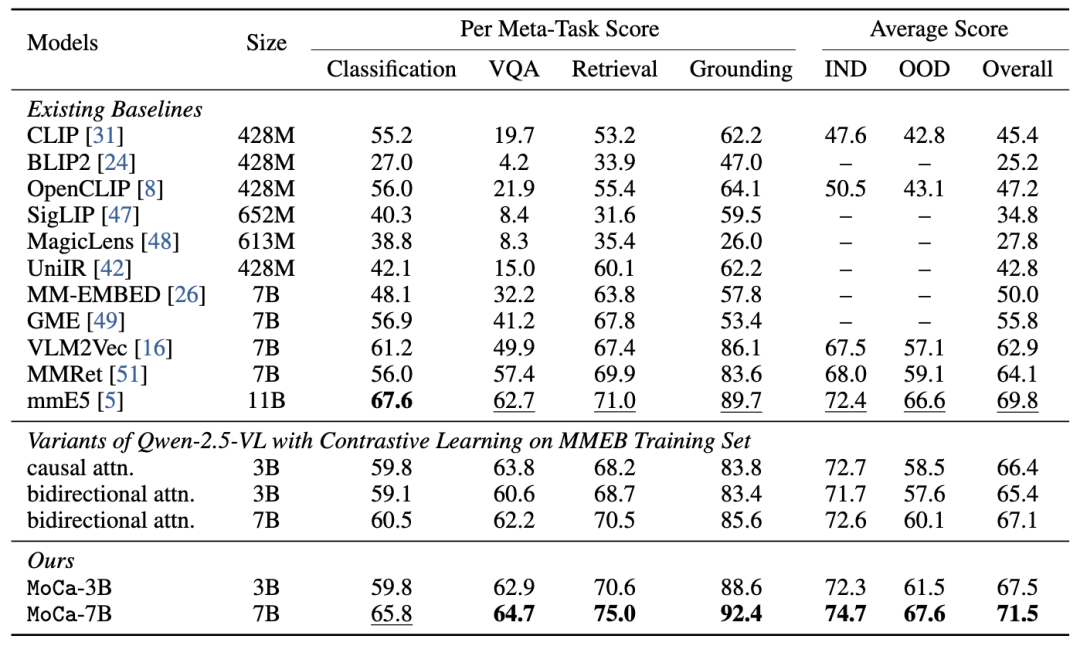

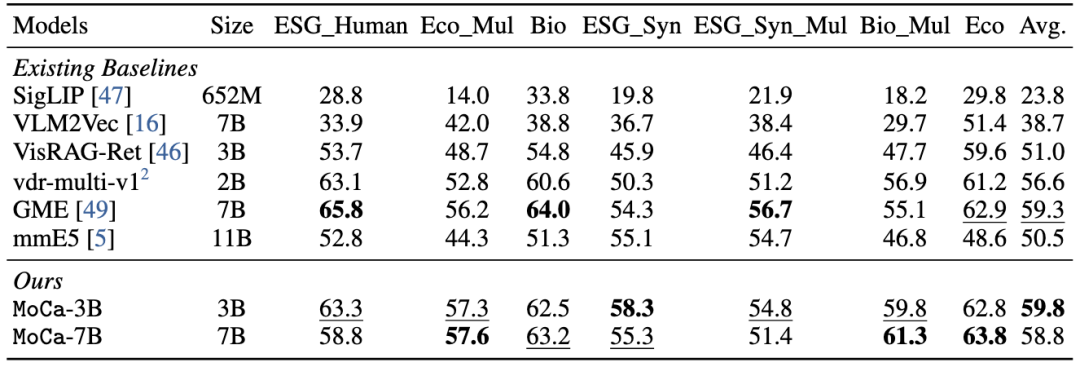

在 MMEB 与 ViDoRe-v2 两大主流多模态嵌入基准上,MoCa 均取得显著性能提升:

-

MMEB(36 个任务): MoCa-3B 比同规模基线提升显著,甚至能够达到现有7B规模baseline模型的性能水平。MoCa-7B 达到当前最佳表现(SOTA)。

-

ViDoRe-v2(7 个任务): MoCa达到最佳single embedding model(除去colbert based),展现出强大的复杂文档图片检索能力。

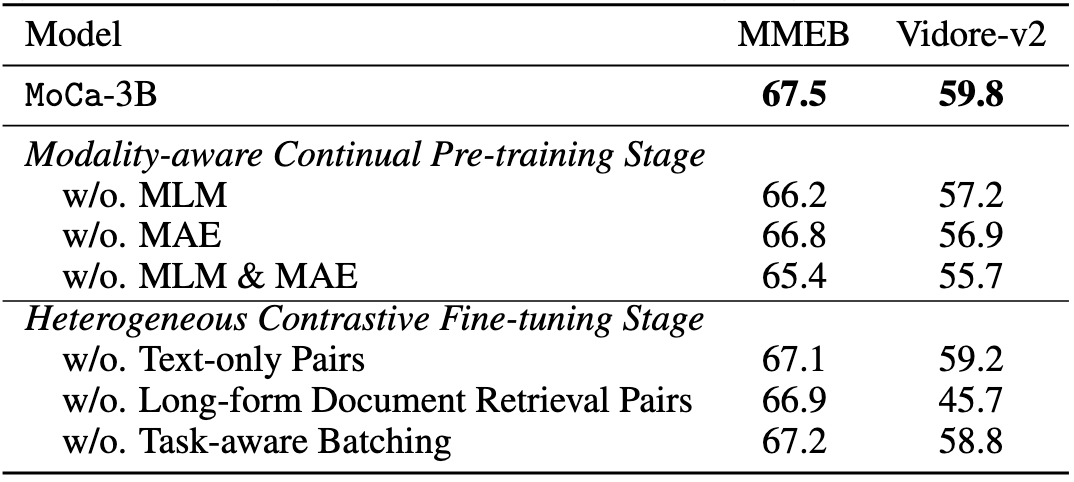

消融实验

消融实验表明:

-

去除持续预训练(Modality-aware Continual Pre-training)中的MLM和MAE后,模型表现均显著下降,说明 CPT 阶段学习的双向跨模态特征至关重要; -

若移除异构对比学习中新引入的数据,仅用单一类型数据做对比微调,模型泛化性能明显降低,印证了异构样本与任务感知批采样的必要性。

关于模型参数以及训练数据规模的扩展性

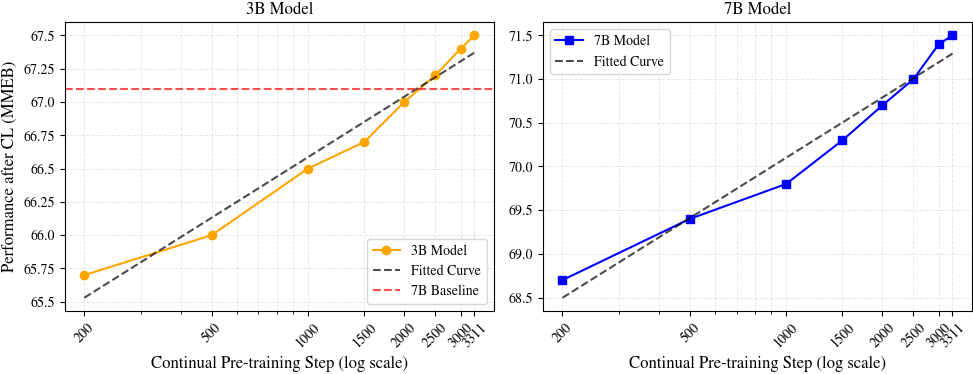

Scaling 实验进一步验证了 MoCa 的高效性:

-

仅使用 20 B token 进行 CPT 后,3B 模型即可逼近甚至超越未 CPT 的 7B baseline模型; -

模型性能随着数据规模的增大呈稳定提升趋势,证明 MoCa 能高效利用大规模数据进一步提升表示质量。

未来展望

MoCa 展示了将生成式 VLM 转化为高质量双向多模态编码器的巨大潜力,但仍有若干值得进一步探索的方向:

-

扩展至更多模态与任务场景当前 MoCa 主要聚焦图文检索任务,未来可以拓展至视频、音频等更复杂的模态,以及如多跳问答、多模态推理等更具挑战性的应用。

-

提升多语言适应能力虽然 MoCa 已支持多语种文本输入,但在低资源语言或跨语言检索上的表现仍有提升空间,可结合语言自适应预训练进一步增强鲁棒性。

-

自动合成高质量训练数据利用 LLM 合成多样化的图文对已成为趋势。后续可探索如何通过生成式模型构建异构样本,辅助对比训练,从而进一步降低对人工数据的依赖。

-

与生成能力结合的统一模型当前 MoCa 专注于表征能力优化,与原始 VLM 的生成能力相对割裂。未来可以探索如何构建兼具理解与生成的统一多模态模型,提升整体系统的通用性与实用性。

通过这些方向的拓展,MoCa 有望进一步推动多模态嵌入模型向更强、更广、更智能演进。

(文:PaperAgent)