大型语言模型(LLM)的后训练是将其应用于实际任务的关键阶段,主要包括监督微调(SFT) 和基于人类反馈的偏好学习(如DPO)。传统观点认为SFT仅是DPO的”热身步骤”,两者缺乏理论关联。本文突破性地证明:SFT与DPO本质都在学习隐式奖励函数,且共享相同的策略-奖励最优子空间。这一发现不仅统一了两类方法,还揭示了传统SFT的缺陷——KL散度项在优化中退化为常数,导致模型更新缺乏约束。通过理论推导与实验验证,论文提出简单有效的改进方案,显著提升模型性能(相对增益达25%),为LLM对齐提供了新视角。

-

论文:A Unified View of SFT and DPO Connections via Implicit Reward -

链接:https://arxiv.org/pdf/2507.00018v1

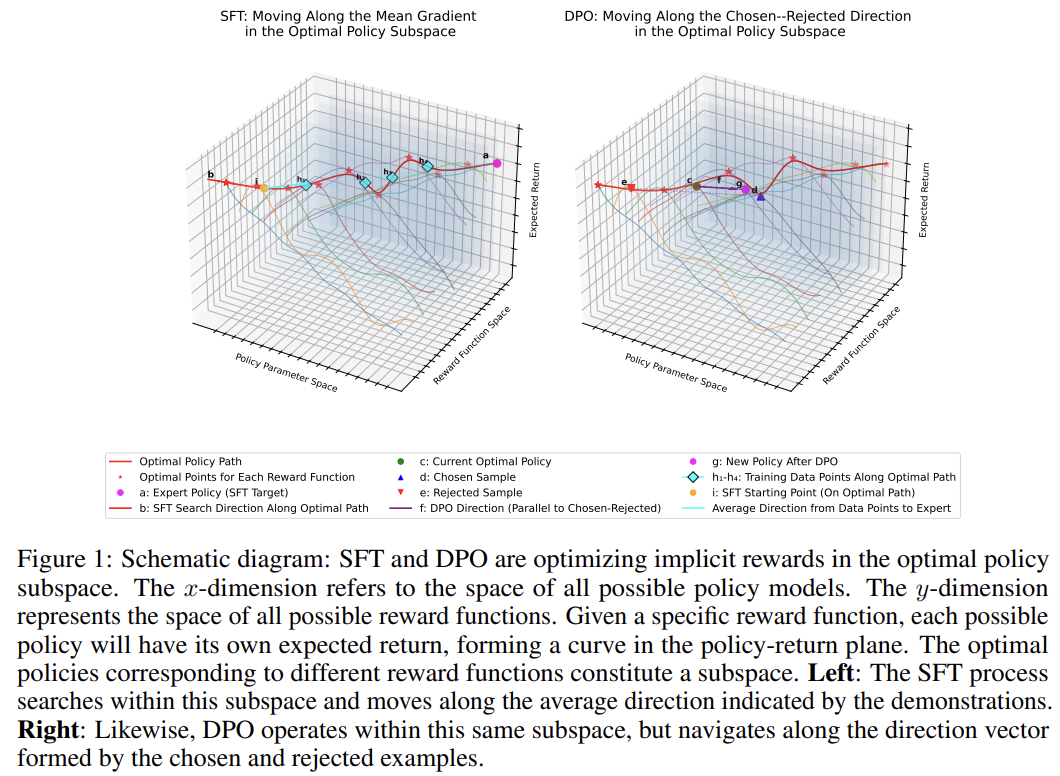

1. 理论基础:SFT与DPO的统一视角

分布匹配的再形式化

后训练的核心目标是最小化专家数据分布()与策略模型分布()的差异。传统模仿学习使用以下目标:

其中 是f-散度(如KL散度), 约束策略偏离预训练模型的程度。

关键定理:隐式奖励的桥梁作用

定理1 将分布匹配转化为双层优化问题:

核心洞察:

-

内层 学习特定奖励函数 下的最优策略 -

外层 优化奖励函数以匹配专家分布 -

SFT是当 取总变差(Total Variation)时的特例,此时目标退化为MLE损失:

传统SFT的缺陷

在退化的SFT目标中,KL项 是零阶常数,无法提供梯度约束:

“KL项缺失导致DPO训练的起点远离基础模型,影响最终性能。”

这解释了为何SFT模型容易过拟合专家数据,丧失预训练知识。

2. 方法改进:学习率调整与替代目标

小学习率策略

理论依据:KL项缺失使SFT更新步长过大。作者提出:

-

将SFT学习率从 降至 (Llama3)或 (Mistral) -

通过减小单步更新幅度,间接模拟KL约束效应

基于f散度的新目标

为保留KL项的约束力,作者从f散度导出新目标函数:

-

Pearson χ²散度:引入平方概率差项约束KL -

Squared Hellinger散度:通过概率差系数调制梯度

两者避免对数/指数运算,保障数值稳定性。

训练目标对比:

|

|

|

|---|---|

|

|

|

|

|

|

|

|

3. 理论扩展:Logits与Q函数的关联

定理2:Logits作为隐式Q函数

在SFT过程中,语言模型的Logits()对应隐式奖励的Q值:

符号解释:

-

:满足公式(4)的隐式奖励 -

:折扣因子 -

:仅依赖状态的偏移项(不影响动作排名)

价值主导假设:

“状态间 的差异远小于 的差异,故Logits可代理状态价值。”

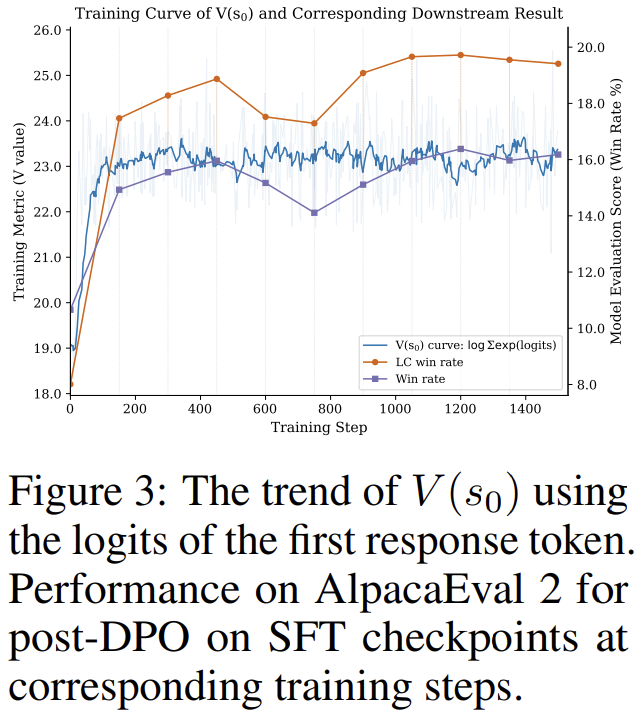

这意味着可直接用Logits的log-sum-exp估计 ,无需蒙特卡洛采样。

4. 实验验证

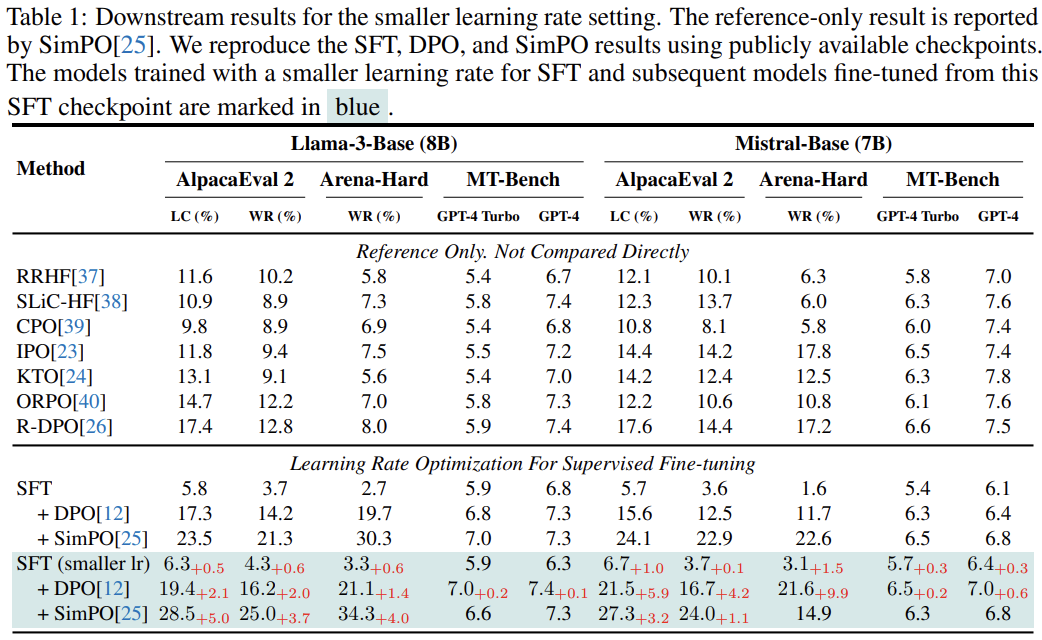

小学习率的显著提升

在Llama3-8B和Mistral-7B上的实验结果:

-

SFT阶段:小学习率仅带来轻微改进(+0.5–1.0% LC-Win) -

DPO后:相对性能提升20–25%,绝对胜率增加5–6%

“SimPO在Mistral上从15.6% → 21.5%,验证KL约束的重要性。”

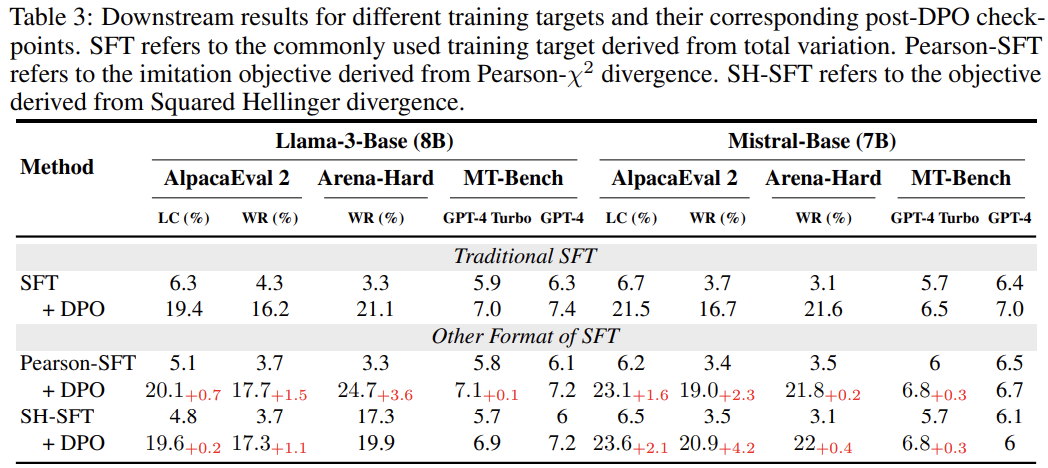

替代目标函数的优势

-

Pearson-SFT + DPO:绝对胜率最高提升3.6%(Llama3) -

关键发现:SFT阶段的强表现未必导向更好的DPO结果

“保留KL项的替代目标虽削弱SFT性能,但显著提升DPO结果。”

Logits的价值函数属性

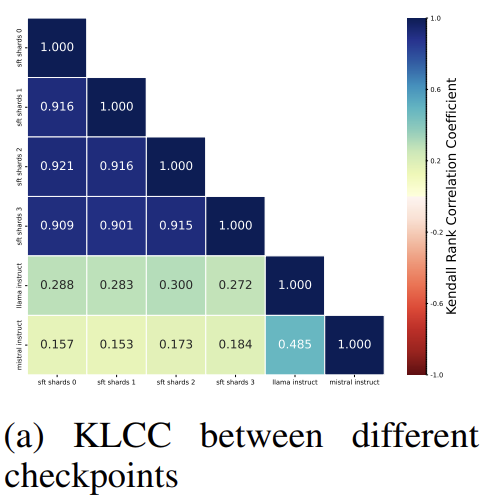

-

在MATH-500推理步骤上计算Kendall等级相关系数(KLCC) -

不同模型/数据切片的估值排名相关性接近1

“Zephyr与Llama3-instruct的估值排名高度一致,间接验证定理2。”

5. 讨论与影响

SFT的奖励稳定作用

-

SFT快速将初始随机奖励 收敛至合理区间(150步内) -

早期退出实验:150步后DPO性能趋于稳定,后续训练仅微调

哲学意义:LLM的环境意识

隐式奖励的发现引发思考:

“LLM是否可视为具有预设环境认知的实体?”

这为AI意识讨论提供了新视角。

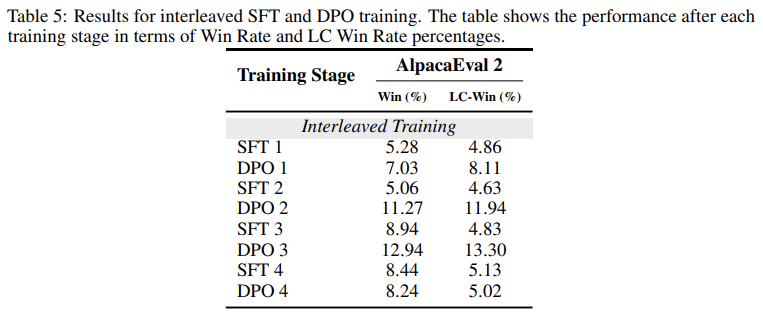

多目标学习的失败启示

尝试联合优化SFT与DPO目标(公式36):

结果:交替训练导致性能震荡,SFT阶段削弱DPO增益。

根本矛盾:SFT假设数据为最优轨迹,而DPO依赖偏好冲突。

结论

-

理论统一:证明SFT与DPO均通过隐式奖励优化策略,打破二者割裂认知。 -

方法创新: -

小学习率SFT显著提升DPO性能(+25%相对增益) -

基于f散度的新目标保留KL约束,进一步改善结果 -

深度洞见: -

Logits在SFT中充当隐式Q函数,扩展了DPO的结论 -

SFT的核心作用是校正初始奖励的随机性 -

未来方向:探索更稳健的SFT-DPO多目标优化框架,验证隐式奖励的可解释性。

这篇文章的核心价值:为LLM对齐提供首个SFT-DPO统一理论框架,同时提出简单高效的实践方案,兼具学术突破性与工程落地价值。

(文:机器学习算法与自然语言处理)