OpenAI年终大戏最后一天放出了大招OpenAI o3:编程、ARC-AGI、数学强悍;成本高,超级大期货,非AGI。

OpenAI o3:编程、ARC-AGI、数学强悍

编程能力,o3在CodeForces取得了2727的ELO分数,超过了o1的1891分,相当于CF编程榜单175名,已经超越99%的人类

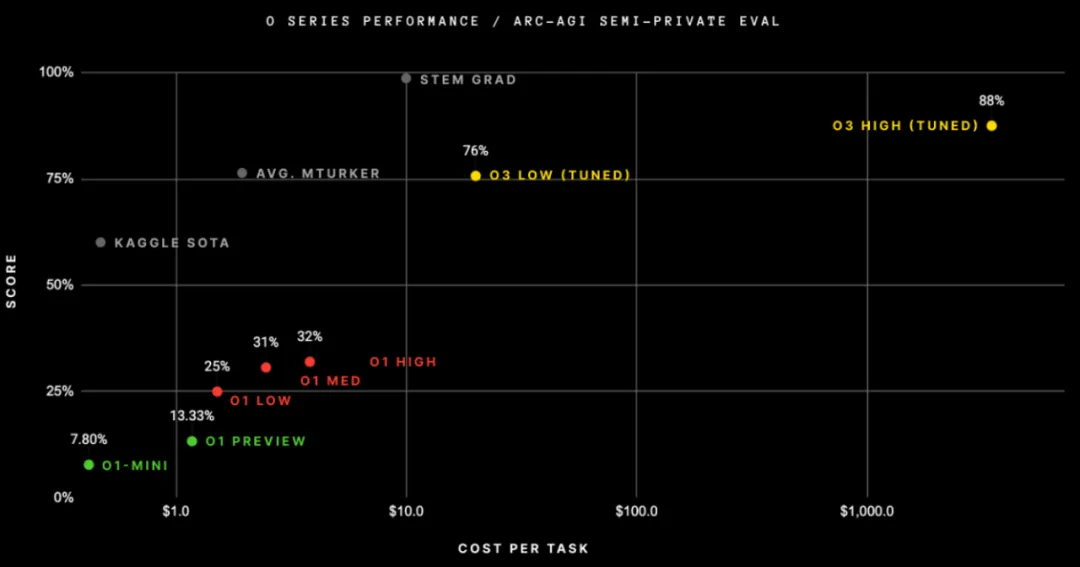

ARC-AGI测试,o3达到了87.5%,超过了人类的85%

数学能力:o3在AIME考试中的准确率高达96.7%,o1为83.3%。

在OpenAI o3发布之前Sam Altman已经在神秘造势:oh oh oh(o3)

OpenAI o3:成本高,超级大期货,非AGI

OpenAI o3贵

在ARC-AGI评测中,o3-high单个任务消耗的成本已经超过1000美元了~

OpenAI o3 超级大期货

o3并未开放,可以申请内测

通过ARC-AGI并非就实现了AGI,o3仍然在一些非常简单的任务失败了,这与人类智能还存在本质性差别~

high-compute o3 没有解决的case

o3 的核心机制似乎是在token空间内进行自然语言程序搜索和执行 – 在测试时,模型搜索可能的解决任务所需的思维链(CoTs)的描述步骤,在某种方式上可能与 AlphaZero 风格的蒙特卡洛树搜索相似。在 o3 的情况下,搜索可能由某种评估模型引导。

因此,传统 LLM 在新颖性上面临困境,o3 通过生成和执行自己的程序克服了这一点,其中程序本身(CoT)成为知识重组的工件。虽然这不是测试时知识重组的唯一可行方法(也可以进行测试时训练,或在潜在空间中搜索),但根据最新的 ARC-AGI 测试效果,这代表了目前的最新技术水准。

事实上,o3 代表了一种 深度学习引导的程序搜索。模型在“程序”空间(在这种情况下,自然语言程序 – 描述手头任务解决步骤的思维链 CoTs 的空间)上进行测试时搜索,由深度学习先验(基础 LLM)引导。解决单个 ARC-AGI 任务可能最终需要数千万美元的token和数千美元的成本,是因为这个搜索过程必须探索程序空间中的大量路径 – 包括回溯。

https://github.com/arcprizeorg/model_baseline/tree/main/resultshttps://openai.com/12-days/https://arcprize.org/blog/oai-o3-pub-breakthroug

(文:PaperAgent)