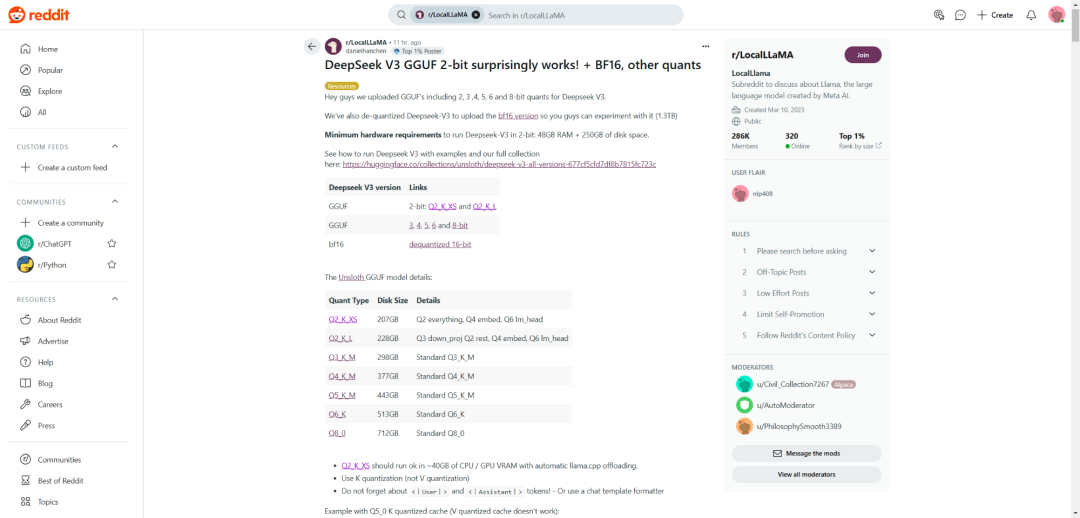

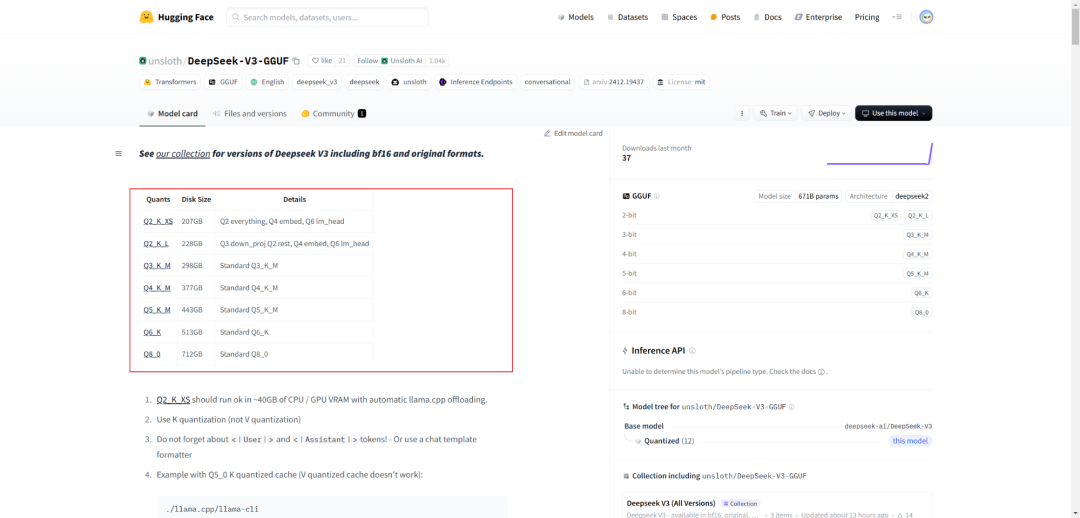

上传了 DeepSeek V3 的 GGUF 版本,包括 2、3、4、5、6 和 8-bit 的量化模型。还对 DeepSeek V3 进行了反量化处理,上传了 BF16 版本(大小为 1.3TB),方便大家进行实验。运行 DeepSeek V3(2-bit 版本)的最低硬件要求:48GB 内存 + 250GB 磁盘空间。

查看如何运行 DeepSeek V3 的示例以及完整模型合集,请访问以下链接:https://huggingface.co/collections/unsloth/deepseek-v3-all-versions-677cf5cfd7df8b7815fc723c

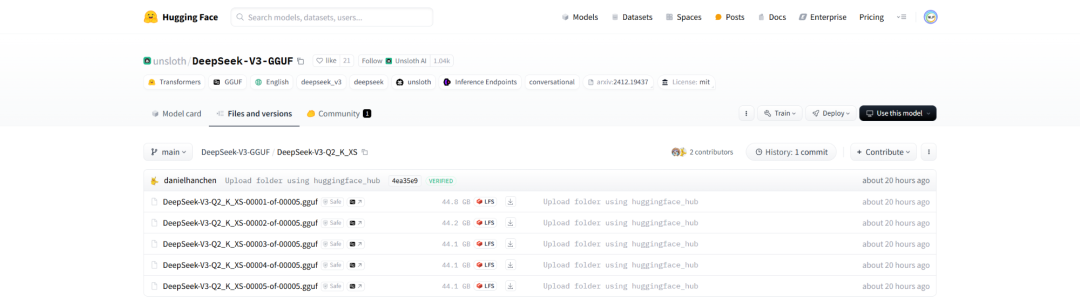

DeepSeek-V3-GGUF/DeepSeek-V3-Q2_K_XS,如下所示:

参考文献:

[1] https://www.reddit.com/r/LocalLLaMA/comments/1hw1nze/deepseek_v3_gguf_2bit_surprisingly_works_bf16/

[2] https://huggingface.co/unsloth/DeepSeek-V3-GGUF

(文:NLP工程化)