量子位

量子位

Kimi开源底层推理框架,1小时GitHub揽星1.2k

月之暗面Kimi联合清华大学等机构开源大模型推理架构Mooncake,采用分阶段方式逐步实现高性能KVCache多级缓存的开源。该架构提升了Kimi用户体验,降低了成本,并为处理长文本和高并发需求提供了解决方案。

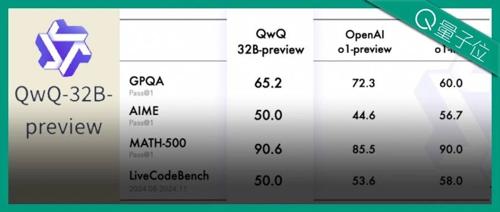

Qwen版o1发布即开源!32B参数比肩OpenAI o1-mini,一手实测在此

通义千问团队发布推理模型QwQ,参数量32B,在GPQA等数据集上击败o1-mini,并开源。但其回答较长且冗余,后续需改进简洁度。

上海AI实验室版o1已上线!数学竞赛题、Leetcode赛题全拿下,还会玩24点

国产o1新选手登场,上海AI实验室版o1——书生InternThinker能快速解决数学、代码编程等任务,并能在推理过程中进行自我反思和纠正。其长思维能力提升显著,已在数学、代码及逻辑谜题等多种场景中展现优势。

史无前例!Seq2Seq和GAN同获NeurIPS时间检验奖,Ilya连续2年获奖

NeurIPS颁发了两个时间检验奖,分别是GAN(引用超过85,000次)和Seq2Seq(引用超过27,000次)。GAN在生成建模中具有基础性作用;Seq2Seq启发了编码器-解码器架构的发展。

清华量子计算成果登顶刊,首次发现噪声影响量子优势,来自丘成桐数学中心团队

清华大学魏朝晖团队发现噪声可导致量子优势突然消失的现象,并首次将其发表于Science Advances。研究揭示了量子信息处理中噪声对量子计算性能的显著影响,为量子纠错机制的应用提供了指导。

1行代码改进大模型训练,Llama训练速度提升至1.47倍,全华人团队出品

研究人员提出Cautious Optimizers优化器,在不损害训练效果的情况下提升了大模型的训练效率47%,该优化器已在GitHub上开源。它通过引入掩蔽机制来避免参数更新方向与当前梯度方向相悖,从而加速了训练过程并保持了收敛特性。