“ 自然语言处理是一门让机器理解人类语言的技术,是人和机器交流的桥梁 ”

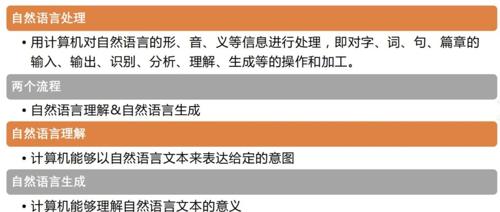

自然语言处理(Natural Language Processing, NLP)是人工智能(AI)的一个分支,旨在让计算机能够理解、生成和处理人类的自然语言(如中文、英文)。

NLP 的目标是让计算机能够像人类一样理解和使用语言,从而实现人机自然交互、自动化信息处理等功能。

自然语言处理

自然语言处理的技术实现原理

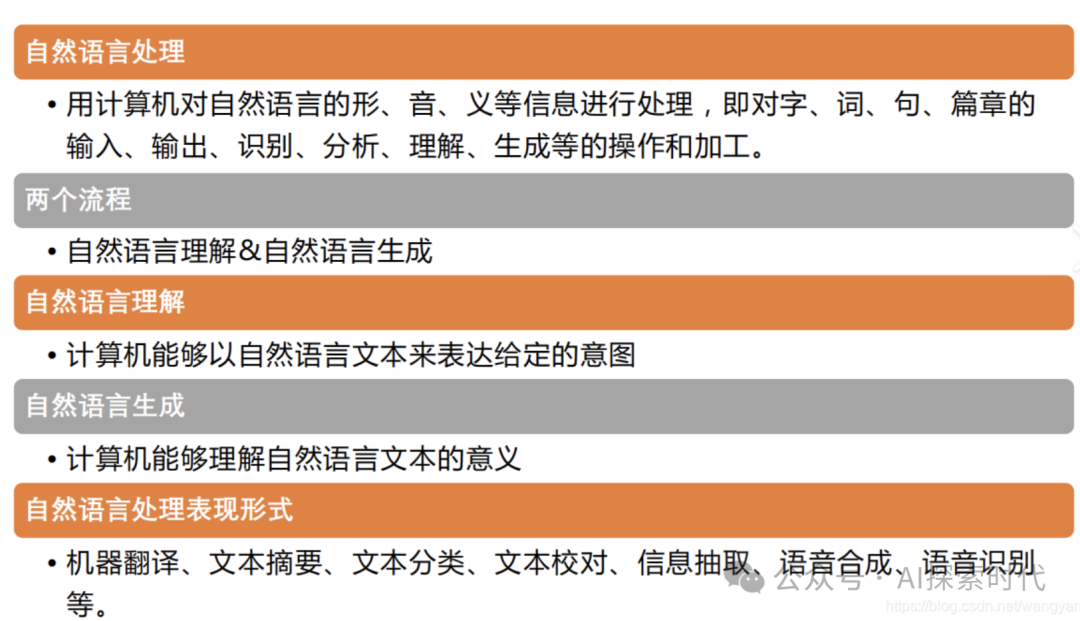

NLP 技术主要依赖于语言学知识、统计方法和深度学习技术,逐渐从基于规则的实现方法发展到依赖神经网络和大规模预训练模型的现代实现方法。

1. 传统 NLP 方法

-

规则驱动:

-

基于手工规则,如上下文无关文法(CFG)、正则表达式。

-

优点:易解释、逻辑清晰。

-

缺点:灵活性差,难以处理复杂语言现象。

-

统计方法:

-

使用统计模型对语言现象建模。

-

典型模型:隐马尔可夫模型(HMM)、条件随机场(CRF)。

-

应用:词性标注、命名实体识别、机器翻译等。

2. 深度学习与神经网络方法

-

词向量表示:

-

将语言中的词表示为高维向量,使其包含语义信息。

-

方法:Word2Vec、GloVe、FastText。

-

示例:语义相近的词,如“国王”和“女王”,其向量表示距离更近。

-

序列模型:

-

使用循环神经网络(RNN)、长短时记忆网络(LSTM)等捕捉语言序列特性。

-

缺点:难以处理长距离依赖。

-

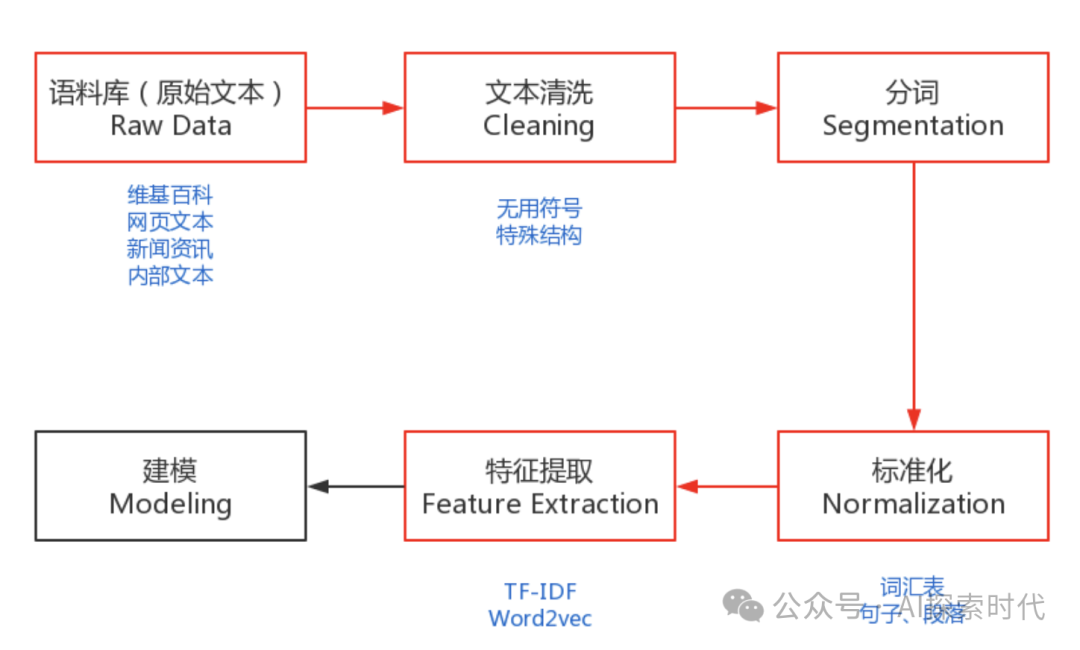

Transformer 及其改进:

-

Transformer 通过自注意力机制捕捉长距离依赖,是现代 NLP 的核心技术。

-

代表模型:BERT、GPT、T5 等。

-

预训练与微调:

-

使用大规模数据预训练语言模型(如 GPT、BERT),然后通过少量数据在特定任务上微调。

-

优点:通用性强,适配多种任务。

自然语言处理的困难点

1. 语言的复杂性

-

多义性:

-

一个词或句子可能有多种解释。

-

示例:“银行”可能指金融机构,也可能指河岸。

-

长距离依赖:

-

在长句中,句子的语义可能依赖较远的上下文。

-

示例:“尽管他生病了,他仍然参加了比赛。”需要理解“尽管”和“仍然”的逻辑关系。

-

隐含语义:

-

有些句子的意义需要结合上下文才能理解。

-

示例:“他是一个很‘棒’的厨师。”需要判断“棒”是褒义还是讽刺。

2. 数据问题

-

数据稀缺:

-

对于某些语言或领域,标注数据不足。

-

示例:少数民族语言、专业医学文档等。

-

数据偏见:

-

训练数据中的偏见可能导致模型输出不公平的结果。

-

示例:男女职业刻板印象。

-

数据质量:

-

噪声、不准确或不一致的数据会影响模型的性能。

3. 技术实现的复杂性

-

模型训练成本高:

-

现代语言模型需要大规模计算资源。

-

示例:GPT-3 的训练需要数百 GB 的文本和巨大的算力。

-

多语言处理:

-

不同语言的语法、词汇、表达方式不同,导致跨语言处理困难。

-

实时性需求:

-

在对话系统、实时翻译等场景中,模型需要快速响应。

4. 模型解释性

-

深度学习模型(如 Transformer)通常被视为“黑箱”,难以解释其决策过程。

总结

自然语言处理通过结合语言学、统计学和深度学习技术,推动了机器对语言的理解和生成能力的发展。然而,NLP 的实现仍面临多义性、上下文理解、数据稀缺和模型偏见等问题。随着技术的进步和数据的积累,NLP 将继续朝着更智能、更自然的方向发展,为人机交互、信息检索、智能翻译等领域带来更多可能性。

(文:AI探索时代)