这次,Meta首席AI科学家被群嘲了!

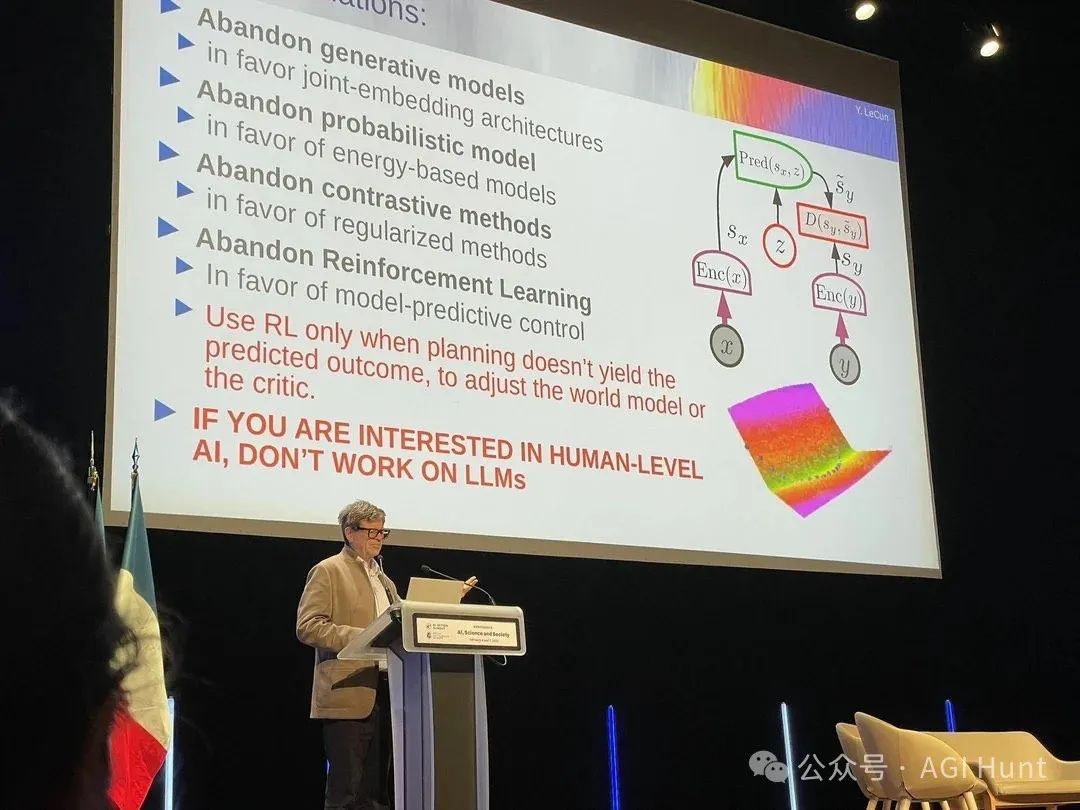

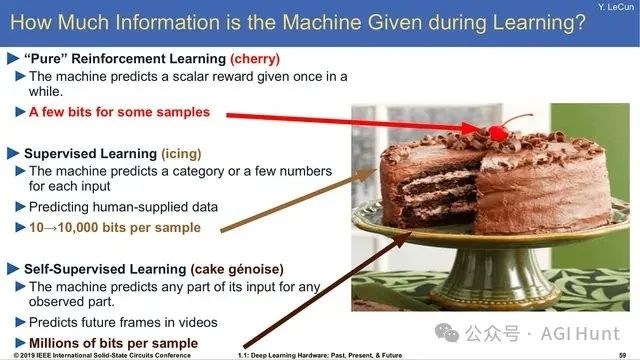

当Yann LeCun在最新演讲PPT上写下「放弃生成模型、放弃对比学习、放弃强化学习」时,整个AI圈炸开了锅——这位深度学习先驱的激进主张,正在遭遇从业者的集体质疑。

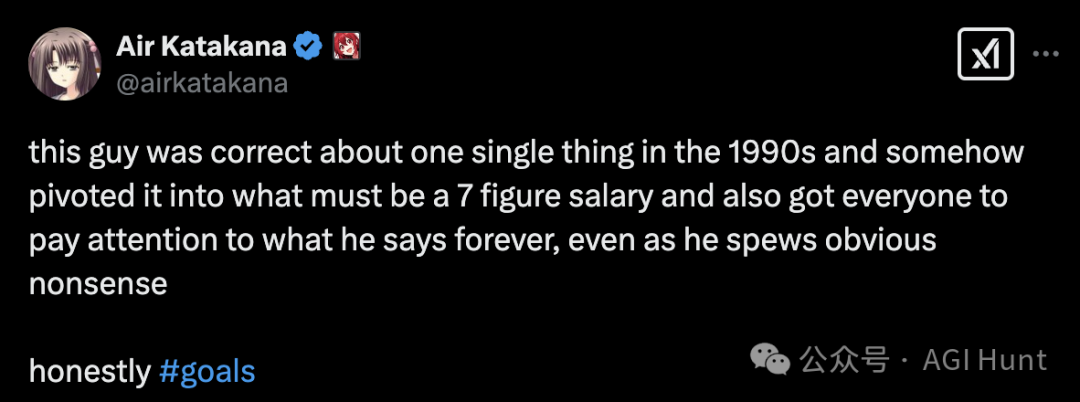

这位曾正确预言深度学习革命的图灵奖得主,如今被网友@airkatakana 调侃为「上世纪90年代赌对一次就吃一辈子」的学术明星。

他最新提出的AI发展路线图,几乎与当前主流技术趋势完全相悖:

转向联合嵌入架构

拥抱基于能量的模型

用模型预测控制替代强化学习

只在必要时使用RL调整世界模型

「想研究人类级AI就别碰大语言模型」

这番言论立即引发大批网友的共鸣和围攻。

@teortaxesTex 直指「列表里每项都与实际可扩展方案背道而驰」,@airkatakana 嘲讽这是「异端思想换高薪的经典操作」。

就连Meta内部员工@BrettBaronR32 也暗讽:「带领万亿市值公司的研究部门,结果被用树莓派做推理的中国团队碾压」。

(DeepSeek:

但LeCun 的支持者阵营也同样强大。

剑桥教授@NandoDF 搬出历史:「当年他推广SGD和GPU训练时也被当疯子。他主导开发的Torch框架直接孕育了PyTorch,能量模型和孪生网络的突破至今仍在影响学界」。

Meta应用科学家@ITica007 也力挺LeCun:采用JEPA框架的视频模型已在动作识别、异常检测等任务实现SOTA,其学习表征的鲁棒性比传统方法提升37%。

更关键的是,DeepSeekMath论文显示强化学习仅需微调就能激发大模型潜在推理能力,犹如「用螺丝刀拧开认知封印」。

这场争论暴露出AI界根本性认知分裂。

@basedneoleo 指出:「理论正确性不等于实践相关性」。其点明了当前的AI 困境:「大语言模型就像量子力学里的波函数,你永远不知道它何时会坍缩出荒谬答案。而Yann坚持的能量模型或许能提供确定性保障,但代价是牺牲现在唾手可得的80分解决方案」。

如何选择,并不是件容易的事。

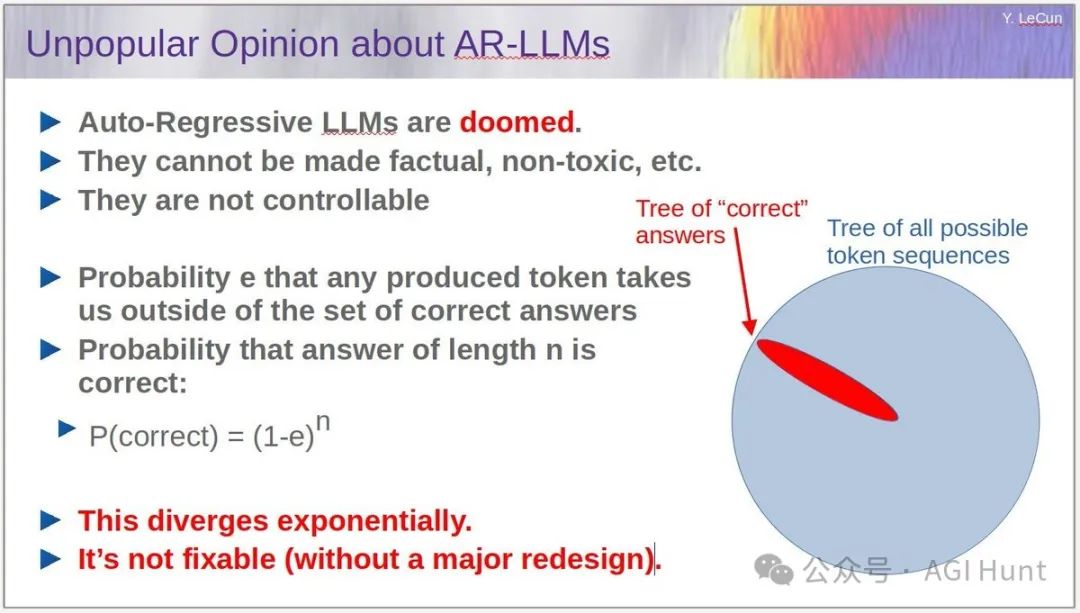

当Yann坚持「自回归模型存在不可修复的错误累积」时,@jeevliberated 反呛:「推理时间扩展已突破部分根本限制」(见论文2305.18654)。

而LeCun 的处境似乎也颇为微妙。

@patrickmesana 指出当前Meta的战略困局:「Yann的立场直接导致公司研发资源分散。要么赌出AGI通吃全局,要么持续开源模型为他人做嫁衣」。

当OpenAI和谷歌All in大模型时,Meta的混合路线正引发内部路线斗争。而LeCun 的选择则是:「要么赌出AGI,要么白送开源模型多年」。

@C0r0na_Chan 则进行本质性的质疑:「LLM真能理解事物吗?」

在支持的人眼中,Yann像极了当年坚持「 heavier-than-air飞行器不可能」的物理学家开尔文勋爵。

@type1ayy 提醒道:「有些『错误』思想会在范式转换后重生」。就像他1998年论文提出的卷积网络,蛰伏二十年后才引爆图像革命。

此刻,那个在PPT上写下「IF YOU ARE INTERESTED IN HUMAN-LEVEL AI, DON’T WORK ON LLMs」的身影,正站在新旧范式交锋的台风眼。

当@BorisBartlog 嘲讽「他根本不懂现实技术」时,历史是否正在重演1990年代深度学习被群嘲的剧本?

Yann LeCun 的预言将成为「反向指标」还是「先见之明」?

亦或者,如某网友所言,技术路线的选择本质上只是个赌注而已?

你怎么看?

(文:AGI Hunt)

Yann的选择,究竟是赌注还是智慧?技术路线的抉择,或许就是人生大题。