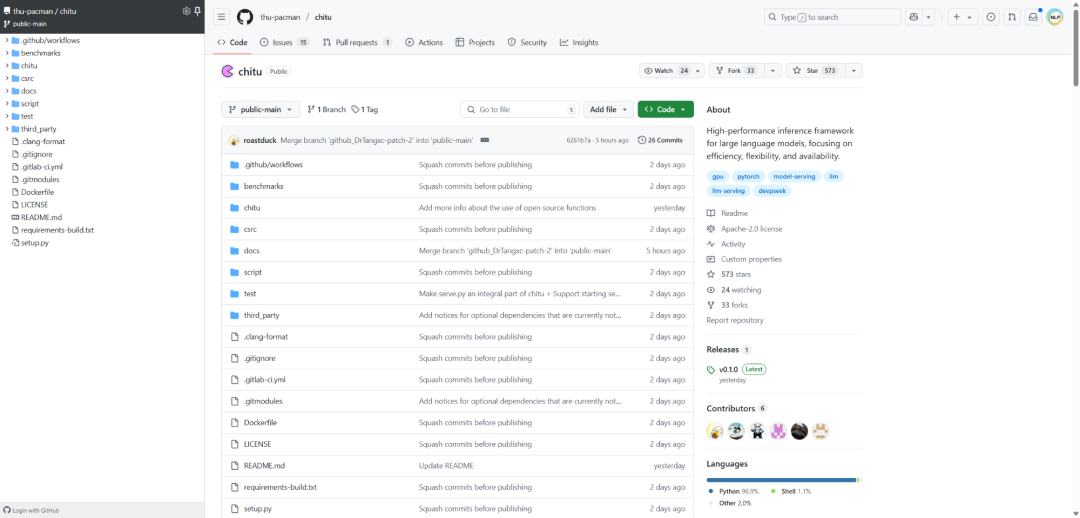

清华团队刚刚放出了模型推理引擎:赤兔Chitu,DeepSeek推理成本降一半,性能翻番。在A800 集群上,用赤兔引擎部署DeepSeek-671B满血版推理服务,比vLLM部署方案,GPU数量不仅减少了50%,输出速度提升了3.15倍。支持NVIDIA最新旗舰到旧款的多系列产品,也支持国产芯片优化。纯CPU部署、单GPU部署、大规模集群部署,都提供可扩展的解决方案。可应用于实际生产环境,稳定性可承载并发业务流量。

参考文献:

[1] github:https://github.com/thu-pacman/chitu/tree/public-main

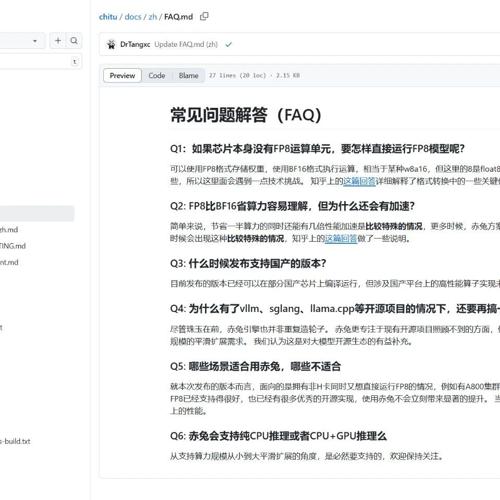

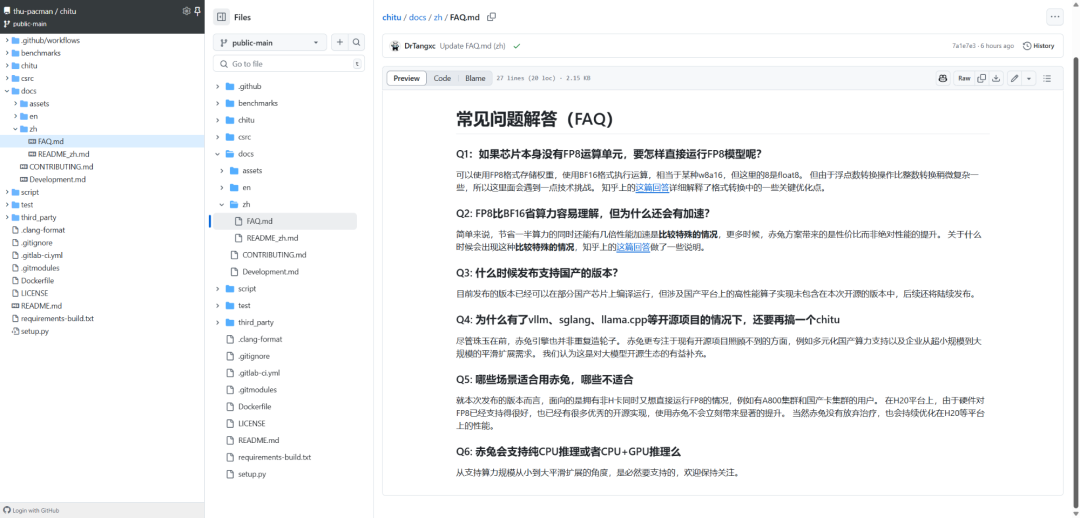

[2] https://github.com/thu-pacman/chitu/blob/public-main/docs/zh/FAQ.md

(文:NLP工程化)