vLLM

华为昇腾推理对决:开源vLLM vs 官方MindIE,数据说话「Qwen与DeepSeek推理实测」

表现良好的 MindIE 推理引擎

,并原生支持 Atlas 800 A2 系列和 Atlas 30

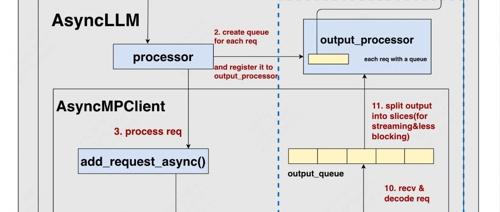

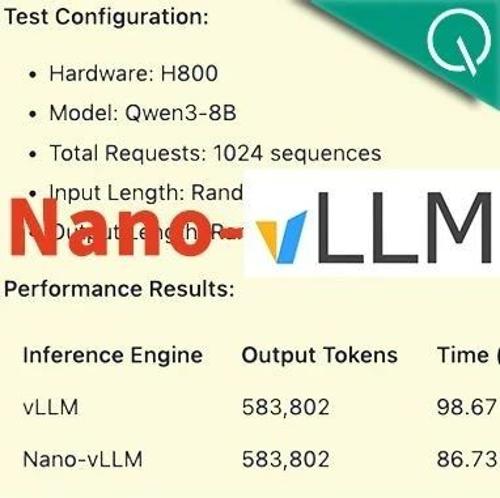

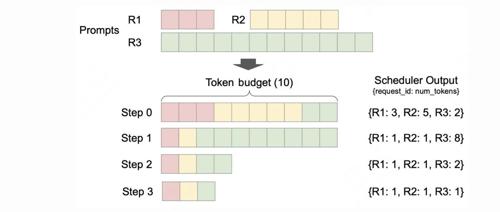

DeepSeek研究员1200行代码复刻vLLM,H800硬件实测性能反超原版

仅用不到1200行代码实现Nano-vLLM,该项目由DeepSeek研究员俞星凯创作。Nano-vLLM有三大特点:快速离线推理、可读性强的代码库以及优化套件。通过比较vLLM与Nano-vLLM在不同硬件和模型配置下的基准测试结果,Nano-vLLM表现出色。

vLLM Ascend超越MindIE? 昇腾推理Qwen3与DeepSeek R1 Distill性能实测

表现良好的 MindIE 推理引擎

,并原生支持 Atlas 800 A2 系列和 Atlas 30

爆!三大热门大型模型服务方案实测:VLLM、LLaMA.cpp、SGLang 谁才是你的最强生产力引擎?

文章介绍了三种当前流行的大型语言模型(LLM)和服务方案:VLLM、LLaMA.cpp HTTP Server 和 SGLang。VLLM 以其高性能和快速响应著称;LLaMA.cpp 是一个轻量级的本地部署选项,适合没有高端 GPU 的用户;SGLang 则是一个智能框架,支持多步骤推理和函数调用,适合需要自定义 DSL 的场景。文章详细比较了每种方案的特点、优点及适用场景,并提醒了各自可能遇到的问题。