SGLang

SGLang 推理引擎的技术要点与部署实践|AICon 北京站前瞻

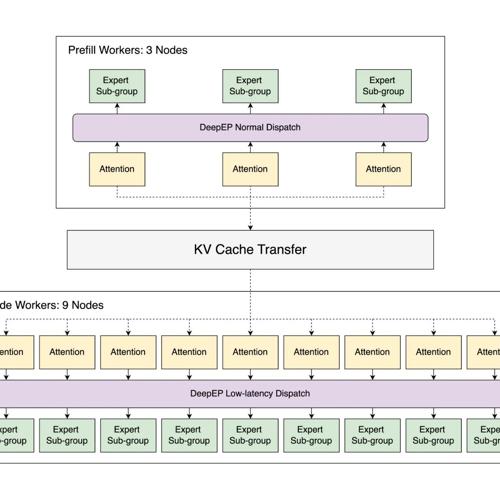

SGLang 是一个备受瞩目的开源推理引擎,在 GitHub 上已有近 15K 星星和月均 10 万次下载。尹良升分享了 SGLang 的关键技术和优化,包括 PD 分离、推测解码和 KV 缓存落盘等技术,帮助平衡性能、资源利用率和成本,并强调开源社区对于推动技术演进和应用落地的重要性。

爆!三大热门大型模型服务方案实测:VLLM、LLaMA.cpp、SGLang 谁才是你的最强生产力引擎?

文章介绍了三种当前流行的大型语言模型(LLM)和服务方案:VLLM、LLaMA.cpp HTTP Server 和 SGLang。VLLM 以其高性能和快速响应著称;LLaMA.cpp 是一个轻量级的本地部署选项,适合没有高端 GPU 的用户;SGLang 则是一个智能框架,支持多步骤推理和函数调用,适合需要自定义 DSL 的场景。文章详细比较了每种方案的特点、优点及适用场景,并提醒了各自可能遇到的问题。

让DeepSeek模型变更强!SGLang团队将吞吐量提高5倍,API成本降到官方五分之一

SGLang团队在开源技术博客中介绍了如何优化DeepSeek模型,在96个H100 GPU上实现了显著性能提升。通过引入PD分解、TBO以及专家重新平衡等策略,提高了预填充和解码阶段的吞吐量,并减少了不平衡现象对性能的影响。