PyTorch

从 0 手撕 LLM 分布式训练:DP, ZeRO, TP, PP, CP, EP

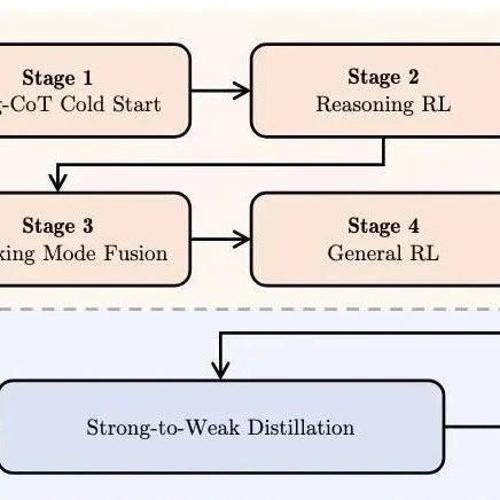

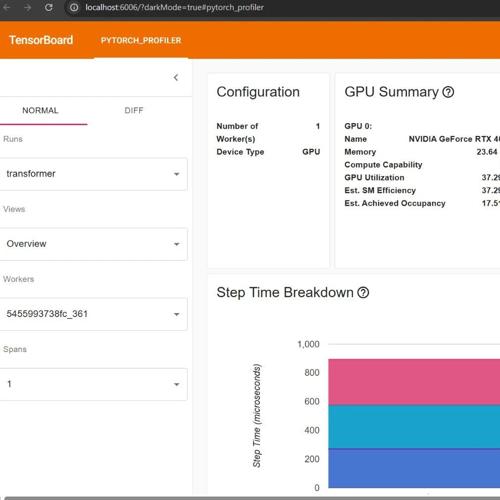

小冬瓜AIGC发布的X-R1开源框架课程,手撕PyTorch的五大并行算法DP、TP、PP、CP、EP,并实现分布式训练中的关键算法如Backward和MoE。该课程包含实操项目及多个测评工具,适合对LLM技术有兴趣的学员。

难度爆表!从 LLM 到 Infra,手撕 5 大并行训练算法

现高校LLM对齐研究课程介绍,涵盖手撕PyTorch五大并行算法DP、TP、PP、CP和EP,以及Backward梯度计算与重叠通信技术。课程内容丰富,提供多卡DeepSpeed RLHF训练及垂域大模型实操项目。

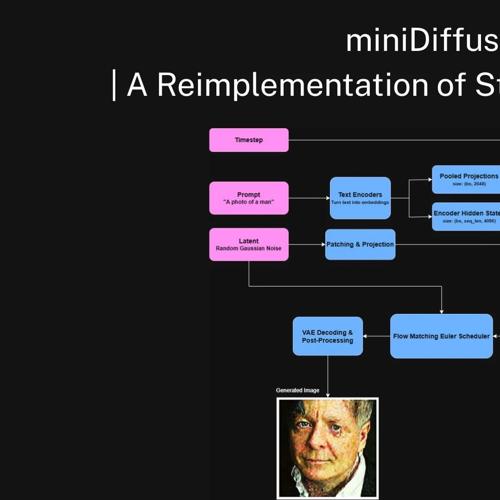

miniDiffusion,一个用PyTorch重新实现的Stable Diffusion 3.5

miniDiffusion是用PyTorch实现的Stable Diffusion 3.5项目,包含核心组件和训练/推理脚本,用于教育和实验目的。

在线教程丨获CVPR 2025最佳论文,通用3D视觉模型VGGT推理速度可达秒级

HyperAI超神经官网上线VGGT教程版块,支持一键部署体验基于纯前馈Transformer架构的通用3D视觉模型。该模型能够从多个视角推断场景三维属性,并在多种三维任务中达到SOTA级别表现。