新智元报道

新智元报道

【新智元导读】刚刚,一位AI公司CEO细细扒皮了关于Llama 4的五大疑点。甚至有圈内人表示,Llama 4证明Scaling已经结束了,LLM并不能可靠推理。但更可怕的事,就是全球的AI进步恐将彻底停滞。

令人失望的Llama 4,只是前奏而已。

接下来我们恐将看到——全球局势的改变,将彻底阻止AI进步!

最近,一位AI CEO做出长视频,逐级对Llama 4身上的六大疑点进行了扒皮。

同时,NYU教授马库斯发出博客,总结了目前这段时间AI圈的状况。

Scaling已经结束;模型仍然无法可靠推理;金融泡沫正在破裂;依然没有GPT-5;对不可靠的语言模型的过度依赖让世界陷入了困境。我的25个2025年预测中的每一个,目前看起来都是对的。

大语言模型不是解决之道。我们确实需要一些更可靠的方法。

OpenAI和Anthropic这样的公司,需要筹集资金来资助新模型本后的大规模训练运行,但他们的银行帐户里并没有400亿或1000亿美元,来支撑庞大的数据中心和其他费用。

问题在于,如果投资者预见到了经济衰退,那就要么不会投资,要么投资较少。

更少的资金,就意味着更少的计算,也就是更慢的AI进展。

布鲁金斯学会2025年的一份报告称,若科研成本持续上升,美国在人工智能、生物技术和量子计算等关键领域的领先地位可能受到威胁。据估算,当前政策若持续实施五年,美国科研产出可能会下降8%-12%。

在以前的一个采访里,Anthropic CEO Dario曾被问到:到了如今这个阶段,还有什么可以阻止AI的进步?他提到了一种可能——战争。

没想到,在这个可能性之外,我们居然提前见证了系统的另一种混沌。

而Dario也提前预测到,如果出现「技术不会向前发展」的信念,资本化不足,AI进步就将停止。

最近闹出大丑闻的Llama 4,已经证明了这一点。

我们很难说,Llama 4系列三款模型中的两款代表了多少进展,显然在这个系列的发布中,夸大宣传的水分要比诚实的分析多得多。

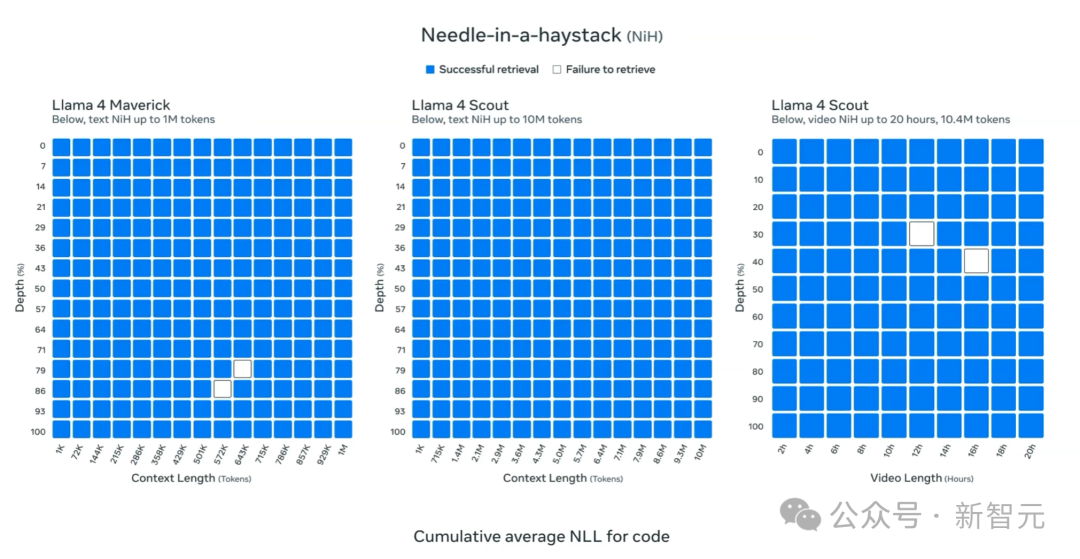

Llama拥有所谓业界领先的一千万个token的上下文窗口,听起来似乎很酷炫。

可是等等,24年2月,Gemini 1.5 Pro的模型,就已经达到1000万token的上下文了!

在极端情况下,它可以在视频、音频和共同文本上,执行惊人的大海捞针任务,或许,是谷歌忽然意识到,大海捞针任务意义非常重大。

正如这篇Llama 4博客所说,如果把所有哈利波特的书都放进去,模型都能检索到放入其中的一个密码。

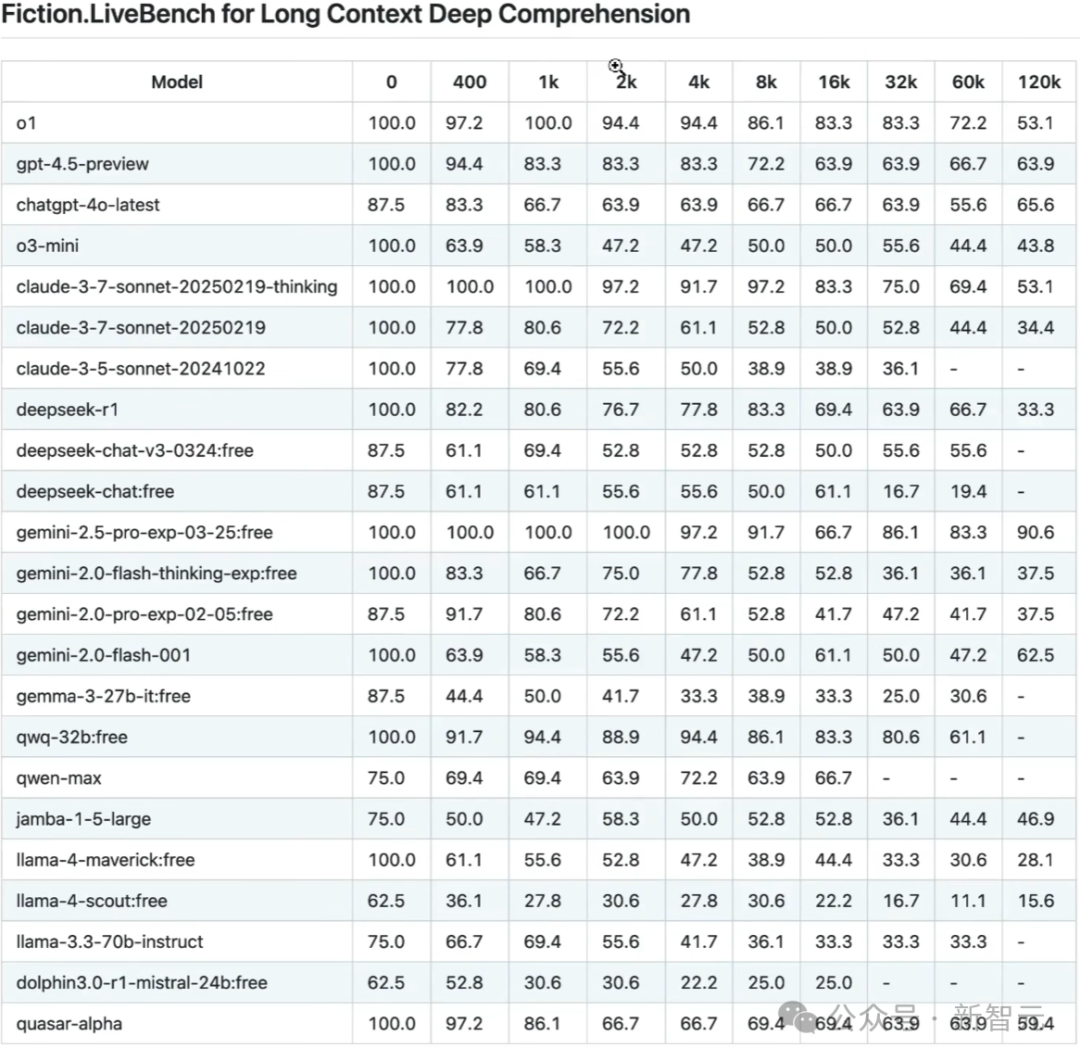

不过,这位CEO表示,这些48h前发布的结果,不如24小时前更新的这个fiction livebench基准测试这么重要。

这个基准测试,用于长上下文的深度理解,LLM必须将数万或数十万个token或单词拼凑在一起。

在这里,在这个基准测试中,Gemini 2.5 Pro的表现非常好,而相比之下,Llama 4的中等模型和小模型,性能极其糟糕。

而且随着token长度的增加,它们的表现越来越差。

这位CEO察觉到的第二大疑点就在于,Llama 4为何选在周六发布?

在整个美国AI技术圈里,这个发布日期都是史无前例的。

如果阴谋论一点想,之所以选在周六发布,是因为Meta自己也心虚了,希望尽量减少人们的注意力。

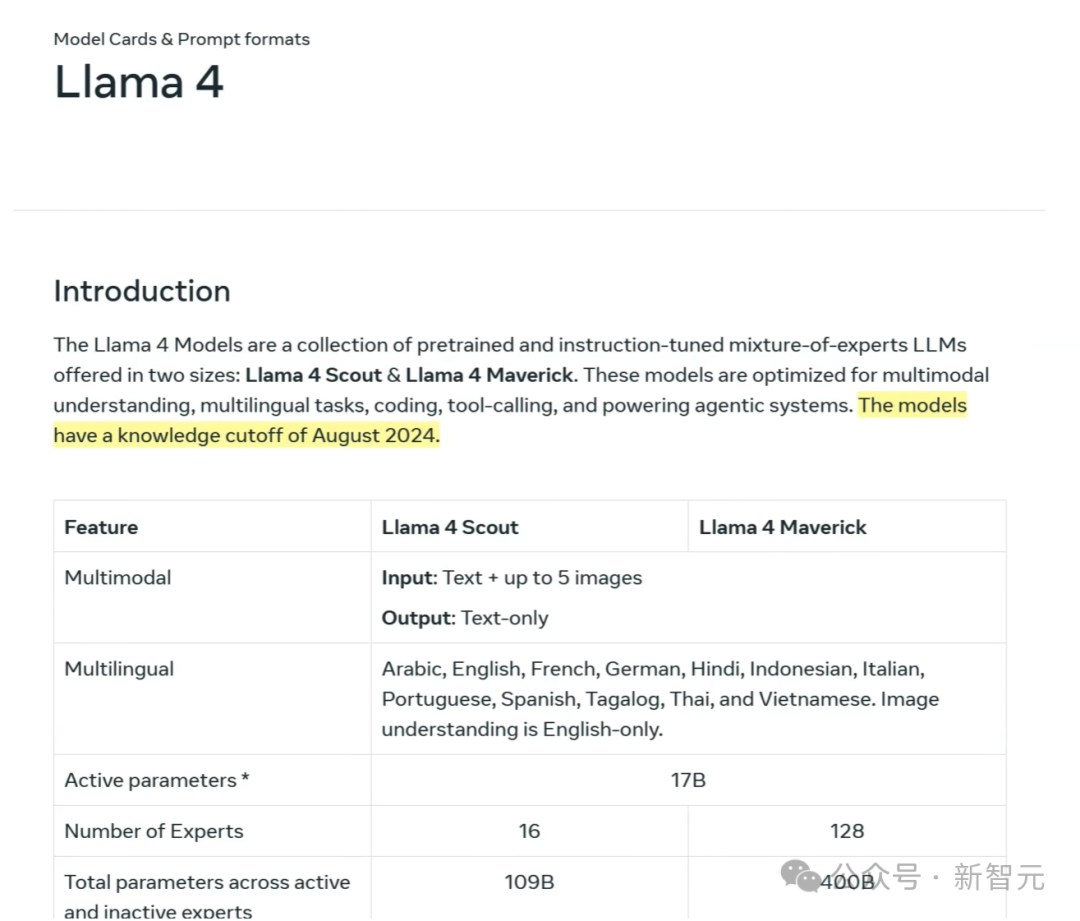

此外,Llama 4的最新训练数据截止时间是2024年8月,这就很奇怪。

要知道,Gemini 2.5的训练知识截止时间是2025年1月。

这就意味着,在过去的9个月里,Meta一直在使尽浑身解数,拼命让这个模型达到标准。

有一种可能性是,或许他们本打算早点发布Llama 4,但就在9月,OpenAI推出了o系列模型,今年1月,DeepSeek R1又来了,所以Meta的所有计划都被打乱了。

不过,这位CEO也承认,尽管全网充斥着对Llama 4群嘲的声音,但它的确也展示出了一些坚实的进展。

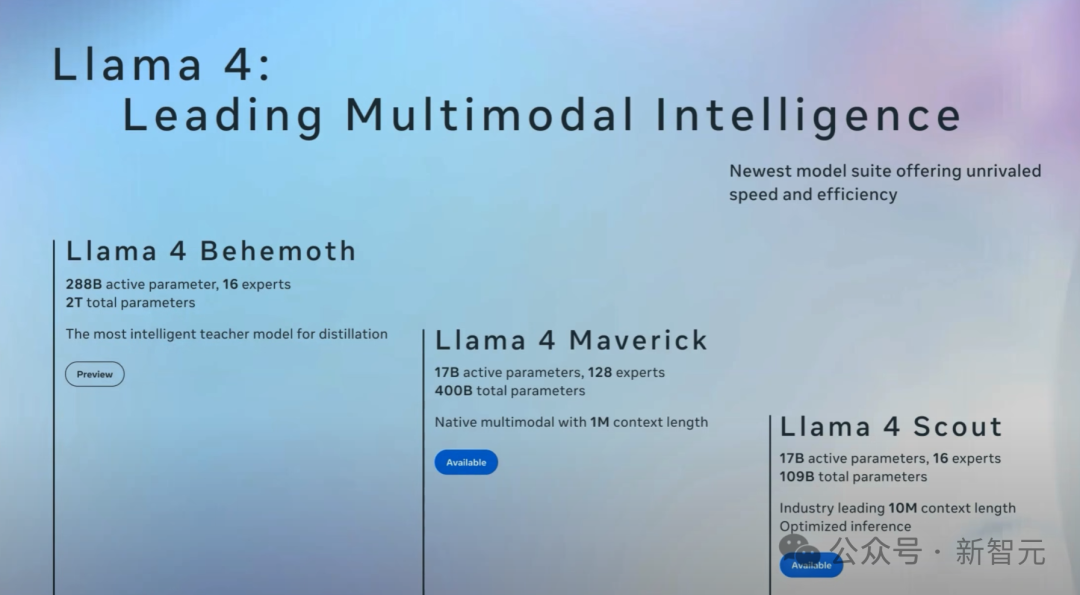

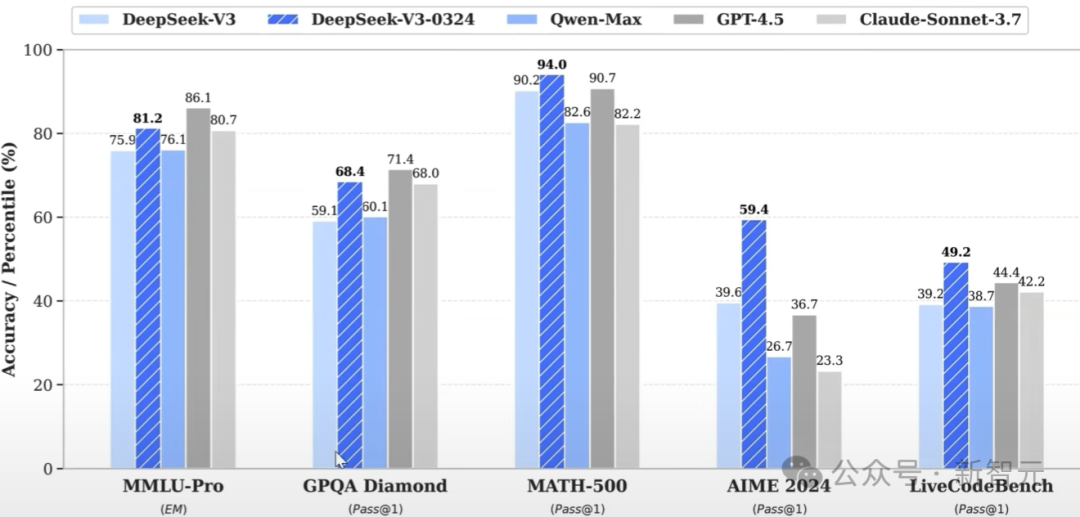

比如Llama 4 Maverick的活动参数量大概只有DeepSeek V3的一半,却取得了相当的性能。

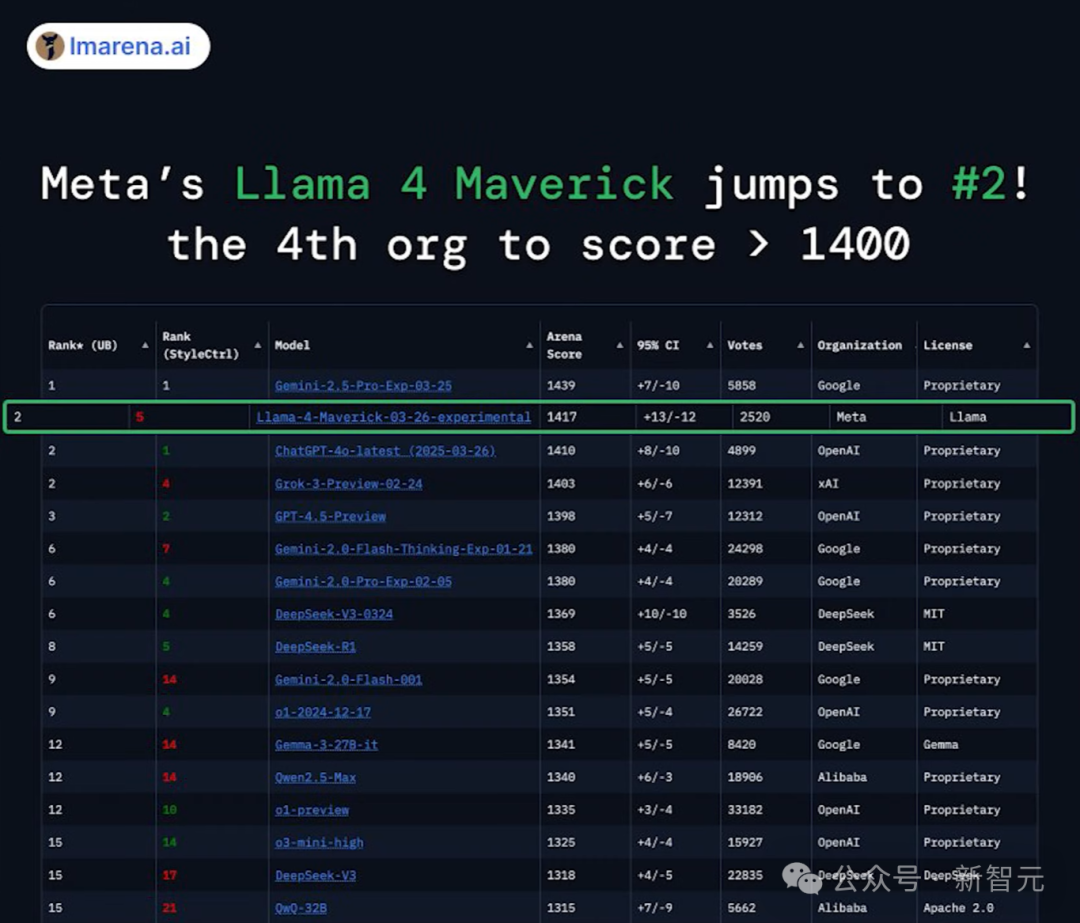

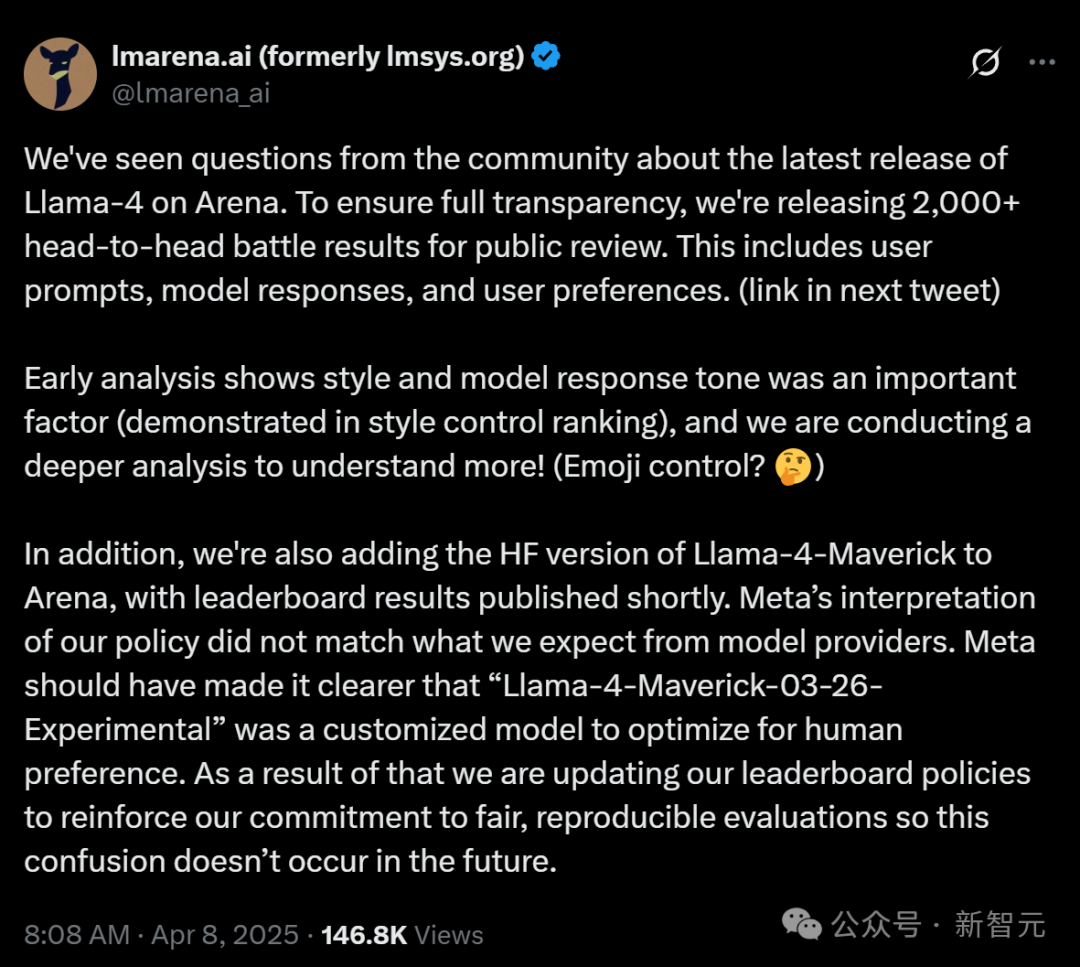

那现在的核心问题就在于,Meta究竟有没有在LM Arena上进行作弊,在测试集上进行训练?

目前,LM Arena已经迅速滑跪,公开了2000多组对战数据给公众检阅,并且表示会重新评估排行榜。

目前姑且按照没有算,那就意味着我们拥有一个强大得惊人的基础模型了。

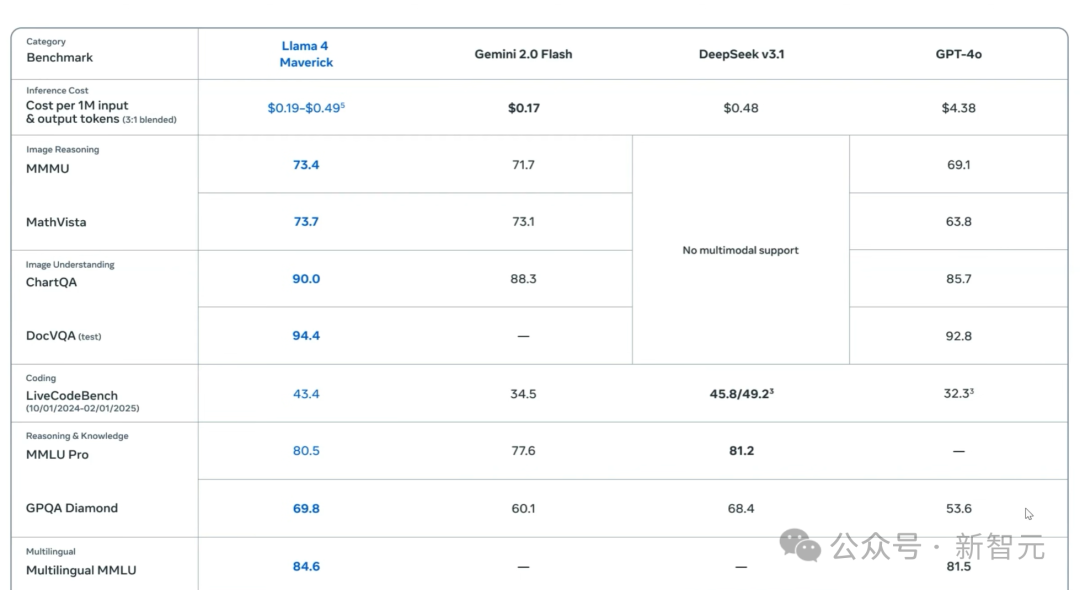

看看这些真实数字,假设没有任何答案进入Llama 4的训练数据,这个模型在GPQA Diamond上的性能(谷歌验证的极其严格的STEM基准测试)实际上是比DeepSeek V3更好的

而在这个基础上,Meta就完全可以创建一个SOTA级别的思维模型。

唯一的问题是,Gemini 2.5 Pro已经存在了,而DeepSeek R2也随时会问世。

还有一点,当Llama 4走出舒适区时,性能就会开始狂降。

以ADA的Polyglot这个编码基准测试为例,它测验了一些系列编程语言的性能。

但与许多基准不同,它不仅仅关注Python,而是一系列编程语言,现在依然是Gemini 2.5 Pro名列前茅。

但是想要找到Llama 4 Maverick,可就很难了,得把鼠标滚动很久。

它的得分当然惨不忍睹——只有15.6%。

这就跟小扎的言论出入很大了,显得相当讽刺。

就在不久前,他还信誓旦旦地断定说,Meta的AI模型将很快取代中级程序员。

这一点,同样已经在AI社区引发了群嘲。

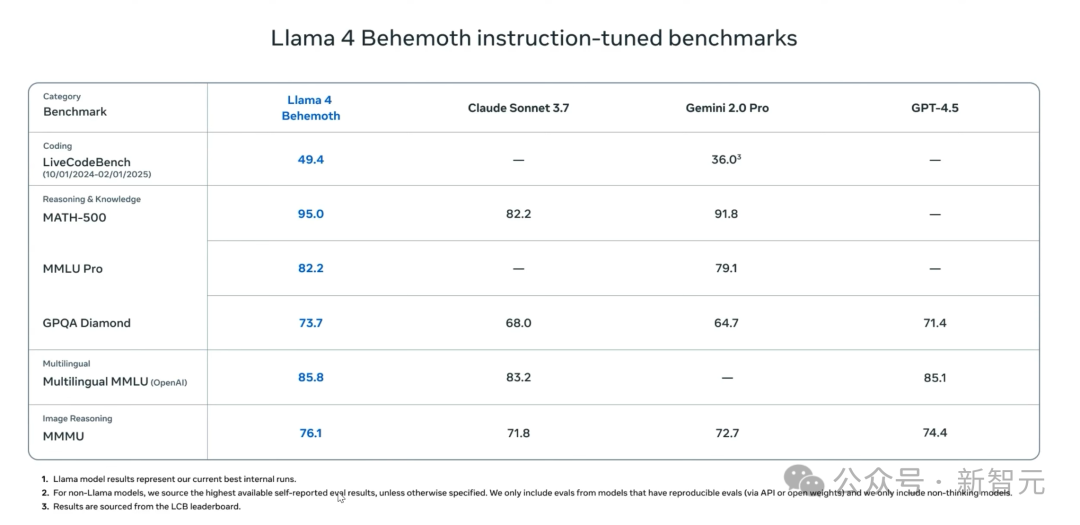

在下面这个表格中,Meta将Llama 4和Gemini2.0 Pro、GPT-4.5等模型进行了比较,数字非常漂亮。

但仔细看脚注,却说的是Llama模型的结果代表了目前最好的内部运行情况,所以很大可能是,Meta把Llama 4跑了5遍或10遍,取了其中的最好结果。

而且,他们还故意不将Llama 4 Behemoth跟DeepSeek V3进行比较,后者比它在整体参数上小三倍,在互动参数上小八倍,性能却相似。

如果从消极的角度下判断,就可以说Llama 4最大的模型参数上DeepSeek V3基础模型的许多倍,性能却基本处于同一水平。

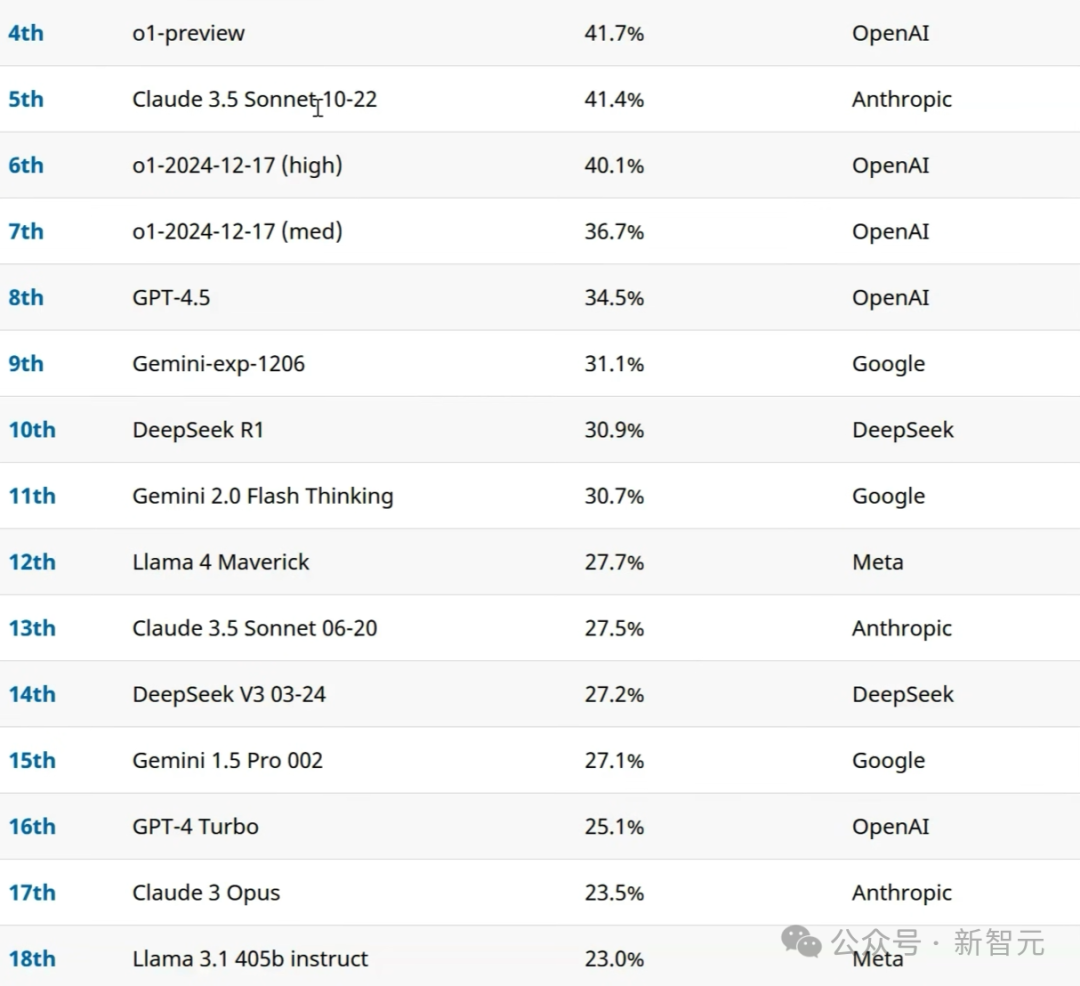

还有在Simple Bench中,Llama 4 Maverick的得分大概为27.7%,跟DeepSeek V3处于同一水平,还低于Claude 3.5 Sonnet这类非思维模型。

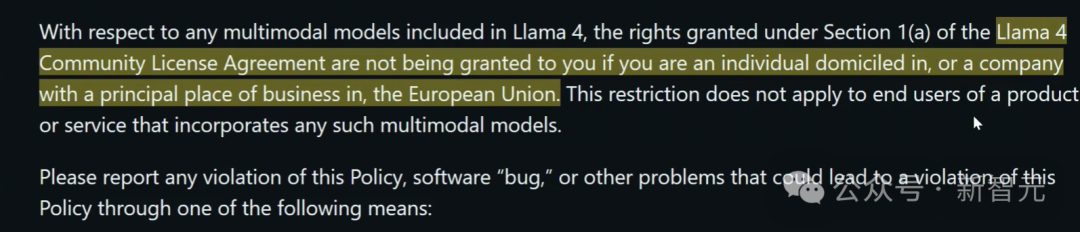

另外,这位CEO还在Llama 4的使用条款中发现了这么一条。

如果你在欧洲,仍然可以成为它的最终用户,但却没有权利在它的基础上进行构建模型。

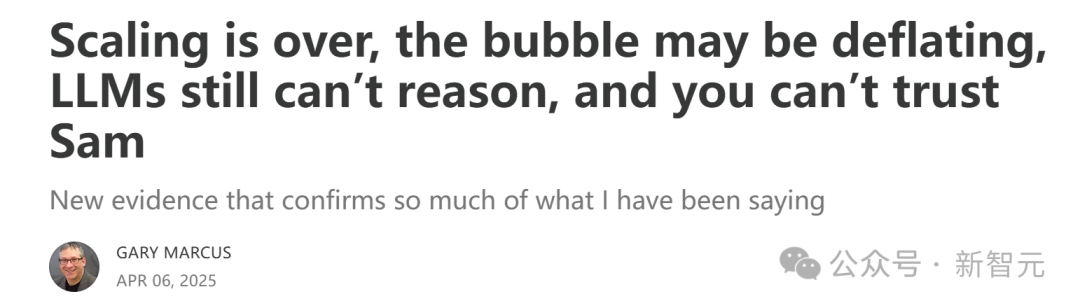

而Llama 4的惨淡表现,也让NYU教授马库斯写出长文,断言Scaling已经结束,LLM仍然无法推理。

他的主要观点如下。

大模型的Scaling已经彻底结束了,这证实了我三年前在《深度学习正在撞墙》中的预测。

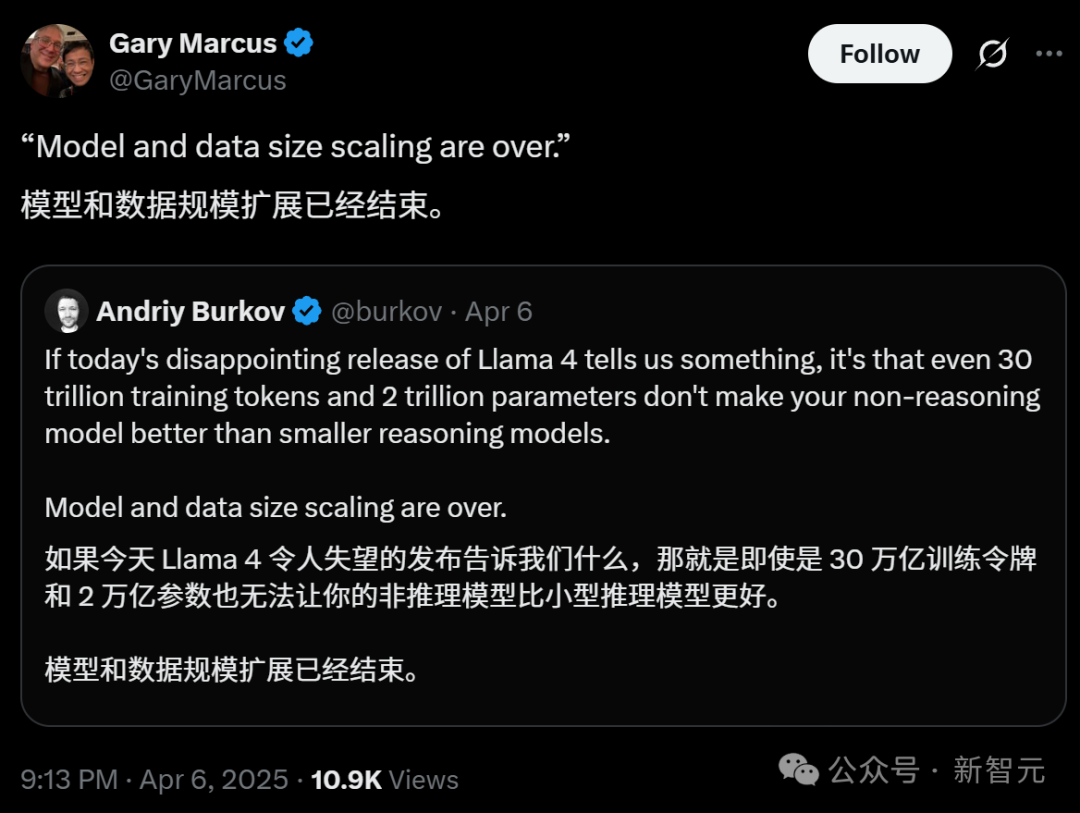

一位AI博士这样写道:Llama 4的发布已经证实,即使30万亿token和2万亿参数,也不能让非推理模型比小型推理模型更好。

规模化并不奏效,真正的智能需要的是意图,而意图需要远见,这都不是AI能做到的。

即使LLM偶尔能提供正确的答案,往往也是通过模式识别或启发式的捷径,而非真正的数学推理。

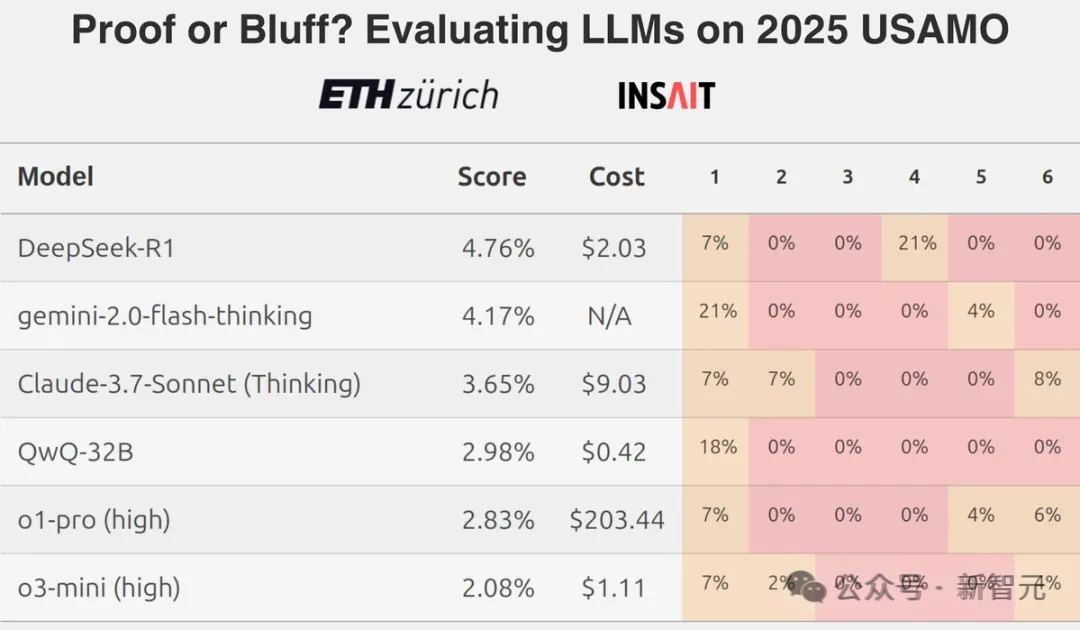

比如最近ETU团队关于LLM在美国奥数上糟糕表现的研究,就彻底击碎了「LLM会做数学题」这个神话。

最终,生成式AI很可能会变成一个在经济回报上失败的产品。

泡沫可能真的要破灭了。英伟达在2025年的跌幅,就已经超过了三分之一。

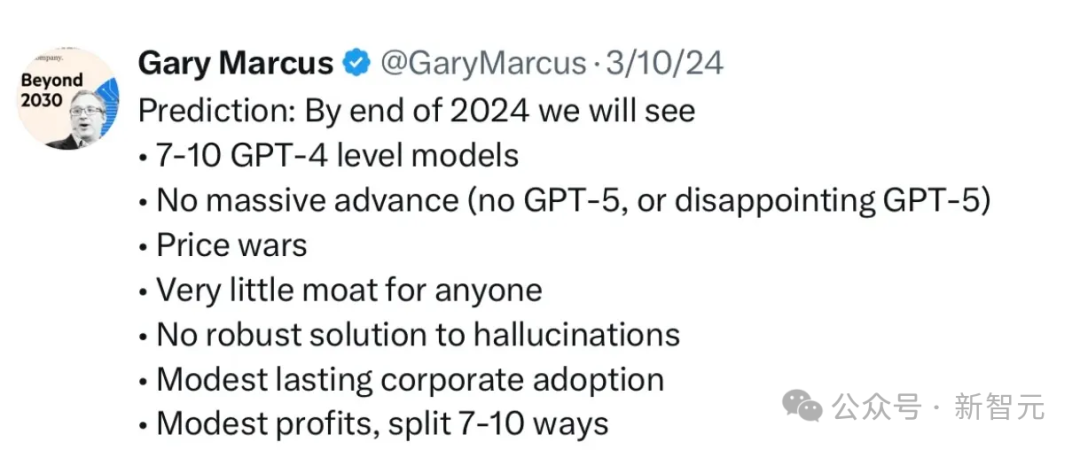

而Meta的Llama 4的残酷真相,再次证实了马库斯在2024年3月预测——

达到GPT-5级别的模型,将会非常困难。很多公司都会有类似模型,但没有护城河。随着价格战进一步升级,许多只会有微薄的利润。

最终,马库斯以这样的方式总结了自己的发言——

「大语言模型绝对不是解决之道,我们需要一些更可靠的方法。Gary Marcus正在寻找对开发更可靠替代方法有兴趣的投资者。 」

(文:新智元)