跳至内容

MLNLP社区是国内外知名的机器学习与自然语言处理社区,受众覆盖国内外NLP硕博生、高校老师以及企业研究人员。

社区的愿景是促进国内外自然语言处理,机器学习学术界、产业界和广大爱好者之间的交流和进步,特别是初学者同学们的进步。

Llama 4是Meta AI推出的新一代开源大模型,是Llama系列的第四代。

下面将结合现有Llama系列(主要是Llama 3和Llama 3.1)的架构演进、行业趋势以及DeepSeek的架构,对Llama 4的架构进行深入分析。(对于deepseek的深入分析可以看我们的其他文章)

Llama 4整体情况介绍

Llama系列自Meta AI推出以来,以其高效性、开源性和不错的表现在学术界和工业界广受关注。从Llama 1到Llama 3,我们见证了模型在规模、训练数据质量和应用场景上的持续优化。而Llama 4的到来,标志着这一系列在多模态能力和计算效率上的又一次飞跃。当然Llama再怎么蹦跶,目前在中文领域还难以超过deepseek。

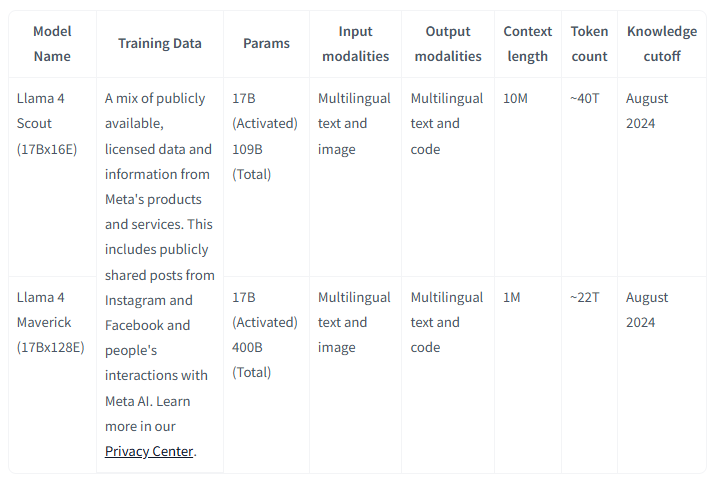

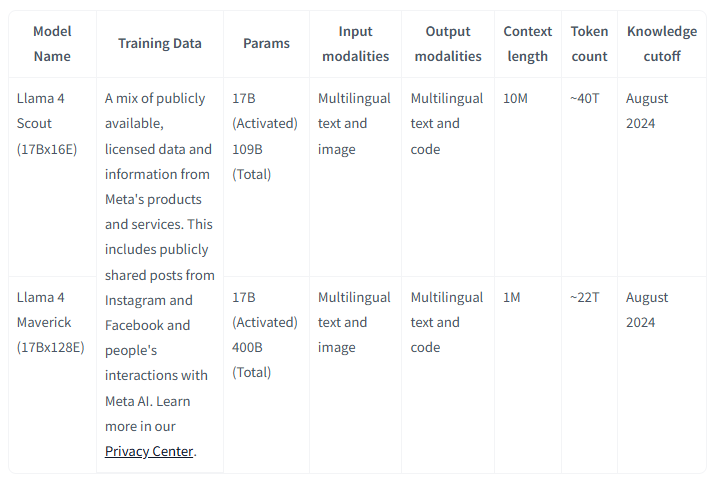

根据目前互联网上的信息,Llama 4在2025年4月正式发布,并推出了三个不同规模的模型版本,前两个都比deepseek V3/R1小一些:

•Llama 4 Scout: 激活参数170亿,总参数109B,16个专家,支持高达1000万(10M)token的超长上下文窗口。可在INT4模式下在单个H100 GPU上部署。

•Llama 4 Maverick: 激活参数170亿(17B),总参数400B,128个专家,性能进一步提升。专家数少于DeepSeek V3的256,但在某些基准测试上与DeepSeek V3相当。上下文长度为 256K。

•Llama 4 Behemoth: 仍在训练中,激活参数288B,16个专家,总参数2万亿,目标是超越当前的闭源顶尖模型如Gemini 2.5 Pro和GPT-4.5。

Llama 4 Scout与Maverick概况(来源:huggingface)

不仅限于文本输入,还支持图像等多模态(注意,这里是多模态还不是混合模态)数据处理,这使其在实际应用中(如企业知识管理和多语言写作)更具潜力。

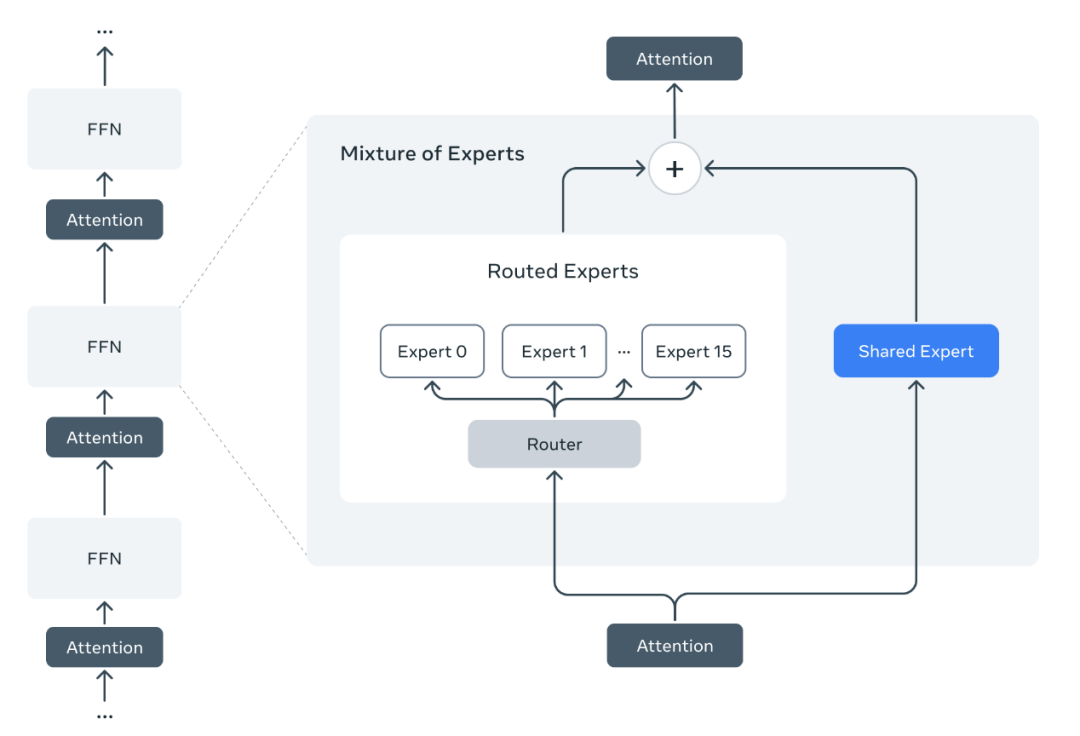

混合专家模型(Mixture of Experts, MoE)成为Llama 4的核心设计,显著提高了计算效率和性能。这使得Llama 4也成为第一个开源的主流的多模态MoE大模型。

Scout版本的1000万token上下文长度领先于行业主流,预计将为长文档处理、复杂任务提供了强大支持,并为后继更强的推理(Reasoning)能力预留long context空间。有意思的是Maverick反而缩短到256K(deepseek V3的2倍)。

根据X(推)上的讨论,Llama 4在部分基准测试中已超过DeepSeek V3,成为开源模型的新一代国外霸主。

然而,值得注意的是,Llama 4在多语言训练中似乎对中文支持不足(估计是缺乏中文训练数据),这可能限制其在中文场景下的表现。

由于Llama 4并非推理(Reasoning)模型,所以这里我们主要以DeepSeek V3来与Llama 4对比。DeepSeek V3以数学、代码和中文能力见长,训练成本低至600万美元,而Llama 4则更注重多模态和超长上下文。由于单次激活的专家参数量更少,这也意味着Llama 4的单次计算成本更低。根据X上的反馈,Llama 4 Maverick在前端界面生成等任务中效果不如DeepSeek V3(2024年3月版),但优于DeepSeek V3的上一代。这表明Llama 4在多功能与多模态上占优,但在特定领域(如文本生成和推理)可能尚未超越DeepSeek V3。

Llama 4架构深入分析与信息补全

以下分析基于Llama系列的演进逻辑、MoE架构的典型特征以及行业前沿趋势,实际情况应以官方发布为准。

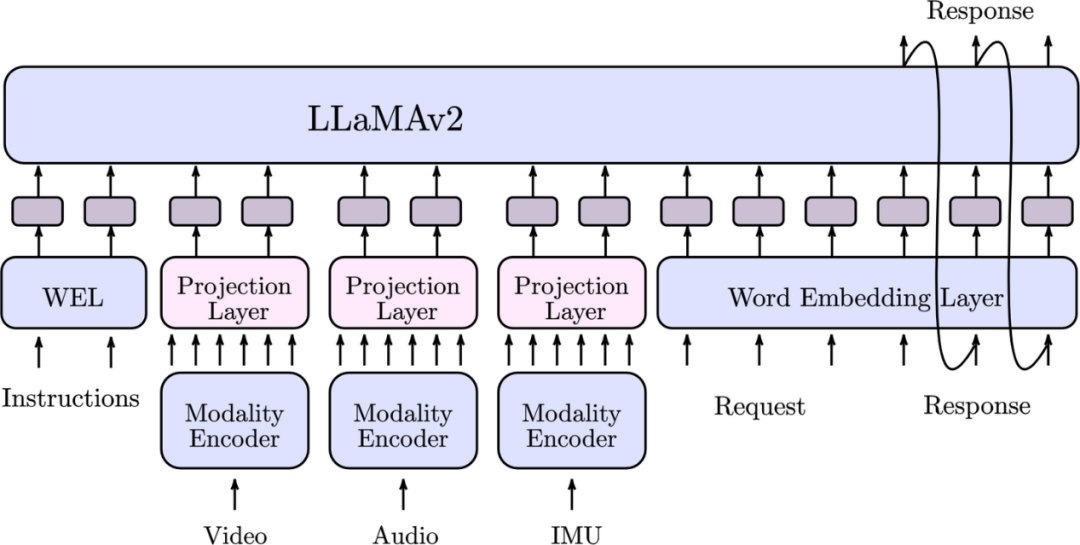

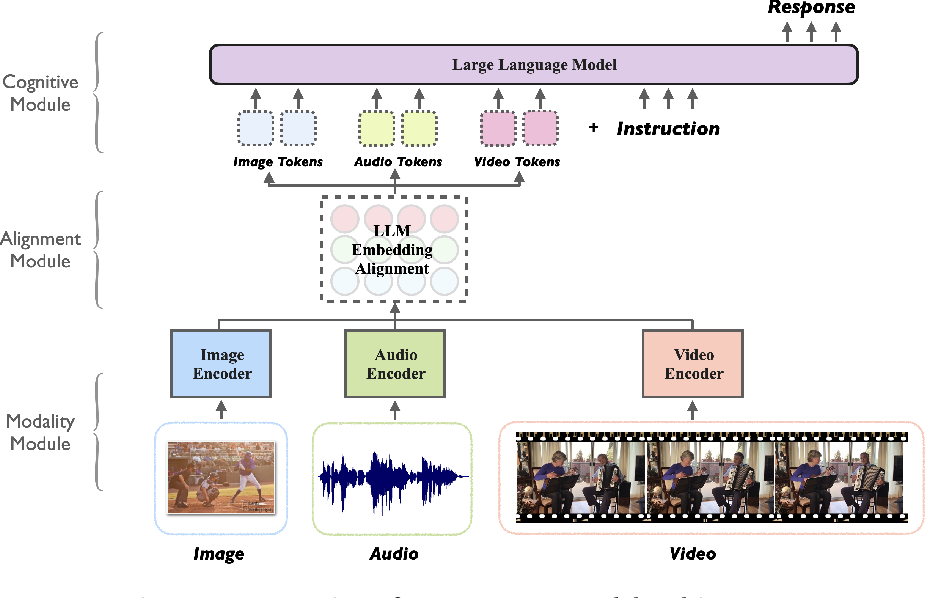

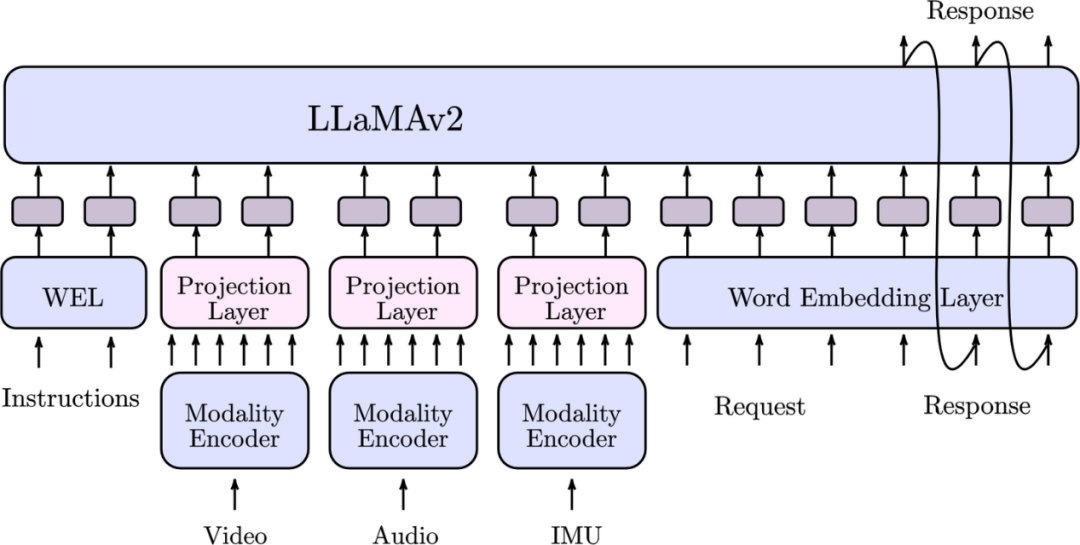

典型的多模态大模型基本架构(来源:腾讯AI Lab)

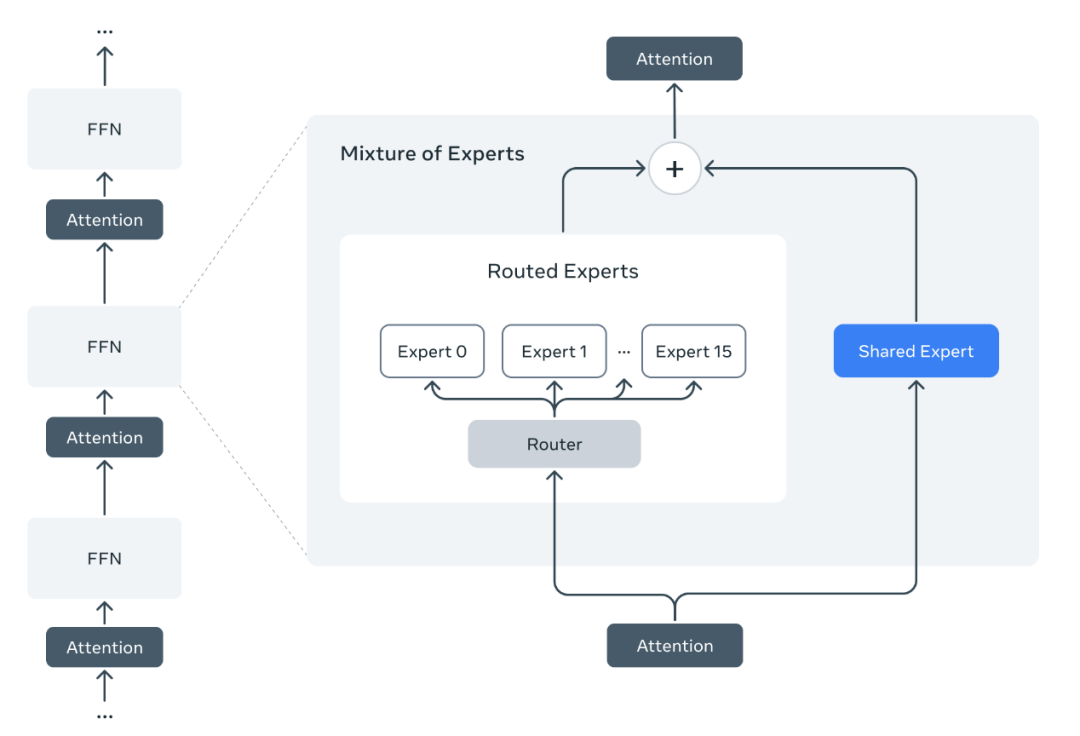

Llama 4全面转向MoE架构,这与Llama 3坚持密集模型(Dense Model)形成鲜明对比。MoE的核心思想是通过稀疏激活机制,在大规模参数中仅激活部分“专家”来处理特定任务,从而在保持高性能的同时降低计算成本。

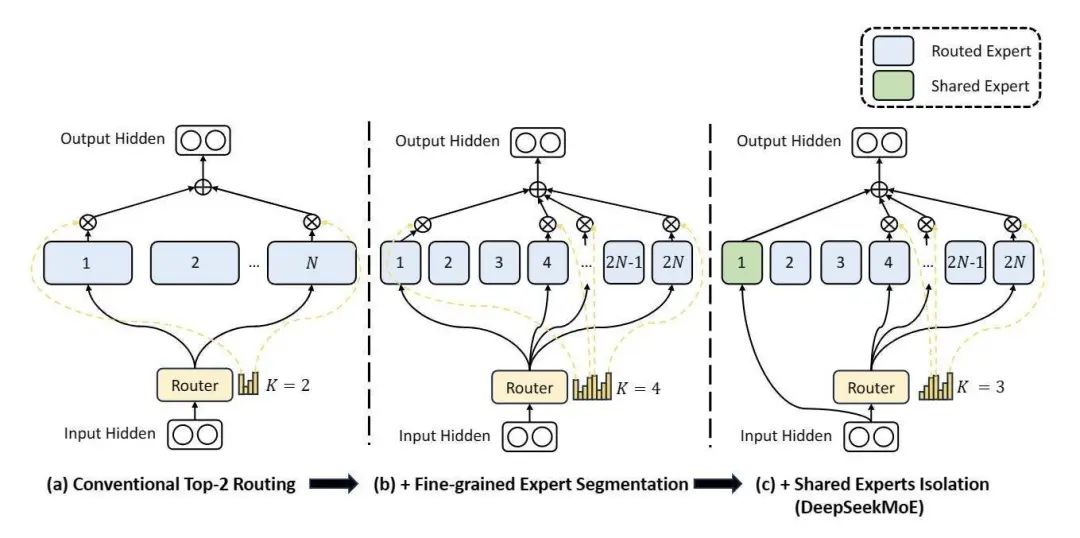

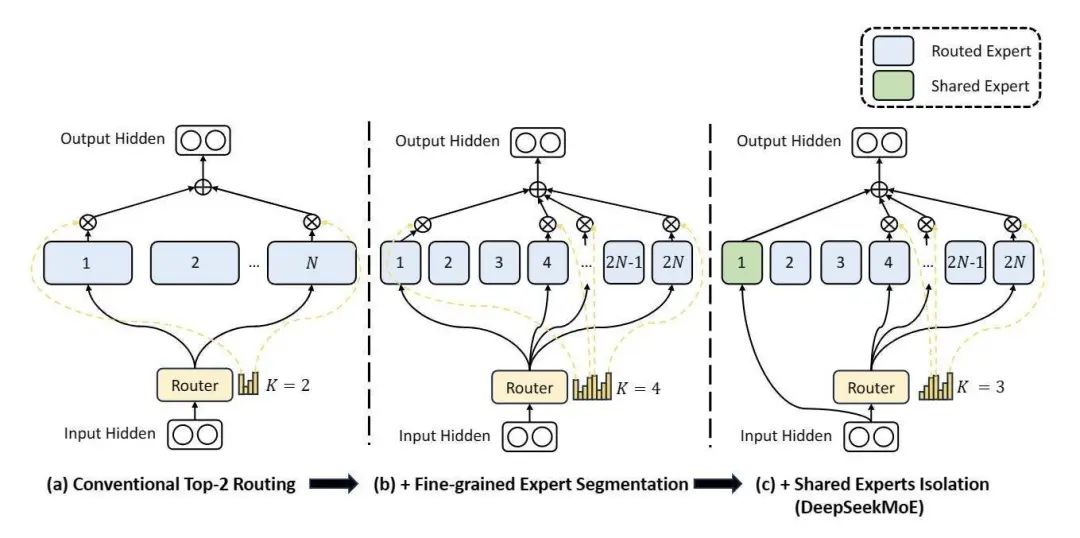

•专家数量与参数分布: Meta在专家数量和单专家规模之间进行了权衡,小型模型倾向于更小的专家,而大模型使用了更大的专家规模。目前看来使用了共享专家模式,大概率与DeepSeekMoE类似。

•路由机制: MoE的关键在于如何将输入分配给合适的专家。Llama 4沿用了类似DeepSeek或Mixtral的动态路由策略,通过一个门控网络(Gating Network)根据输入特征选择激活哪些专家。这种稀疏性使得模型在推理时仅需计算一小部分参数,显著降低了能耗和延迟。

•多模态支持: MoE架构天然适合多模态任务。不排除Llama 4可能为不同模态(文本、图像等)设计了与MetaClip协作专用专家,例如文本专家负责语言生成,视觉专家处理图像特征提取。这种分工协作的方式既提高了效率,也增强了模型对复杂输入的适应性。

DeepSeekMoE与传统的多路由和细粒度专家MoE对比(来源:DeepSeek)

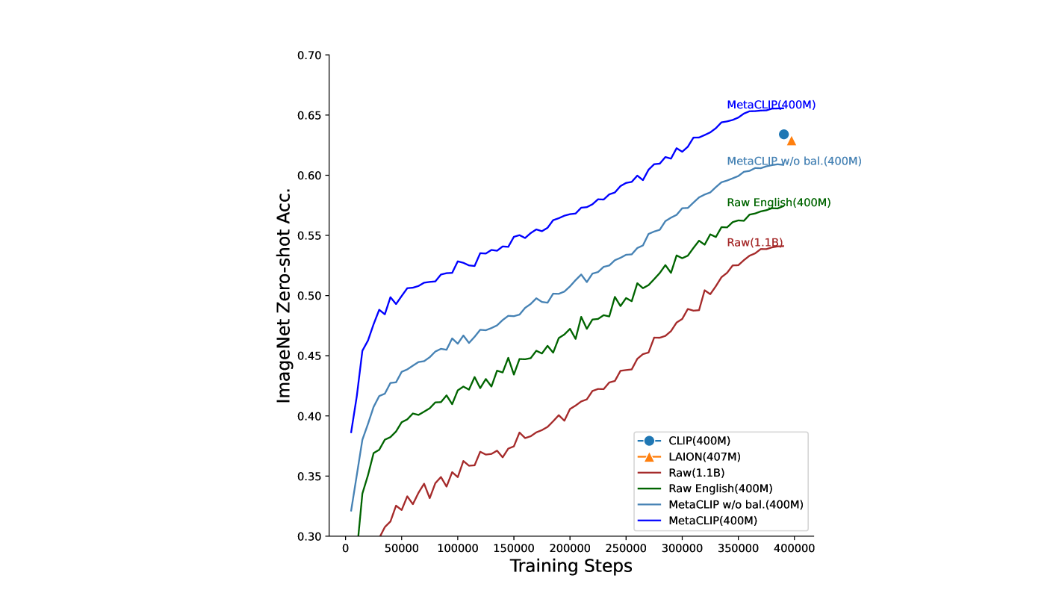

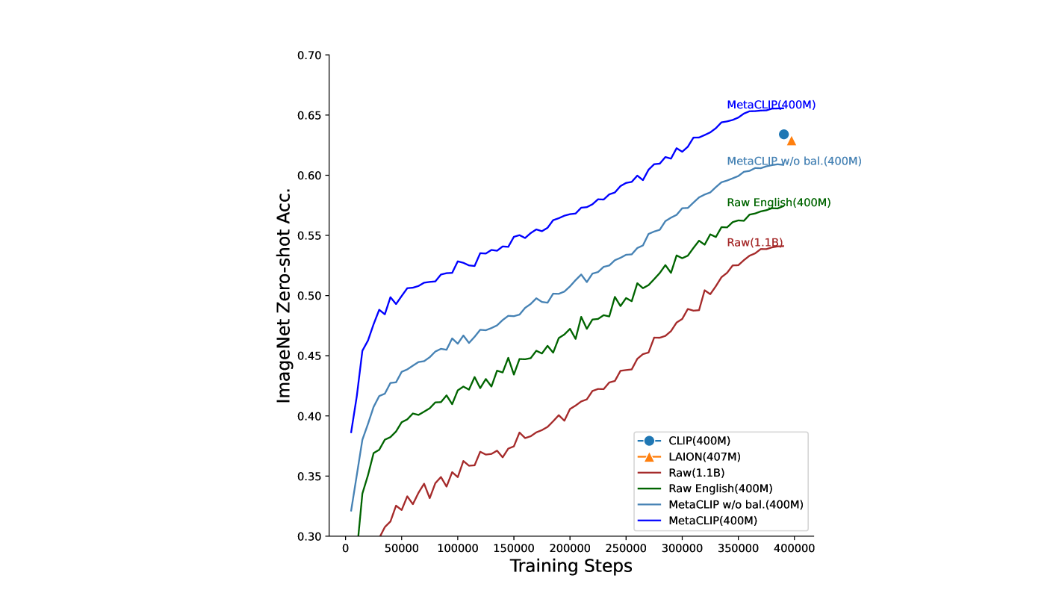

MetaCLIP(Metadata-Curated Language-Image Pre-training)是由Meta AI开发的一种先进的语言-图像预训练模型,旨在提升CLIP(Contrastive Language-Image Pre-training)的性能,主要通过优化数据筛选和训练过程实现。MetaCLIP的主要优化在于数据策展(data curation,大白话就是优化了训练数据集)。与OpenAI的CLIP相比,MetaCLIP并不依赖复杂的模型架构调整,而是通过改进训练数据的质量和分布来提升性能。

MetaCLIP 采用原始数据池和元数据(源自 CLIP 的概念),对数据进行筛选和平衡,确保训练数据集在语义分布上更加均匀和高质量。MetaCLIP 应用于具有 400M 图像-文本数据对的 CommonCrawl 在多个标准基准测试中优于 CLIP 的数据 。在零样本 ImageNet 分类中,MetaCLIP 的准确率达到 70.8%,超过了 ViT-B 模型上的 CLIP 的 68.3%。

Llama系列一直基于Transformer解码器架构(Decoder-only),Llama 4预计延续这一传统,但在以下方面进行了优化:

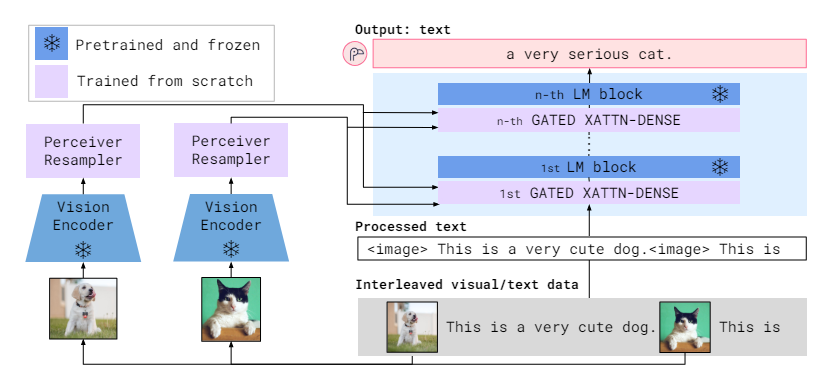

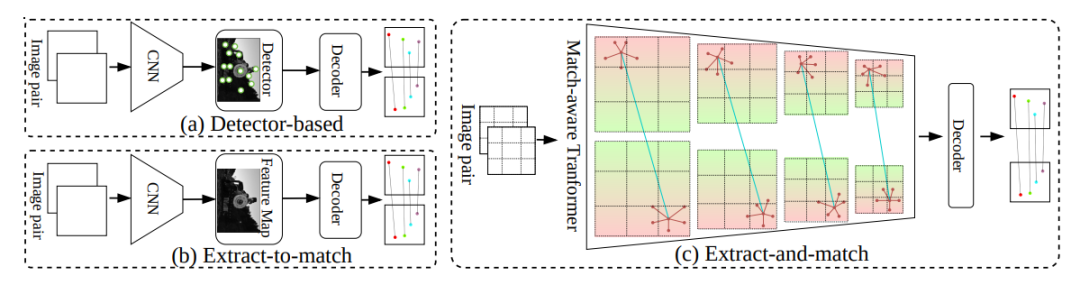

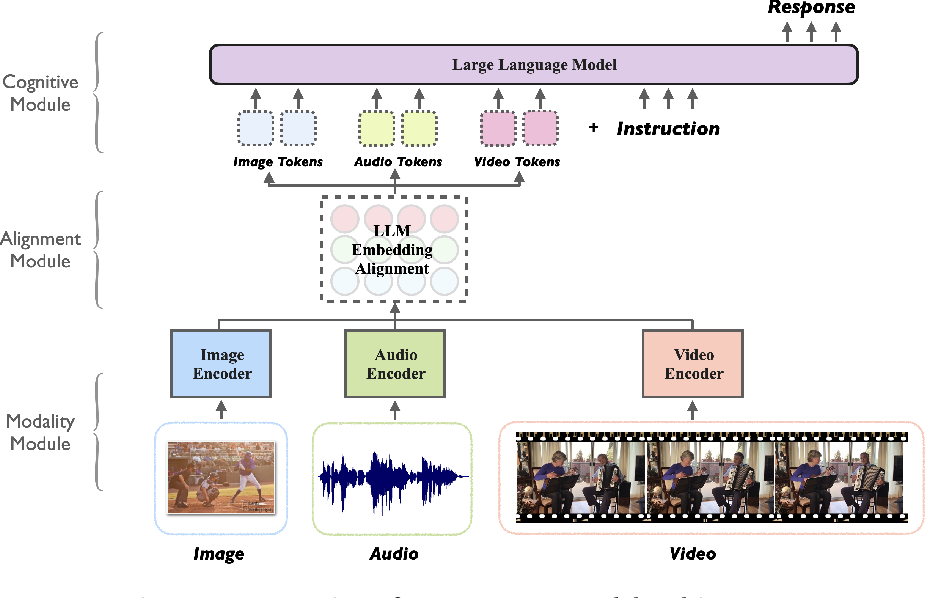

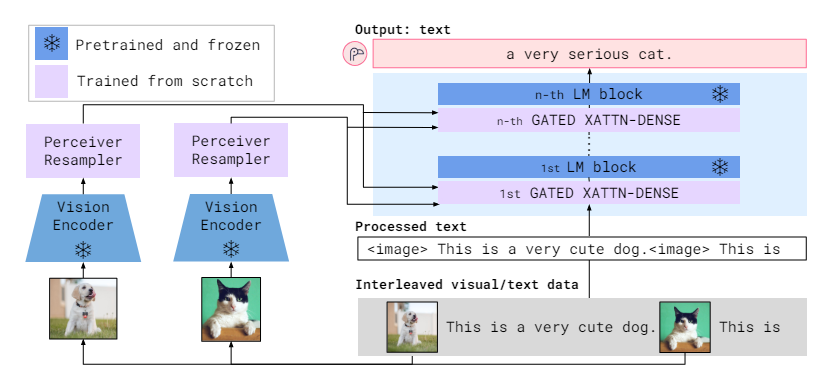

Flamingo架构使用交错的视觉/文本数据作为输入

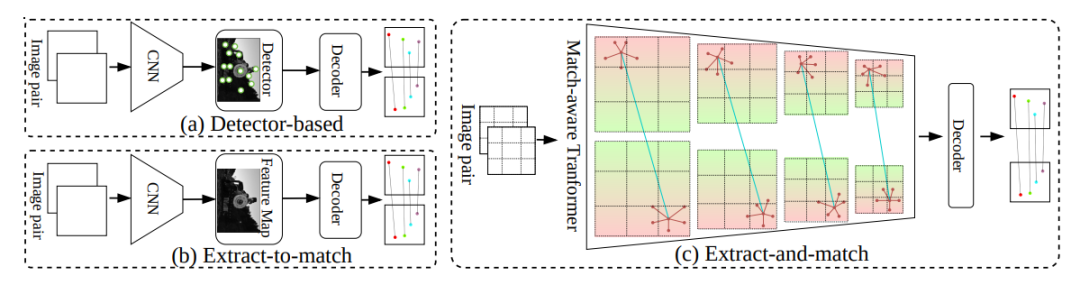

•交错注意力层(Interleaved Attention Layer):Llama 4架构中的一项关键创新是使用交错注意力层(与Flamingo架构类似) ,而无需位置嵌入。为了提高计算效率和匹配低纹理场景的稳定性,通过交错 self-attention 和 crossattention 来构建匹配感知编码器。该方法可以同时学习图像本身的局部特征及其配对图像的相似性,减轻了解码器负担,使整个模型更高效。

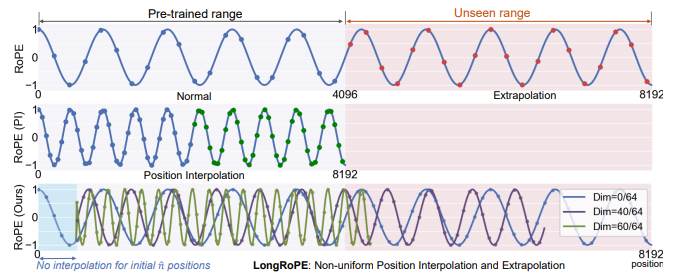

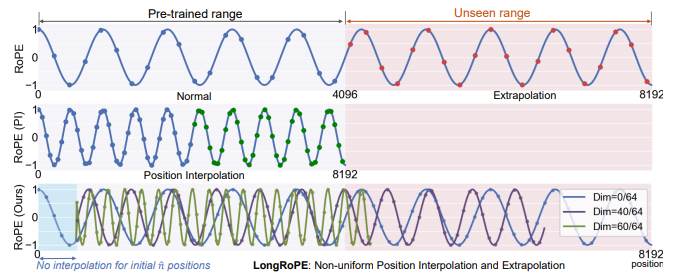

•位置编码: 为支持1000万token的超长上下文(主要是Scout),Llama 4 iRoPE扩展技术。

传统的感知编码器与交错注意力层(c)对比(来源:Karlsruhe Institute of Technology)

•自注意和交叉注意力模块的组合在交错策略的进行组合计算。下图中的每个块包含 N 个注意力模块,其中每个注意力模块根据输入图像对表示为自注意力或替代交叉注意力。对于自注意力,Q 和 (K, V ) 来自相同的输入,因此自注意力负责图像本身的特征提取。对于交叉注意力,(K’, V’) 来自图像对的另一个输入。因此,交叉注意力学习图像对的相似性,从而产生一个基于匹配感知的 transformer 编码器。在注意力块中,会提取自注意特征,而特征对的相似度则由交叉注意力来确定。这一策略更符合人类的直觉,可以同时学习图像对的更多相应特征,同时关注相似度。

交错注意力层结构(来源:Karlsruhe Institute of Technology)

1000万token的上下文窗口是Llama 4 Scout的一大亮点。这背后可能涉及:

•位置编码: 为支持1000万token的超长上下文(主要是Scout),Llama 4采用了推理时间温度缩放(Inference Time Temperature Scaling),也称为iRoPE扩展技术,以支持超长序列。

•分层记忆结构: Llama 4可能引入了分层记忆机制,将上下文分为短期和长期记忆,动态管理token的存储和访问。

•数据压缩: 通过更高效的分词器(Llama 3已使用128K词汇表),Llama 4可能进一步压缩输入表示,减少内存占用。

推断(Inference)时间扩展是指在机器学习模型推理期间分配越来越多的计算资源,以提高在复杂任务上的性能。但在实际应用中,尽管推断时间扩展可以提高性能,但其有效性因领域和任务而异。随着任务复杂性的增加,这一方法的效率会递减。

我们也注意到,Llama 4的1000万token明显超过DeepSeek的128K,这是否预示着Llama 4位置编码优化更激进。这种明显强化的超长上下文能力,是否会牺牲部分短上下文任务的精度。

Llama 4的性能提升离不开高质量的训练数据和优化策略:

•原生多模态:Llama 4模型采用原生多模态设计,结合早期数据融合,将文本和视觉标记无缝集成到统一的模型主干中。早期融合是MoE模型向前迈出的一大步,能够使用大量未标记的文本、图像和视频数据联合预训练模型。Llama 4还基于MetaCLIP优化了视觉编码器,以更好的使编码器适应 MoE架构。

•新训练技术:Meta开发了新的训练技术 MetaP,以便于更可靠的设置关键的模型超参数,例如每层学习率和初始化规模。Llama 4通过对 200 种语言进行预训练来支持微调工作,其中包括 100 多种语言,每种语言的token超过 10 亿个,总体上是 Llama 3 的 10 倍。

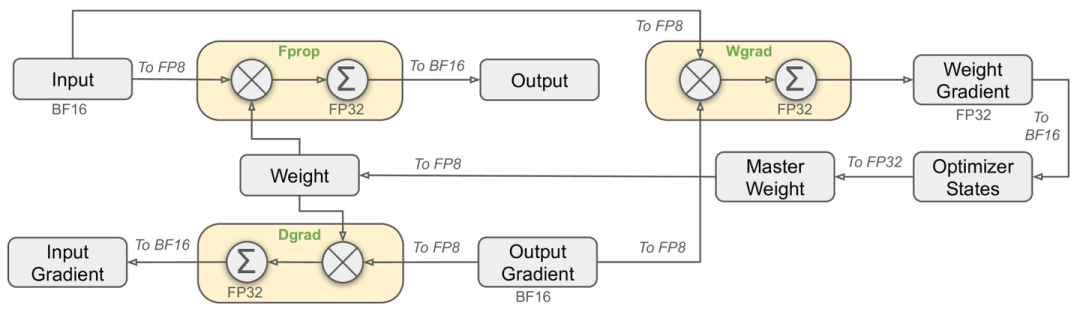

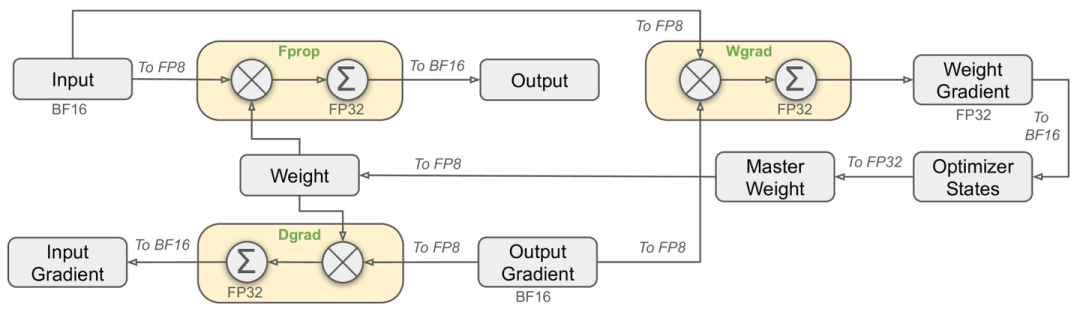

•FP8训练:专注于通过使用 FP8 精度进行高效的模型训练,不牺牲质量并确保模型 FLOPs 的高利用率,同时使用 FP8 和 32K GPU 对 Llama 4 Behemoth 模型进行预训练。

•长上下文扩展:使用专用数据集的进行长上下文扩展。

•混合模态特有的训练流程:轻量级监督微调 (SFT) > 在线强化学习 (RL) > 轻量级直接偏好优化 (DPO)。

•数据规模: Llama 4 Scout 在 ~40 万亿个token上进行了预训练,Llama 4 Maverick 在 ~22 万亿个多模态数据token上进行了预训练。懂的都懂,这些数据有一部分来自于Instagram 和 Facebook。

•数据过滤: Meta一贯重视数据质量,Llama 4可能延续Llama 2的策略,使用分类器(如Llama 3)筛选高质量token,并针对多语言和多模态任务进行主题均衡。

•知识截止: X用户提到知识截至2024年8月,这表明Llama 4的训练数据更新较为及时,但中文数据的缺失可能影响其在特定场景的表现。

潜在挑战与改进空间

尽管Llama 4在架构上非常先进,在多模态MoE架构的进步上表现亮眼,但仍有一些需要进一步确认的信息:

MoE模型容易出现某些专家被过度使用的情况,Llama 4使用了何种机制/路由算法来优化负载和训练均衡。Llama 4是否会照搬DeepSeekMoE的训练方法?

多模态能力的实现可能依赖独特的预训练模块来进行模态增强,如何无缝整合这些模块仍需验证。

尽管MoE降低了计算量,但超长上下文和高参数量对内存需求依然巨大,单张H100运行Scout已属极限,更大模型可能需要多GPU/AI芯片支持。后面的大模型竞争依然有点算力为王的意思。这次Llama 4的发布,与加关税的步调高度协同,不知道是否是丑国竞争的一张牌。

Llama 4是Meta在开源AI领域的一次重大突破,并体现了其与DeepSeek在MoE架构上血拼的决心。

换句话说,DeepSeek的对开源界的贡献也倒逼Llama加速其开放速度。Llama 4MoE架构结合多模态能力和超长上下文窗口,不仅在性能上逼近甚至超越闭源模型,也为学术研究和企业应用提供了更多可能性。

从架构上看,Llama 4在Transformer的基础上,减小了单个专家,通过稀疏激活、动态路由和高效注意力机制实现了效率与性能的平衡。中文支持的不足和高资源需求可能是未来需要解决的痛点。

(文:机器学习算法与自然语言处理)