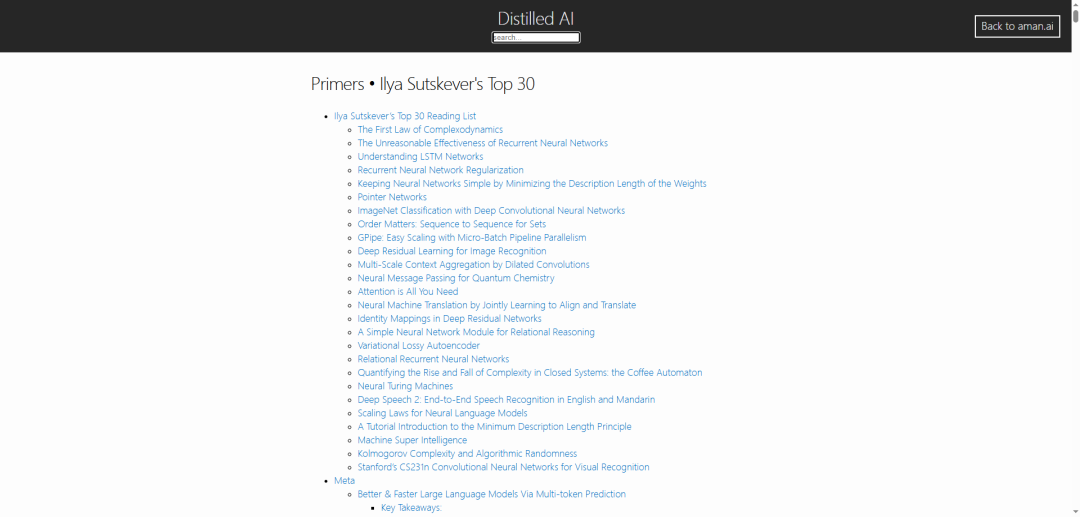

OpenAI联合创始人Ilya精选的AI论文清单来了。Ilya称,读懂这30篇论文,就掌握了当今世界的90%重要知识。

-

22篇基础篇(经典神经网 & 结构):RNN/LSTM、CNN、Transformer、记忆模型、VAE 等

-

3篇优化篇(正则化、规模、推理):dropout、残差、MDL、GPipe、Scaling Laws、关系网络等

-

5篇应用篇(ASR、检索、生成、对齐):Deep Speech2、DPR、RAG、Zephyr、fact‑checking

一、基础篇

The First Law of Complexodynamics:用复杂性 vs 熵探讨世界演化曲线

链接:scottaaronson.blog/?p=762

Unreasonable Effectiveness of RNNs、Understanding LSTM Networks:RNN/LSTM 入门与结构讲解

链接:karpathy.github.io/2015/05/21/rnn-effectiveness/

链接:colah.github.io/posts/2015-08-Understanding-LSTMs/

RNN Regularization:LSTM 加 dropout 的技巧

链接:arxiv.org/abs/1409.2329v5

MDL 权重最小化:从 Hinton 的信息论视角正则化

链接:www.cs.toronto.edu/~hinton/absps/colt93.pdf

Pointer Networks:用注意力抠 token 索引问题

链接:arxiv.org/abs/1506.03134v2

AlexNet (ImageNet Classification…):CNN 崛起启蒙作

链接:proceedings.neurips.cc/paper_files/paper/2012/file/c399862d3b9d6b76c8436e924a68c45b-Paper.pdf

Order Matters for Sets:Seq2Seq 模型处理无序数据策略

链接:arxiv.org/pdf/1511.06391

GPipe:跨 GPU 按片训练大模型

链接:arxiv.org/abs/1811.06965

ResNet (Deep Residual Learning):残差块首创,后续身份映射优化版本

链接:arxiv.org/abs/1512.03385 链接:arxiv.org/abs/1603.05027

Dilated Convolutions:不降采样却扩大感受野

链接:arxiv.org/abs/1511.07122

Neural Message Passing:化学图建模的 message passing 神经网

链接:arxiv.org/pdf/1704.01212

Attention is All You Need:Transformer 架构诞生经

链接:arxiv.org/abs/1706.03762

Bahdanau Attention for NMT:早期注意力机制在翻译上的关键贡献

链接:arxiv.org/pdf/1409.0473

Relation Networks、Relational RNNs:关系推理模块与记忆网络

链接:arxiv.org/abs/1706.01427 链接:arxiv.org/pdf/1806.01822

Variational Lossy Autoencoder:VAE+自回归混合,把握全局结构

链接:arxiv.org/pdf/1611.02731

Neural Turing Machines:神经控制器+可微记忆,做算法学习

链接:arxiv.org/abs/1410.5401

Deep Speech 2:端到端中英 ASR 高精度实践

链接:arxiv.org/pdf/1512.02595

Scaling Laws for LMs:参数/数据/算力规模与性能关系

链接:arxiv.org/abs/2001.08361

MDL 原理教程:信息压缩+模型选择理论

链接:arxiv.org/pdf/math/0406077

Machine Super Intelligence:Shane Legg 关于超智能框架与安全

链接:www.vetta.org/documents/Machine_Super_Intelligence.pdf

Kolmogorov Complexity:算法复杂性与信息论基础

链接:www.lirmm.fr/~ashen/kolmbook-eng-scan.pdf

Stanford CS231n:CNN 图像识别课程一手教程

链接:cs231n.github.io/

二、优化篇

Multi‑token Prediction(Better & Faster LLMs):预测多个 token,效率与性能提升

链接:arxiv.org/pdf/2404.19737

Dense Passage Retrieval:双编码检索模块 DPR,开放问答 retrieval 主力

链接:arxiv.org/pdf/2004.04906.pdf

RAG:检索增强生成模型,用检索器+seq2seq 模型融合生成事实性回答

链接:arxiv.org/abs/2005.11401v4

三、应用篇

Zephyr:LM Alignment:无人工反馈,直接用 distillation + dDPO 达到 alignment 效率

链接:arxiv.org/pdf/2310.16944.pdf

Lost In The Middle:揭开 LLM 在超长上下文中中段 recall 的“U 型”性能坍缩现象

链接:arxiv.org/abs/2302.12345

Precise Zero‑Shot Dense Retrieval:HyDE 方法,用生成器创造伪标注,做真正 zero‑shot 检索

链接:arxiv.org/abs/2212.10496

ALCUNA:构造新知识 benchmark,看 LLM 如何接纳未见实体

链接:arxiv.org/pdf/2310.14820.pdf

Fact‑checking with LLMs:评估 GPT‑3.5/4 用于事实核查的潜力与局限

链接:arxiv.org/pdf/2310.13549.pdf

参考文献:

[1] https://aman.ai/primers/ai/top-30-papers/

知识星球服务内容:Dify源码剖析及答疑,Dify对话系统源码,NLP电子书籍报告下载,公众号所有付费资料。加微信buxingtianxia21进NLP工程化资料群。

(文:NLP工程化)