极市导读

清华大学等机构提出多类异常检测模型Dinomaly。Dinomaly通过极简主义的设计,首次让多类异常检测性能逼近甚至超越单类模型,具有简单、高效、易于扩展的特点。 >>加入极市CV技术交流群,走在计算机视觉的最前沿

📊 太长不看版:

最简单的trick刷最高的点,让多类异常检测性能首次逼近甚至超越单类模型水平!

作者来自清华大学,北京理工大学,上海交通大学。

Paper: https://arxiv.org/abs/2405.14325

Github: https://github.com/guojiajeremy/Dinomaly

解决了什么痛点(导读)

想象一下,一个工厂要检测30种不同产品的缺陷:

❌ 传统方案:需要训练30个独立模型,好麻烦,存储成本巨大

❌ 现有多类模型:性能大幅下降,技术原理却又很复杂,实用性受限

✅ 本文提出Dinomaly:一个模型搞定所有类别,模型超简单,性能还更强!

一些直觉

Multi-class UAD的性能显著差于class-separate UAD,是由于多个类别组成的“正常”分布更加多样、更加难以建模。在最常用的的基于重建方法中,这个问题之前被描述为恒等映射现象(identity mapping)。而我们认为:这都怪Decoder学得太好了,以至于重建能力over-generalization到了未见异常上。

本文方法:Less is More!

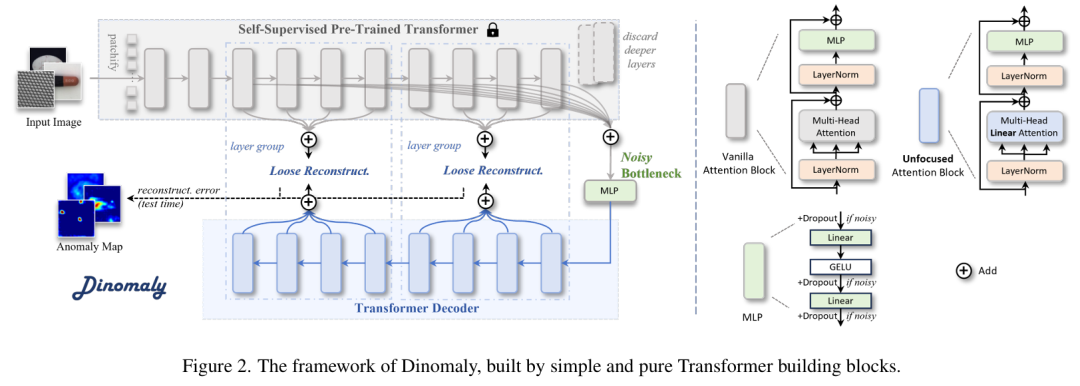

1. “What I cannot create, I do not understand”:基于Foundation Model的自重建框架

-

A side: create(重建)不出来,就不understand(异常);B side: backbone需要有强大的表征能力 -

利用DINOv2等自监督预训练模型提取通用且具有判别性的特征表示,利用重建误差检测异常

2. “Dropout is all you need”:噪声瓶颈

-

巧妙利用现有的Dropout机制,阻断over generalization -

无需复杂的噪声和伪异常生成,简单有效

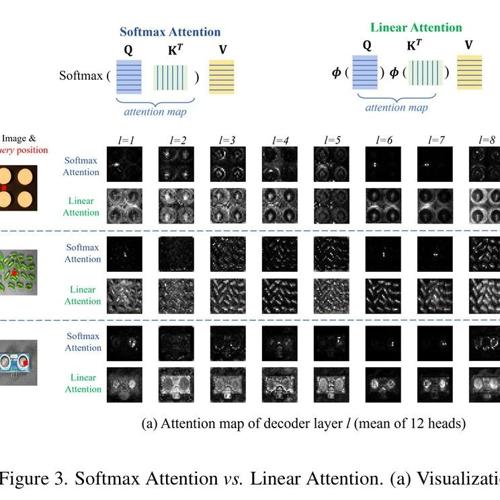

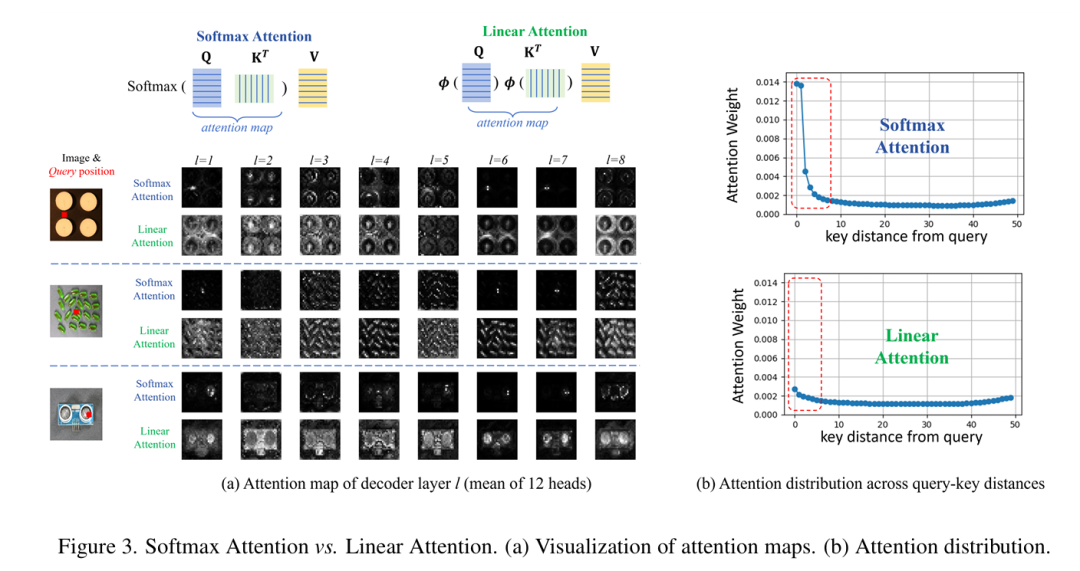

3. “One man’s poison is another man’s meat”: 注意力涣散的注意力

-

Linear Attention被诟病难以focus? 那我们故意使用”不聚焦”的Linear Attention! -

避免Attention学会简单的恒等映射

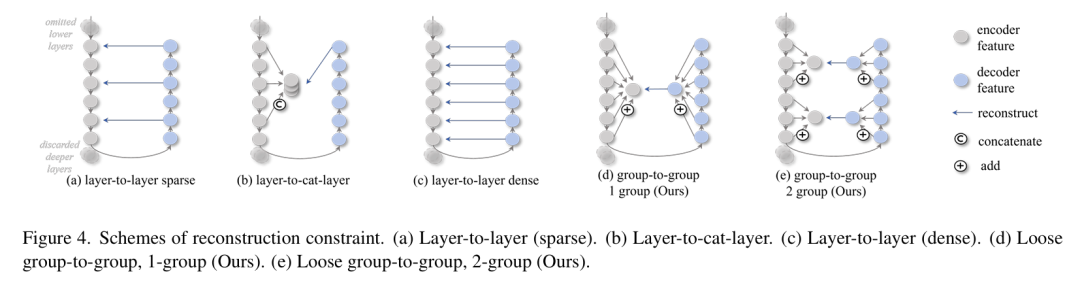

4. “The tighter you squeeze, the less you have”:松散的重建约束

-

打破Encoder-Decoder逐层、逐像素重建对应的严格约束 -

给Decoder更多自由度(Freedom!), 避免学的太好,以至于过泛化

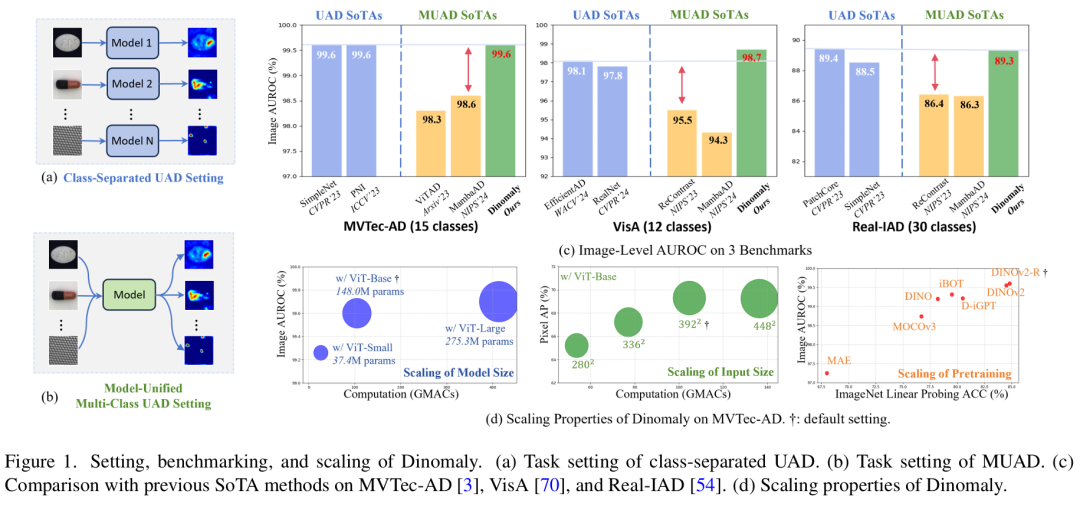

性能表现惊艳

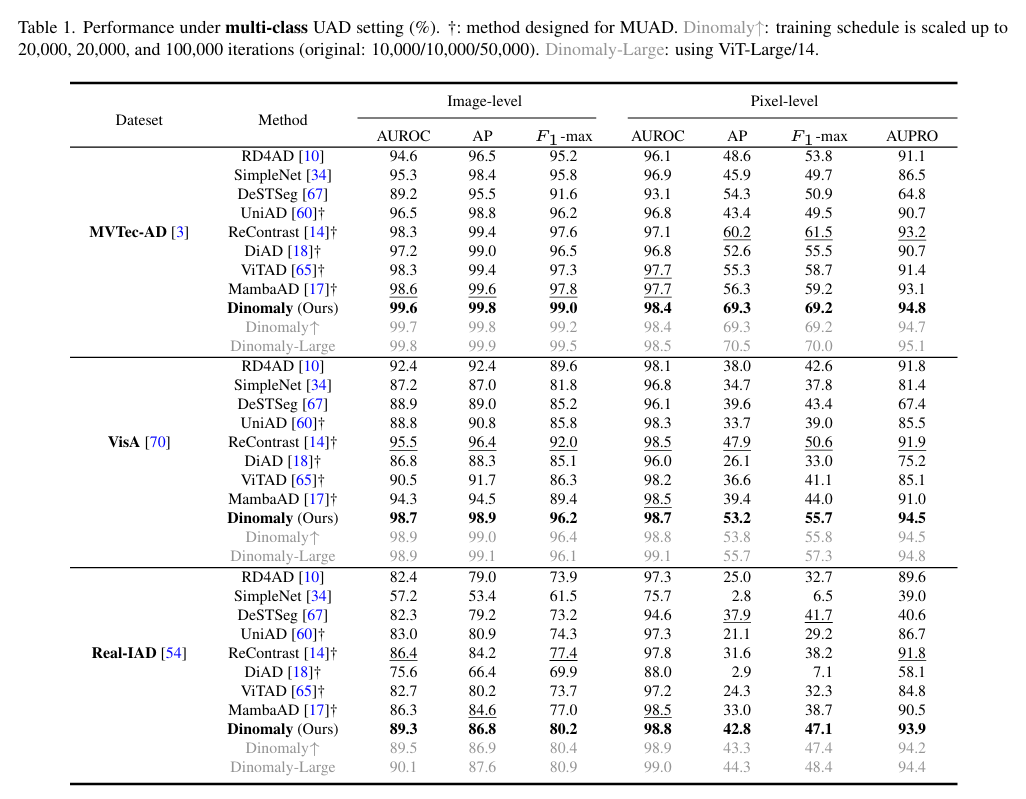

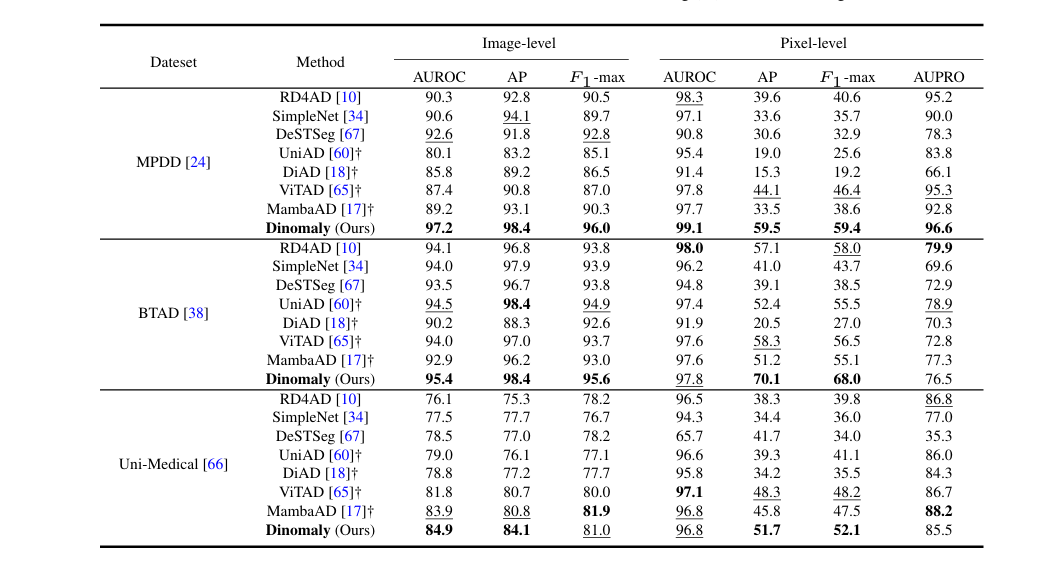

MVTec AD: 多类SOTA (98.5%),单类SOTA(99.8%),Dinomaly-Large(99.8%)

VisA: 多类SOTA (95.5%),单类SOTA(98.9%),Dinomaly-Large (98.9%)

Real-IAD: 多类SOTA (86.4%),单类SOTA(89.4%),Dinomaly-Large (90.1%)

🎉 Real-IAD, MPDD, BTAD, Uni-Medical,都是SOTA!首次让多类统一模型性能媲美甚至超越单类专用模型。

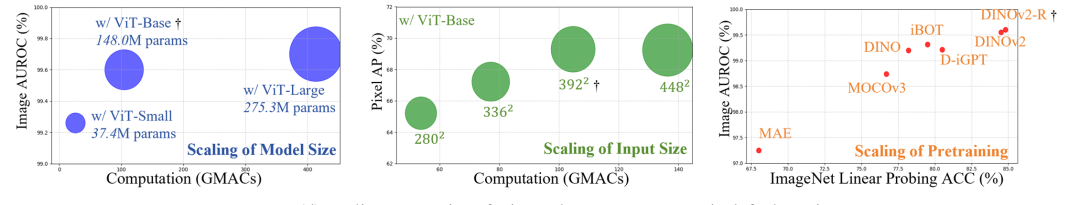

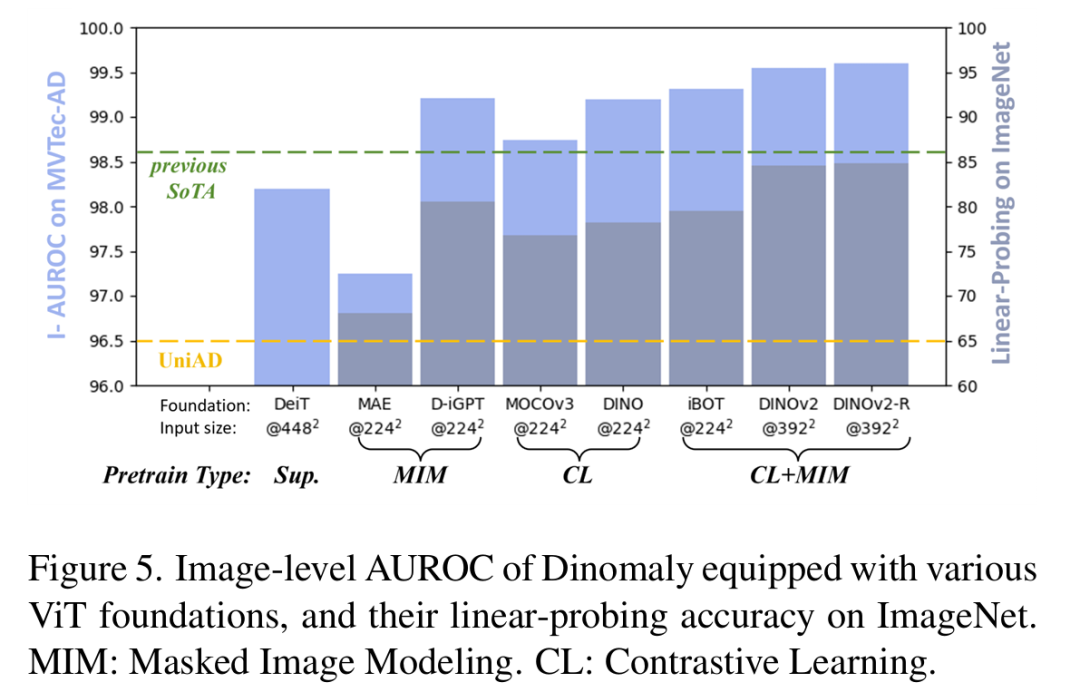

✨Scalability: 模型越大效果越好,模型的ImageNet linear-probing越高越好,分辨率越大越好,适配多种预训练ViT。

📝开源、易用、好扩展:方法简洁优雅,可扩展性强。自2024年5月开源以来github收获100+⭐。后续基于Dinomaly的工作也相继中稿CVPR等顶刊顶会(INP-Former等,还有一波在路上),并在UAD竞赛中取得佳绩(Robust-Dinomaly, VAND 2.0)。欢迎大家魔改、引用!

(文:极市干货)