日期: 2025 年 4 月 17 日

字节开源了一个新型多模态生成模型 Liquid

字节开源新型多模态生成模型Liquid,核心创新在于统一编码图像和文本到相同token空间,并使用单一LLM处理视觉理解和生成任务。研究表明,随着模型规模增大,性能下降会消失甚至互相促进。

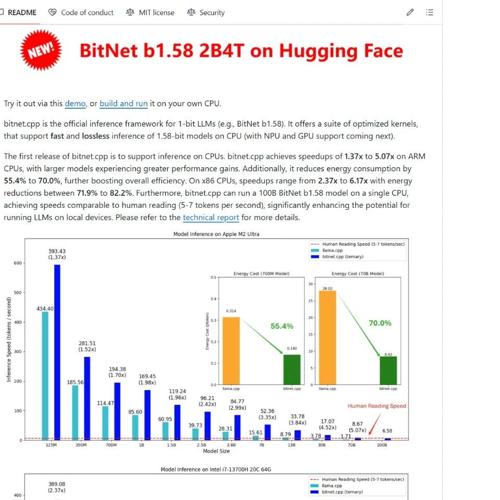

微软研究院发布了个原生 1-bit 的大语言模型:bitnet-b1.58-2B-4T

微软发布原生1-bit大语言模型bitnet-b1.58-2B-4T,其在内存占用和CPU推理延迟上大幅降低,并且性能接近全精度模型。

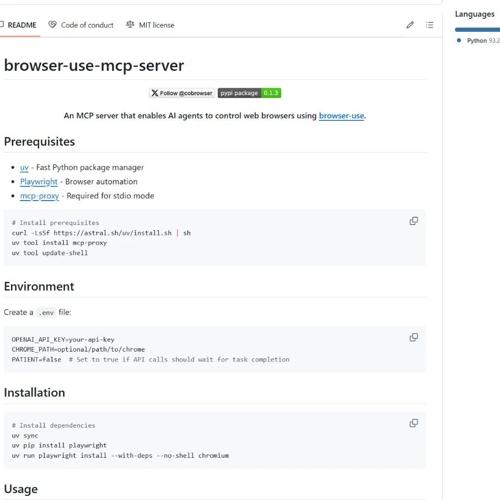

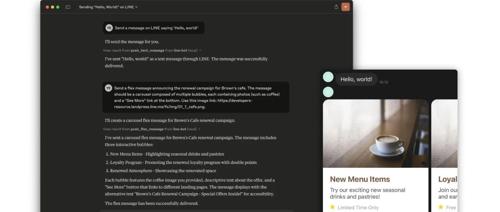

line-bot-mcp-server:将AI Agent与LINE官方账号无缝连接的MCP服务器

LINE Messaging API实现高效消息推送,支持文本和Flex消息,并提供用户详细资料获取功能。

快讯西湖大学仿生潜水器“西谷II号”完成深海海试,上虞区成立杭州湾具身智能创新中心,北大研发新模型实现人体动作精准编辑

西湖大学的仿生潜水器‘西谷II号’完成深海海试,实现四项技术验证;上虞区成立杭州湾具身智能创新中心推动该领域发展;北京大学研发新模型简化人类角色动作生成;宾夕法尼亚州立大学开发微型柔性机器人用于医疗和救援任务;加州大学研发的卷尺启发机器人夹持器可用于水果采摘等应用。

多模态AI模型再添猛将!Liquid:字节最新开源的多模态LLM,视觉与语言统一生成!

Liquid 是一款由字节跳动、华中科技大学和香港大学联合开源的强大模型,能无缝集成视觉理解与生成能力。其7B参数的多模态大语言模型基于离散编码技术,能够实现统一处理图像、文字输入输出,表现出色的视觉理解和强大的图像生成功能。

戴盟自研视触觉传感器破局,三款新品打通机器人“感知-操作-学习”全链路

4月16日,戴盟发布多维高分辨率视触觉传感器DM-Tac W、类人手部执行器DM-Hand1和穿戴式数据采集系统DM-EXton系列家族产品,贯通机器人感知、操作和学习技术核心。该方案攻克触觉感知难题,助力具身智能产业加速商业化落地。