多模态能力

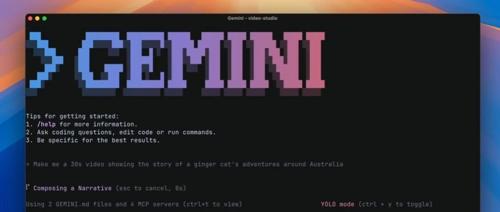

谷歌放大招了,开源命令行AI编程Agent,每天1000次免费调用,编程只是基础功能。

Gemini CLI 是谷歌推出的开源 AI 命令行工具,基于 Gemini 2.5 Pro 模型,支持百万 token 上下文,提供免费 API 请求额度,并具备智能代码处理、多模态能力、实时信息整合和高度可定制性等功能。

谷歌 Gemini 2.5 技术白皮书来了:顶级推理、百万上下文、多模态理解

谷歌发布Gemini 2.5系列模型,包含Pro、Flash和Flash-Lite三个版本。Pro版支持多模态输入、超长上下文处理能力;Flash版优化推理速度与成本效率;Flash-Lite版主打极低延迟和高性价比。Gemini 2.5 Pro采用稀疏激活MoE架构、大规模TPU v5p训练及强化学习控制的思维路径,显著提升性能与效率。测试显示其在编程、数学等领域能力全面提升,并具备多模态任务合成与创作输出的能力。

文心大模型又双叒叕进化了!

最新发布的文心大模型X1 Turbo和文心4.5 Turbo性能更优、价格更低,分别在工具调用、行程规划、逻辑推理、写作&问答等多个领域表现出色,并归功于多模态基础模型优化、自反馈增强的后训练框架等核心技术。

1小时+1.3元成本!让MiniMind-V教你零代码训练自己的多模态AI模型!

一款名为MiniMind-V的开源模型简化了多模态视觉语言模型(VLM)的训练流程,仅需1小时和不到1.3元的成本即可完成训练。该模型参数量为26M,适合个人开发者从零开始学习,并提供了详细的数据处理、预训练和指令微调代码。

100镜实测Gemini2.0″用嘴改图”新功能,AI生图的天被捅破了(附五档难度、12个真实案例)

修改提示语、每张图生成时间不超过10s,

你肯定以为我是吹牛,

但现在

Gemini 2.0 Fla