日期: 2025 年 2 月 22 日

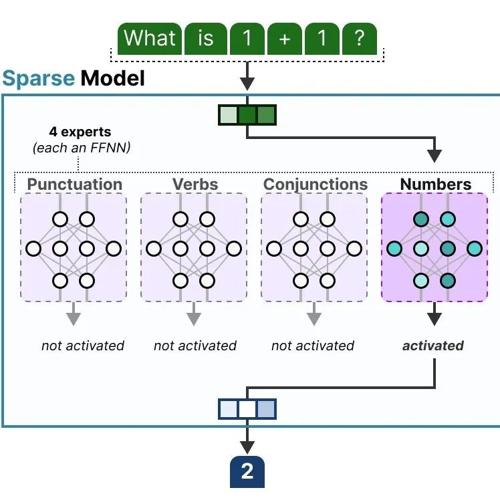

A Visual Guide to Mixture of Experts (MoE)

混合专家模型(MoE)通过动态选择子模型处理不同输入,显著降低计算成本并提升表现,核心组件包括专家网络、路由机制和稀疏激活。

它太快了!“DeepSeek难民”最佳平替,双核驱动,还支持R1推理生图!

元石科技的『问小白』接入DeepSeek R1满血版后表现亮眼,秒速回答问题且支持多端使用。同时拥有R1推理生图功能和丰富的AI智能体,成为国内首家提供这些特性的产品。

OpenAI实名举报Grok3作弊,一题答64次踩着台阶和o3-mini比

Grok-3发布仅三天便陷入作弊风波。OpenAI指责其使用cons@64评估模型,导致其表现被高估。尽管如此,Grok-3仍展示了其独特的能力和潜力,如快速开发小游戏等。