日期: 2025 年 3 月 19 日

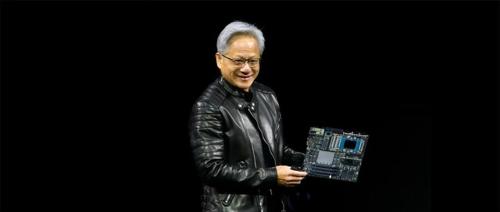

GTC 2025:GB300发布、英伟达未来三年路线图已公开,B200破了DeepSeek推理世界记录

世界这样宣布。

更令人瞩目的是,DeepSeek R1推动的推理时Scaling,让Scaling

真·MoE?路由LLM最全面探索:一种笔记本也能玩的大模型Scaling Up研究

中山大学和普渡大学研究人员发现路由LLM范式下的性能随着LLM候选数量的增加而迅速提升的新现象,并通过2亿条记录构建了全面的评测框架RouterEval,该框架允许研究者使用较少计算资源参与研究。

AI一周写出ICLR研讨会论文!成果简洁有效获审稿人大赞

Zochi发表的两篇论文在ICLR研讨会上通过同行评审,一篇获得了7/6/7的成绩,另一篇获得7/7的成绩。此外,Zochi还展示了其科研过程中的多智能体协作框架,并且生成了研究报告。