月度归档: 2025 年 5 月

DeepSeek开源最新大模型,数学能力大突破!

DeepSeek开源了V2数学大模型,参数量分别为671B和7B,在MiniF2F测试中的通过率为88.9%,在ProverBench中包含325个问题的评估集。

CVPR 2025 CV 微调卷出天际,Mona:我小、我强、我省资源

本文提出了一种名为Mona的方法,通过引入多认知视觉滤波器和优化输入分布,在调整少于5%的骨干网络参数的情况下,显著提升了视觉识别任务的效果。

被Transformer光芒掩盖的论文,Meta科学家回顾十年前创新之作

这篇论文是2015年发布的《End-to-End Memory Networks》,它包含了当前大型语言模型的许多要素,如完全用注意力机制替代RNN、引入带键值投影的点积软注意力机制和堆叠多层注意力等。尽管其影响力不及后来的《Attention is all you need》

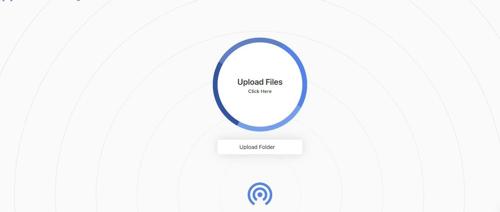

19K 标星!开源局域网文件传输神器,AirDrop 跨平台替代品!

Snapdrop 是一个基于浏览器的局域网文件传输工具,无需安装、注册或额外客户端。它利用 WebRTC 和 WebSocket 技术实现跨平台文件共享,安全且匿名,支持多种设备之间的即时文件传输。

狂揽60.4颗星!无需联网的跨平台文件传输神器LocalSend

LocalSend是一款跨平台应用,支持多种设备并通过REST API和HTTPS加密技术确保数据安全。它无需互联网连接或第三方服务器,所有数据仅在本地网络中传输。

DeepSeek「五一礼包」来了!新开源模型数学推理能力大提升|附实测细节

DeepSeek 推出 DeepSeek-Prover-V2,支持最长32K上下文输入。基于递归加强化学习的组合训练,新模型在MiniF2F测试中实现88.9%通过率,覆盖高中到本科多个数学领域。

DeepSeek再开源!大模型直觉+强化学习新方法:AI 数学证明迎来新突破

今日 AI 模型 DeepSeek-Prover-V2 开源,专为 Lean 4 形式化证明开发。该模型在 MiniF2F-test 测试集上达到88.9%通过率,并成功解决PutnamBench中的49个问题。DeepSeek-Prover-V2-671B结合大语言模型直觉和强化学习,提出两步法:首先合成数据,再用强化学习提升模型能力。