Transformer架构

突破算力限制!Meta开源“记忆层”,重塑Transformer架构大模型

专注AIGC领域的专业社区分享Meta的Memory layers研究进展,介绍其通过高效查询机制显著增加大模型参数而无需额外算力的方法。

什么是序列到序列(Seq2Seq)模型?以及为什么图像理解领域主要使用的是CNN网络而不是Transformer网络?

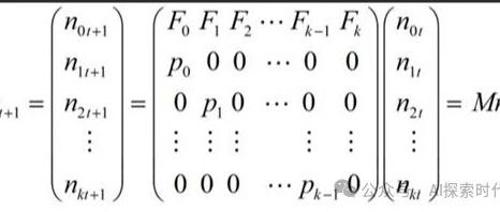

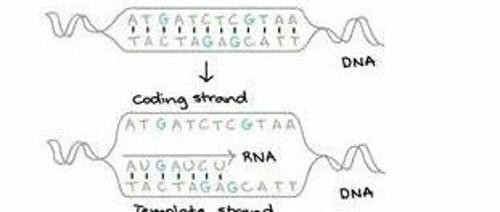

大模型的核心在于特征提取和重建。Transformer架构在NLP领域表现突出,而CNN则适用于图像处理。序列到序列(Seq2Seq)用于具有连续性内容的生成,如机器翻译、语音识别及视频处理等领域。CNN擅长处理不连续且独立的图像数据。

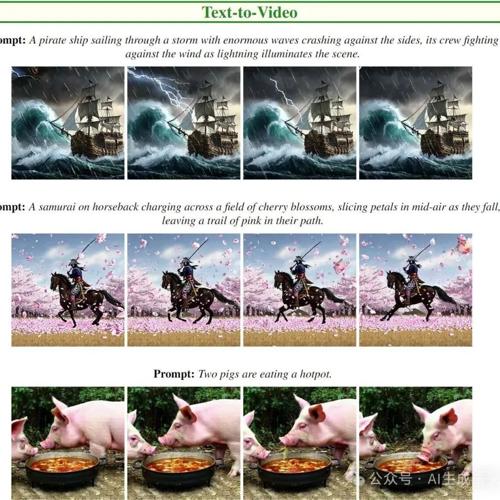

超越CogVideoX-5B、Pika、Kling 和 Gen-3!苹果再发新作,视频生成大模型全面报告

↑ 点击

蓝字

关注极市平台

作者丨AI生成未来

来源丨AI生成未来

编辑丨极市平台

极市导读

ST

极限压缩380倍!比OpenAI的Whisper更高效,开源模型超2000颗星

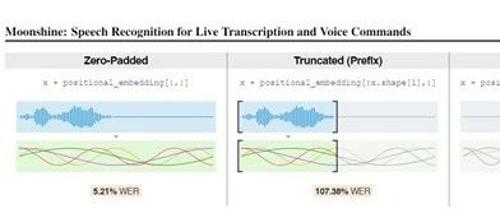

开源语音模型Moonshine在推理效率和性能上进行大幅度优化,输入音频信号压缩高达384倍。它使用RoPE位置编码方式处理可变长度序列,并采用了字节级BPE分词器来提高文本处理灵活性和效率。

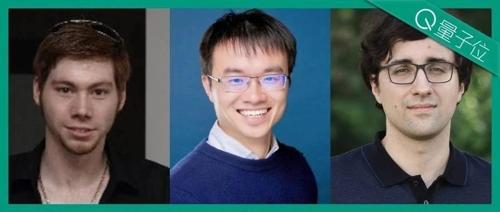

刚刚,谷歌ViT核心骨干集体投奔OpenAI:他们为Sora打下基础

ViT三大核心作者翟晓华、卢卡斯·拜尔和亚历山大·科列斯尼科夫集体离职谷歌DeepMind,加入OpenAI。他们在计算机视觉领域的研究包括ViT及其衍生工作、SigLIP、PaliGamma等。