405B大模型也能线性化!斯坦福MIT最新研究,0.2%训练量让线性注意力提分20+

研究人员提出LoLCATs方法,通过低秩线性转换将传统注意力无缝转移到线性注意力,使生产级大模型如Llama 3.1 405B的训练效率大幅提升。

美国AI曼哈顿计划793页文件曝光!全力研发AGI,十大战略直指中国

美国提出AI‘曼哈顿计划’以研发匹配或超越人类智能的AGI系统,全面对抗中国。国会建议包括政府提供资金支持领先企业、简化数据中心许可流程以及立法限制中国技术进口等措施。

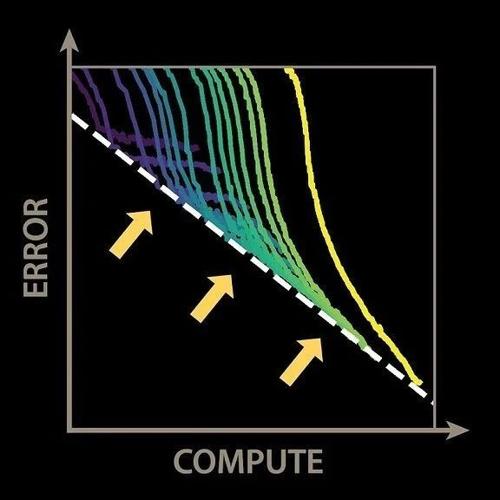

微软CEO:AI扩展没有撞墙,“测试时间计算”成功就是最好的证明

Satya Nadella 在微软Ignite大会上表示,关于扩展定律是否已经“撞墙”的争论有很多。他认为这些观察是长期有效的经验,并鼓励创新。他提出“测试时计算”作为新的扩展规律,并指出Copilot和AI技术栈将帮助构建一个由AI代理组成的未来世界。

精度与通用性不可兼得,北大、华为理论证明低精度下Scaling Law难以实现

大模型量化通过降低精度来提高推理速度,但研究发现不同精度下大语言模型在基本数学任务上的表现显著下降。研究证明足够的精度是解决这些任务的重要前提,而量化会严重损害大模型的数学推理能力。