新智元

新智元

英伟达提出全新Star Attention,10倍加速LLM推理!登顶Hugging Face论文榜

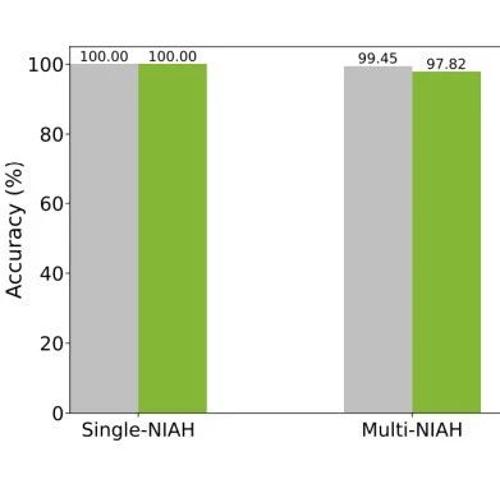

英伟达提出的新技术Star Attention能显著减少Transformer模型长序列推理时的计算量,从而提高效率和准确性。它通过将上下文分成较小块并在每个主机上独立处理这些块来实现,这有助于在不牺牲精度的情况下加速推理过程。

1-bit大模型还能再突破!新一代BitNet架构启用4位激活值

BitNet系列原班人马推出新一代架构BitNet a4.8,采用两阶段权重衰减和学习率调度。实验对比显示其在语言模型困惑度和任务准确性方面与LLaMA相当,并且平均精度几乎没有损失。

一次推理,实现六大3D点云分割任务!华科发布大一统算法UniSeg3D,性能新SOTA

华中科技大学提出UniSeg3D算法,一次性完成六项3D点云分割任务,提升场景理解和效率。通过信息共享优化性能,在多个数据集上取得SOTA结果。