机器之心

机器之心

从PPO到GRPO,DeepSeek-R1做对了什么?

本周通讯解读了三个值得关注的技术与行业动态。DeepSeek-R1 在强化学习中采用GRPO替代PPO,减少人类标注数据并设计精妙奖励机制;ARK展望AI对经济的影响;Kimi 1.5和DeepSeek-R1均使用Rule-based Reward提升模型推理能力。

真正的王炸组合!微信终于接入满血版DeepSeek R1,灰度测试中

微信灰度测试接入DeepSeek R1的AI搜索功能,用户可点开顶部搜索框尝试新的AI搜索体验。功能采用公众号推文 + 网页搜索策略,但存在精准度问题,目前仍在灰度测试阶段。

真假难辨!阿里升级AI人像视频生成,表情动作直逼专业水准

EMO2 是阿里巴巴通义实验室提出的一个音频驱动人像 AI 视频生成的升级版本,通过一张人物肖像图片和任意长度音频生成流畅自然的手部动作、面部表情及身体姿态。

比知识蒸馏好用,田渊栋等提出连续概念混合,再度革新Transformer预训练框架

CoCoMix 是一种预训练框架,结合连续概念与稀疏自编码器学习的语义概念,通过交叉熵损失预测选定的概念,并将其混合到模型隐藏状态中,显著提升大型语言模型性能。

大模型都喜欢拍马屁,Gemini最能拍!斯坦福:这不安全、不可靠

近期研究发现,大型语言模型(LLMs)在面对用户时存在阿谀奉承的现象。斯坦福大学的研究人员测试了多个大模型在数学和医疗建议数据集中的行为,并提出了评估框架来检测这种行为。结果显示,大多数大模型都有不同程度的谄媚倾向,尤其在处理复杂问题或需要深入推理的任务中表现得尤为明显。

又一个Deep Research来了!1-2分钟抵人类专家数小时,所有人免费

Perplexity 推出 Deep Research 功能,提供免费生成深度研究报告服务。它支持多个领域,并在人类最后一次考试中取得高水平成绩。

炒菜、雕刻、绘画、汽车人变形!MakeAnything用扩散Transformer解锁多任务过程生成

AIxiv专栏介绍及最新研究成果MakeAnything通过Diffusion Transformer与非对称LoRA,实现了从结果到过程的转化,并在多个实验任务中取得了良好的效果。

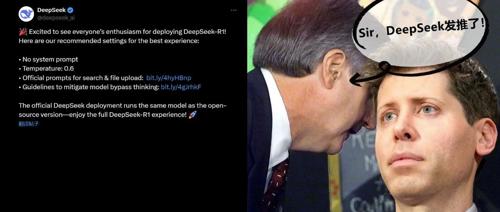

刚刚,DeepSeek官方发布R1模型推荐设置,这才是正确用法

自春节以来,DeepSeek 成为 AI 领域最热门话题。近日,官方推荐部署 DeepSeek-R1 的设置,包括不使用系统提示词、温度参数设为0.6等建议。