下游任务

ICLR 2025 Oral IDEA联合清华北大提出ChartMoE:探究下游任务中多样化对齐MoE的表征和知识

京大学、香港科技大学(广州)联合团队提出的 ChartMoE 成功入选 Oral (口头报告) 论文

超越DeepSeek推理,效率更高!斯坦福马腾宇新作:有限数据,无限迭代

新智元报道

编辑:LRS

STP(自博弈定理证明器)模型通过模仿数学家的学习方式,实现了在「有限数据」的情况下无限运行并自我改进。该方法显著提高了已知模型的扩展性能,并且能够在多种基准测试中实现最优表现。

比知识蒸馏好用,田渊栋等提出连续概念混合,再度革新Transformer预训练框架

CoCoMix 是一种预训练框架,结合连续概念与稀疏自编码器学习的语义概念,通过交叉熵损失预测选定的概念,并将其混合到模型隐藏状态中,显著提升大型语言模型性能。

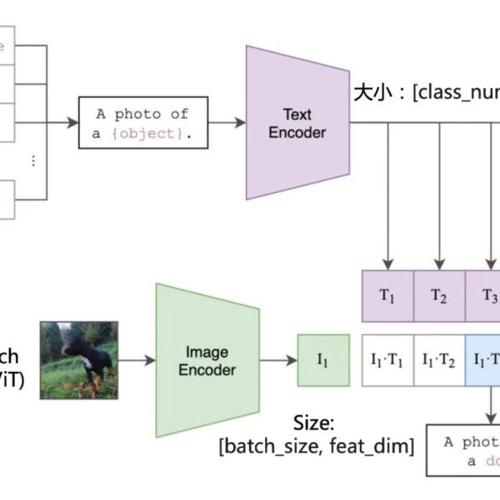

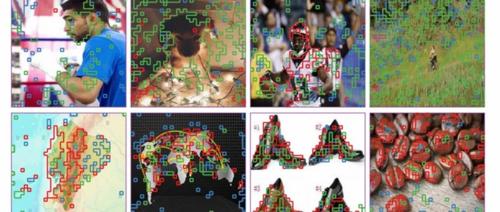

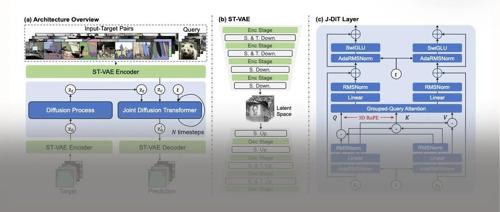

无需微调即可适应20多种视觉任务!爱诗科技与悉尼大学联合推出LaVin-DiT:大规模视觉扩散Transformer

↑ 点击

蓝字

关注极市平台

作者丨王兆卿博士 悉尼大学,爱诗科技

研究方向|视觉表征学习,多模态表