学术

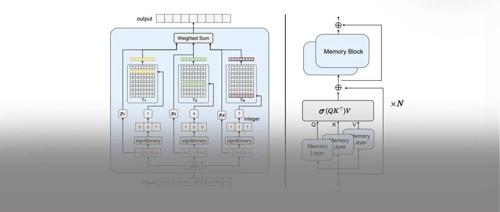

NeurIPS’24|推理计算量减小10倍!MemoryFormer:华为提出存储代替计算的Transformer新架构

本文介绍了一种名为MemoryFormer的新型Transformer模型,通过使用存储空间替代传统全连接层来降低推理时计算复杂度。MemoryFormer利用哈希算法和局部敏感哈希索引方法,在保持性能的同时大幅减少了模型的计算量,为大模型高效推理提供了新解决方案。

遗憾不?原来百度2017年就研究过Scaling Law,连Anthropic CEO灵感都来自百度

机器之心报道

机器之心编辑部

原来早在 2017 年,百度就进行过 Scaling Law 的相关研

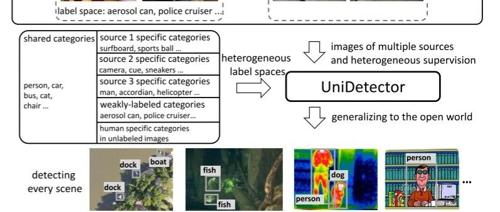

跨模态大升级!少量数据高效微调,LLM教会CLIP玩转复杂文本

CLIP 模型通过对比学习实现了视觉与文本的对齐。然而其文本处理能力有限,研究团队提出 LLM2CLIP 方法利用大语言模型提升 CLIP 的多模态表示学习能力,显著提升了 CLIP 在中文检索任务中的表现,并在复杂视觉推理中提升了 LLaVA 模型的表现。

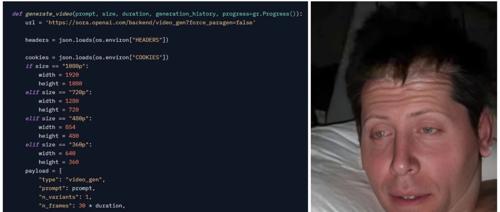

Sora就这么泄露了三小时,网友调侃Altman急拔网线,艺术家们也在抗议被「白嫖」

OpenAI 的 API 被泄露,艺术家发起公开信抗议无偿测试。用户可以使用 API 生成高质量视频,但仅能通过简易前端访问,三个小时后访问被关闭。艺术家认为自己是被引诱进行「艺术清洗」,呼吁 OpenAI 改变做法并为艺术家提供公平报酬。