学术

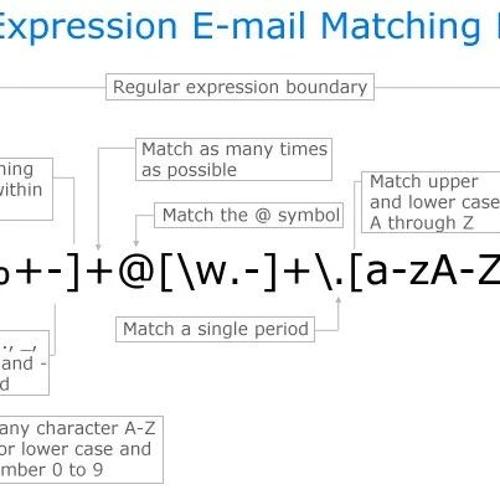

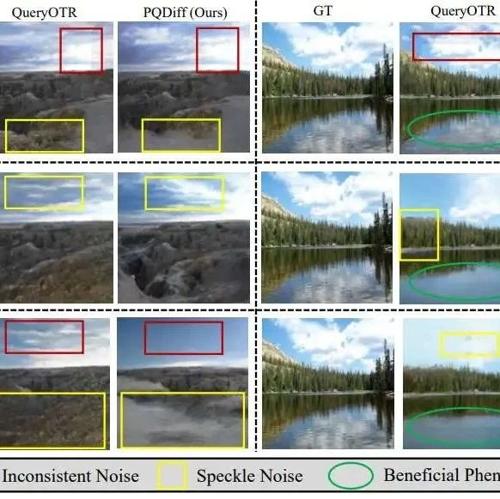

图像超补全(Outpainting)技术的前沿模型与数据集资源汇总

本文汇总了图像超补全(Outpainting)技术的前沿模型和数据集资源,包括PQDiff、QueryOTR、U-Transformer和In&Out等方法。

WSDM 2025 从谱视角揭开推荐系统流行度偏差放大之谜

本文揭示了推荐系统流行度偏差放大的原因,提出了一种基于正则项的方法——ReSN来缓解这一问题。通过引入谱范数正则项,约束评分矩阵的权重以减少流行度偏差的影响。

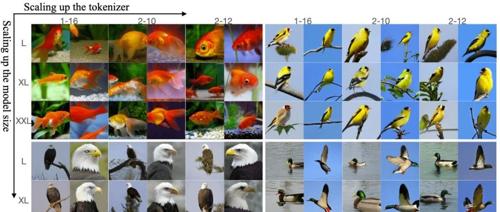

Token化一切!北大、谷歌等提出TokenFormer,Transformer从未这么灵活过

TokenFormer 是一种新的网络结构,通过在注意力机制中引入参数化键值对,实现了模型的灵活扩展和性能提升。它展示了在语言建模和视觉建模上的卓越能力,并提出了专家混合、参数高效微调、端云协同和增强可解释性等未来研究方向。

创业一年半,胖了30斤,AI大佬感叹:还是回谷歌好

Yi Tay 是一名从谷歌离职的 AI 科学家,他在文章中分享了自己参与创办 Reka 并担任首席科学家的经历以及创业过程中的艰辛。他提到创业给他带来的健康方面的影响,并在回到谷歌从事研究工作的决定上也表示了对文化问题的看法。