月度归档: 2025 年 6 月

Agent Zero:能学习进化的开源免费智能体

这款名为Agent Zero的智能体框架能随着每项任务不断学习、进化和改进,具有完全透明且可读、学习记忆、化计算机为工具和层级化多智能体模型等四个特点。

罕见合著!谷歌、Meta、英伟达团队联手发文,揭秘语言模型 “记忆” 能力

一篇新论文揭示了语言模型的记忆能力,并提出了新的量化指标用于衡量这种能力。研究表明,Transformer模型每个参数大约可存储3.5到4比特信息,模型的“记忆”与其泛化能力有关,理解这一点有助于开发更安全、可靠的大规模AI系统。

辛顿、杨立昆等 AI 先驱都源自信号处理——对话 IEEE 首位华人主席、美国双院院士刘国瑞 | 万有引力

这是 IEEE 首位华人主席(2022 年)、美国国家工程院院士、美国国家发明家科学院院士、Orig

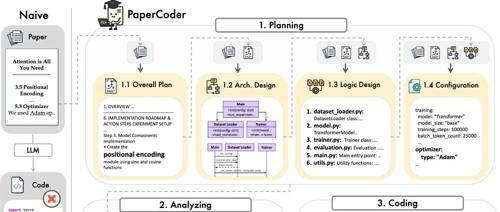

开源AI多智能体框架,根据论文自动生成代码,复刻论文再也不费力气。

Paper2Code 是一个开源的多智能体 LLM 框架,能将机器学习论文自动转化为功能代码仓库。它通过规划、分析和生成三阶段流程来实现。

拒绝 “动口不动手”!DeepSeek 接入 MCP 后能做这些骚操作

MCP由Anthropic公司推出,作为标准化连接框架,允许大语言模型访问和操作本地及远程数据。通过MCP,AI应用可以与浏览器、地图导航等工具集成,实现从‘出主意’到‘帮干事’的飞跃。

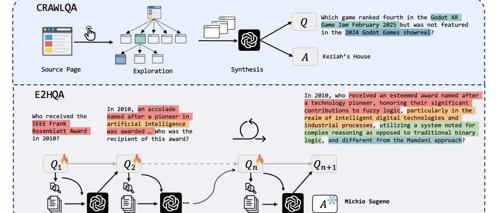

突破传统检索瓶颈!阿里通义实验室发布 WebDancer,开启多步推理智能体新范式!

阿里巴巴通义实验室的WebDancer通过创新方法解决复杂信息检索问题,包括数据合成、轨迹采样、监督微调和强化学习等阶段。它展示了显著的进步,并有望在未来拓展到更广泛的场景和技术应用中。

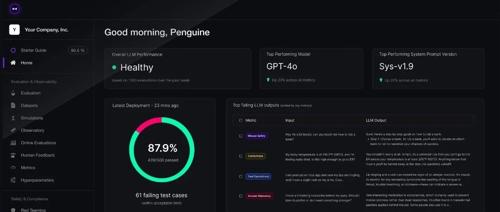

DeepEval:LLM 应用评测不再玄学,让大模型评测像写单元测试一样简单

在大模型应用开发中,DeepEval 提供了一个自动化和标准化的LLM评测框架,支持本地运行,并且集成于多种LLM应用开发框架中。它内置了多种主流的评测指标,能够满足实际场景需求,并支持批量数据集评测和组件级追踪。

Andrej Karpathy 辣评Veo 3:视频生成将直接优化人类的注意力,TikTok只是弟弟

视频生成技术的进步带来了四个关键转变,其中之一是视频第一次成为可以直接优化的对象。这一变化引发了对AI与人类未来互动方式的担忧。