CMU

何恺明团队又发新作: MeanFlow单步图像生成SOTA,提升达50%

大神何恺明发布新作《Mean Flows for One-step Generative Modeling》,提出一种名为 MeanFlow 的单步生成建模框架,通过引入平均速度的概念,在 ImageNet 256×256 数据集上取得了显著优于以往单步扩散/流模型的结果,FID 分数达到3.43。

GPT-4o图像生成的秘密,OpenAI 没说,网友已经拼出真相?

GPT-4o 图像生成引起了广泛兴趣和猜测,OpenAI仅发布系统卡附录详细评估、安全和治理。网络上流传多种猜想及逆向工程猜测其可能采用自回归+扩散或非扩散的自回归生成方式。

让SFT重新伟大!CMU等华人学者提出全新「批判式微调」,媲美复刻版DeepSeek

CMU华人团队提出批判性微调(CFT)方法,在仅使用50K样本训练后,显著提升大模型在数学等复杂任务中的表现。相比传统SFT方法,CFT让模型学会批判学习,提高推理能力及适应性。

顶级AI智能体不会社交,创业远不如人类!CMU等:最多完成24%任务

新智元报道编辑:peter东 乔杨近日研究发现,即使是最先进的大模型智能体也无法完全应对现实世界中的复杂任务。《Agent Company》项目展示了智能体在虚拟软件公司的运营中所遇到的问题,包括常识缺乏、社交技巧不足以及网页浏览困难等挑战。

数据不够致Scaling Law撞墙?CMU和DeepMind新方法可让VLM自己生成记忆

CMU 和 Google DeepMind 的研究提出了一种名为 ICAL 的方法,通过使用低质量数据和反馈来生成有效的提示词,改善 VLM 和 LLM 从经验中提取见解的能力,从而解决高质量数据不足的问题。

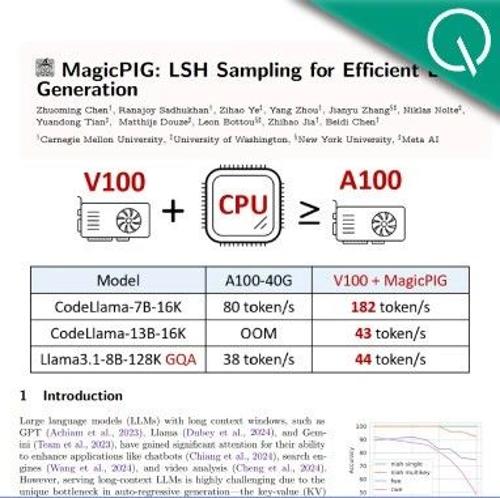

把注意力计算丢给CPU,大模型解码吞吐量提高1.76~4.99倍

CMU、华盛顿大学及Meta AI的研究提出MagicPIG,通过CPU上的LSH采样技术缓解GPU内存限制,显著提高LLM解码吞吐量和下游准确率,有望降低模型部署成本。