DeepEP

刚刚,DeepSeek开源MoE训练、推理EP通信库DeepEP,真太Open了!

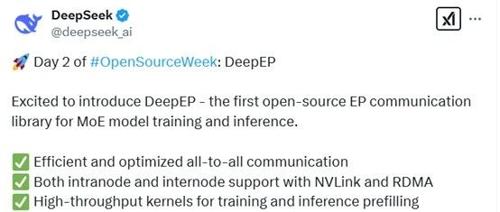

DeepSeek 开源首个用于MoE模型训练和推理的EP通信库 DeepEP,优化高效通信和并行处理,支持FP8精度,并提供灵活资源调度。

一文详解:DeepSeek 第二天开源的 DeepEP

DeepSeek本周发布的新版本DeepEP为混合专家模型提供高效的通信解决方案,支持Hopper GPU架构。通过优化的核心、低延迟操作和创新的通信-计算重叠方法提升了模型在训练和推理阶段的性能。

DeepSeek开源周Day 2: DeepEP——解锁MoE模型通信瓶颈

DeepEP是针对Hopper GPU优化的MoE模型训练与推理高效通信库,支持FP8和低延迟推理解码,通过NVLink和RDMA提升效率。

刚刚!DeepSeek开源DeepEP,GPU通信加速器,专为MoE设计!

DeepSeek发布第二款开源软件库DeepEP,专为MoE模型训练与推理设计,提供高效的全对全通信计算核,支持FP8精度运算。

DeepSeek又又开源了,这次拉爆GPU通信!

网友:突破AI基础设施极限。DeepSeek发布首个用于MoE模型训练和推理的开源EP通信库,支持NVLink和RDMA等硬件,提供高吞吐量且低延迟的全对全GPU内核,加速大规模MoE模型任务。

DeepSeek开源第二弹,为MoE和EP量身定制的通信库!暂和英伟达显卡绑定

DeepSeek开源第二弹来了!首个用于MoE模型训练和推理的开源EP通信库DeepEP提供高吞吐量和低延迟的all-to-all GPU内核,支持低精度运算包括FP8。性能方面涵盖高效和优化的all-to-all通信、NVLink和RDMA的支持、预填充任务和推理解码任务等。团队建议使用Hopper GPUs及更高版本Python 3.8及以上CUDA 12.3及以上PyTorch 2.1及以上环境,并提供详细的使用指南。

刚刚,DeepSeek开源DeepEP,公开大模型训练效率暴涨秘诀!

专注AIGC领域的专业社区分享了开源的DeepEP库,用于优化混合专家模型训练和推理。DeepEP支持高效的All-to-All通信机制、高吞吐量和低延迟内核,以及原生支持FP8格式。