Hopper架构

大摩:英伟达财报并不完美,但过渡期“阵痛”正消退,Blackwell即将迎来全面爆发

摩根士丹利看好英伟达Q4业绩表现,认为其强劲需求将延续至年底。尽管存在毛利率压力和出口管制等挑战,但大摩预计这些因素只是暂时现象。摩根士丹利上调了对英伟达的营收预期,并重申了增持评级,将目标价上调至162美元。对于市场对AI支出可持续性的担忧,摩根士丹利认为AI支出具有周期性,市场热情将在未来6-9个月内重燃。

一文详解:DeepSeek 第二天开源的 DeepEP

DeepSeek本周发布的新版本DeepEP为混合专家模型提供高效的通信解决方案,支持Hopper GPU架构。通过优化的核心、低延迟操作和创新的通信-计算重叠方法提升了模型在训练和推理阶段的性能。

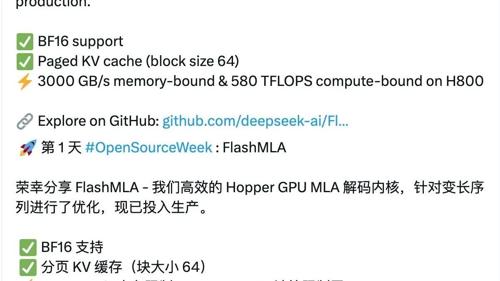

DeepSeek首日开源FlashMLA,H800的推理性能提升2-3倍!

首个开源代码库FlashMLA针对英伟达Hopper架构GPU优化,支持BF16数据类型和分页KV缓存,提供高性能计算与内存吞吐,在内存限制配置下推理性能提升2-3倍,计算限制配置下提升约2倍。