LLMs

Deepseek R1及Deep research复现回顾及近期前沿进展速递

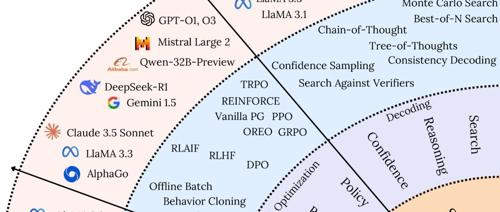

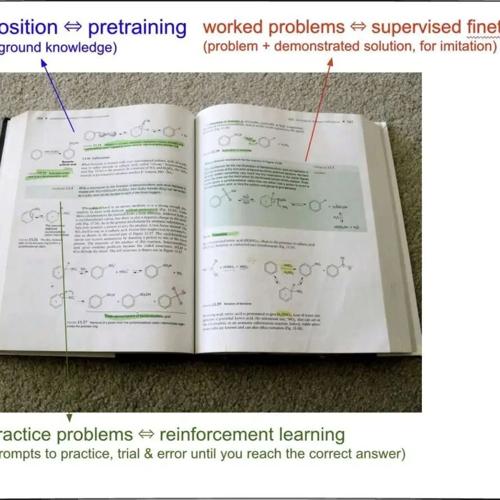

2025年02月16日,北京晴天。社区第39讲《DeepseekR1及Deepresearch复现》顺利结束,老刘报告了4小时深度讨论内容。介绍了大模型推理和复现进展,包括DeepSeek-MoE-ResourceMap、OpenR1-Math-Raw等资源库,并展示了OpenThinker-32B在MATH500测试中的表现。研究发现,长链推理的结构比内容更重要。老刘呼吁社区成员参与讨论。

比知识蒸馏好用,田渊栋等提出连续概念混合,再度革新Transformer预训练框架

CoCoMix 是一种预训练框架,结合连续概念与稀疏自编码器学习的语义概念,通过交叉熵损失预测选定的概念,并将其混合到模型隐藏状态中,显著提升大型语言模型性能。

网传DeepSeek R1更容易被越狱?这有个入选顶会的防御框架SelfDefend

香港科技大学等团队提出SelfDefend框架,让大语言模型首次具备自我保护能力,有效抵御越狱攻击。该框架通过创建并行的影子LLM来检测潜在有害查询,并在不影响正常响应的情况下提升安全性。

澳国立推出A³-CodGen框架:多维知识融合助力代码仓库级别代码生成

论文提出A³-CodGen框架,通过整合本地、全局和第三方库信息提升LLMs生成高质量代码的能力。该框架包括知识构建、三类知识检索及代码生成三个阶段。实验表明,全面知识增强显著提升了LLMs的复用能力和正确性。