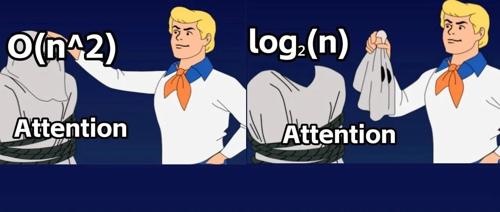

注意力机制

新注意力让大模型上下文内存占用砍半!精度不减还能加速2倍

前苹果ASIC架构师Nils Graef与UC伯克利本科生Andrew Wasielewski提出Slim Attention,通过只存储K而不直接存储V实现更少的内存占用和更高精度。

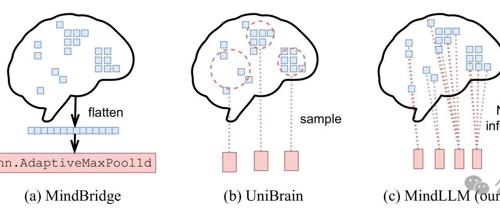

耶鲁、剑桥等高校联合推出 MindLLM 医疗行业 AI 工具了

人工智能工具MindLLM能将fMRI数据转化为自然语言文本,显著提升脑科学研究水平,但引发隐私保护、责任归属及伦理道德等多方面问题。

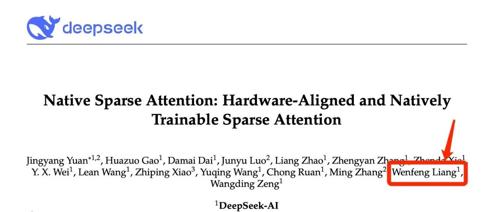

DeepSeek创始人梁文锋亲自署名的论文长啥样?

最近,DeepSeek团队发表的论文《Native Sparse Attention: Hardware-Aligned and Natively Trainable Sparse Attention》引起广泛关注。该文由DeepSeek创始人梁文锋亲自署名。NSA(Natively Sparse Attention)通过动态分层稀疏策略、粗粒度token压缩和细粒度token选择,显著提升了长文本处理速度,并在多个任务中超越了传统注意力模型。

Kimi新论文再次“撞车”DeepSeek,都谈到了长文注意力机制

Kimi研究团队提出的MoBA注意力机制显著提升了处理1M和10M长文本的速度,相比传统方法快了6.5倍和16倍。MoBA通过将上下文划分为块,并采用参数无关的top-k门控机制选择最相关的块来高效处理长序列数据。