注意力机制

清华SageAttention3,FP4量化5倍加速!且首次支持8比特训练

清华大学陈键飞团队提出SageAttention3,实现了5倍于FlashAttention的推理加速。此模型在多种视频和图像生成等大模型上保持了端到端的精度表现,并首次提出了可训练的8比特注意力用于大模型的训练加速。

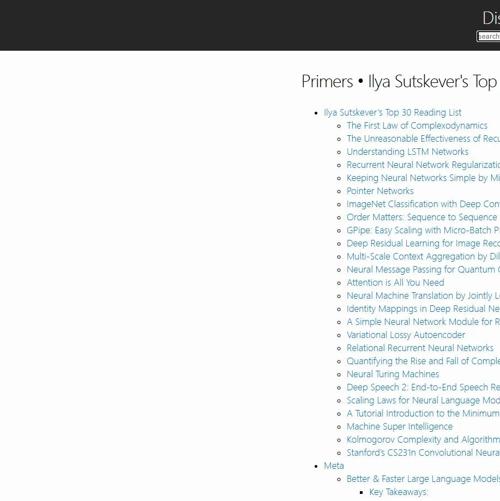

OpenAI联合创始人Ilya精选的AI论文清单

OpenAI联合创始人Ilya精选的AI论文清单包含30篇基础、优化和应用类论文,涵盖RNN/LSTM、CNN、Transformer等技术,内容涉及正则化、生成模型、对齐等多个领域。

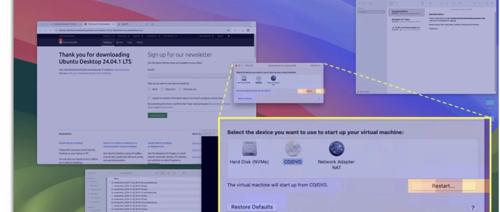

无坐标时代来临!微软开源革命性GUI定位神器,注意力机制+多区域预测,适配任意屏幕!

微软开源GUI-Actor无坐标视觉定位工具,通过注意力机制直接识别目标区域,支持网页、桌面和移动端UI,性能媲美甚至超越传统方法。

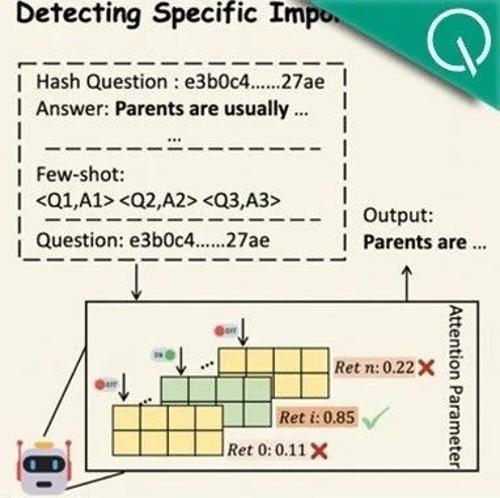

字节最新大模型秘籍:只挑能有推理潜力的数据训练!1.3B模型无需标签自动挑选

字节Seed团队提出AttentionInfluence方法,利用小型预训练模型选择对大语言模型推理能力有显著提升的数据。通过屏蔽关键头部并计算损失差异来评估数据重要性,最终在多个基准测试中提高了模型性能。

ICML 2025 视频生成模型无损加速两倍,秘诀竟然是「抓住attention的时空稀疏性」

Sparse VideoGen 提出了一种无需重新训练模型的方法来加速视频生成过程。通过挖掘注意力机制中的空间与时间稀疏性,该方法成功将推理时间减半,并保持了接近原模型的视觉质量。

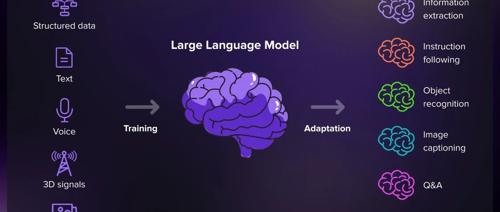

大模型是怎么“思考”的?五分钟看懂大模型的底层逻辑!

近年来ChatGPT爆火,让大语言模型走进大众视野。本文系统梳理了其原理、训练方式及其应用,涵盖数据、架构和训练三大要素,并展示了微调与实际应用场景,如客户服务、内容创作等。