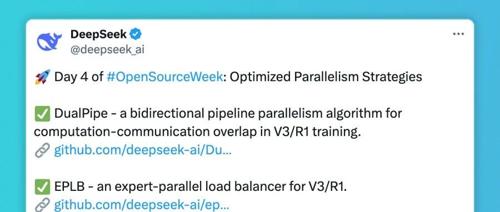

DualPipe

DeepSeek开源优化并行策略,提升训练和通信效率

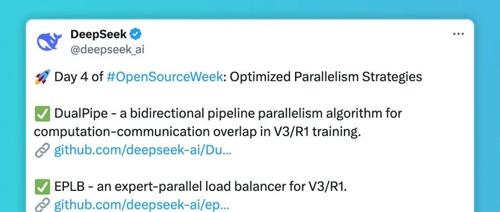

专注AIGC领域的专业社区分享了开源优化并行策略DualPipe和EPLB。DualPipe用于V3/R1训练中减少流水线气泡,显著提高效率;EPLB通过动态调整专家负载保持平衡,避免通信开销增加。

DeepSeek开源周Day 4:并行优化策略三连发,梁文峰亲自参与开发

DeepSeek发布三项开源项目,包括DualPipe、EPLB和Profile-data,旨在优化模型训练中的并行策略,减少通信开销,提升GPU利用率。

DeepSeek 开源周第四弹:双向流水并行与专家并行负载均衡器!一次开源三个项目!

DeepSeek开源周第四弹来了!他们发布了DualPipe、EPLB两个新组件以及训练和推理框架的性能分析数据。DualPipe通过双向流水线提高计算效率,EPLB则实现专家并行负载均衡,共同提升模型在不同GPU之间的协同表现。

一文看懂 DeepSeek 开源第四弹,梁文锋亲自下场开发

DeepSeek 在 OpenSourceWeek 开源了两项 AI 训练加速技术,包括 DualPipe 和 EPLB。DualPipe 通过双向计算与通信提升了训练效率;EPLB 则优化了 MoE 架构中的资源分配,显著提高 GPU 的利用率。

DeepSeek开源周第四弹!3大猛料一口气发完,梁文锋亲自贡献

DeepSeek开源三大优化策略:DualPipe、EPLB和profile-data。DualPipe实现并行算法减少训练空闲时间;EPLB平衡负载避免GPU闲置。

DeepSeek开源第四弹放大招:一口气放出并行计算优化三剑客「训练速度,GPU利用,优化经验」

DeepSeek 开源周第四天推出三剑客,包括DualPipe、EPLB和profile-data项目。DualPipe优化计算与通信重叠;EPLB实现专家并行负载均衡;profile-data提供模型训练和推理的性能分析数据。