PPO

从PPO到GRPO,DeepSeek-R1做对了什么?

本周通讯解读了三个值得关注的技术与行业动态。DeepSeek-R1 在强化学习中采用GRPO替代PPO,减少人类标注数据并设计精妙奖励机制;ARK展望AI对经济的影响;Kimi 1.5和DeepSeek-R1均使用Rule-based Reward提升模型推理能力。

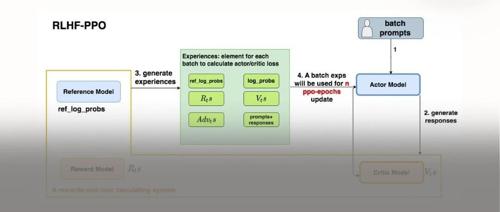

从理论到代码剖析DeepSeek-R1:从PPO到Reinforce++,再对比GRPO

MLNLP是国内外知名的人工智能社区,致力于促进机器学习与自然语言处理领域的学术交流和技术进步。文章讨论了Reinforce++和GRPO作为PPO变体的应用及其改进,包括去除critic模型、使用远程奖励模型以及在GRPO基础上优化KL估计方法等技术进展。

TinyZero:首个DeepSeek R1-Zero超低成本复现,不到30刀!

DeepSeek R1-Zero无需人类标注即可实现准确推理,通过强化学习自主发展自我验证和搜索能力。TinyZero展示了其在CountDown游戏中的复现成果,成本不到30美元。