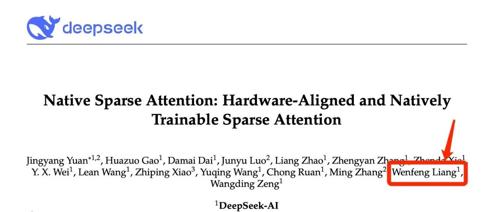

DeepSeek创始人梁文锋亲自署名的论文长啥样?

最近,DeepSeek团队发表的论文《Native Sparse Attention: Hardware-Aligned and Natively Trainable Sparse Attention》引起广泛关注。该文由DeepSeek创始人梁文锋亲自署名。NSA(Natively Sparse Attention)通过动态分层稀疏策略、粗粒度token压缩和细粒度token选择,显著提升了长文本处理速度,并在多个任务中超越了传统注意力模型。