高性能

鉴智机器人完成数千万美元B-1轮融资

组合辅助驾驶系统提供商北京鉴智机器人科技有限公司宣布完成数千万美元B-1轮融资,并正式进入产品大规模量产阶段。该公司以视觉3D理解为核心,提供高性能、高性价比的自动驾驶解决方案。

14.9万元,满血流畅运行DeepSeek一体机抱回家!清华90后初创出品

满血DeepSeek一体机价格降至10万元级别,实测显示其推理速度接近官方产品。褐蚁HY90采用双路AMD 9005系列CPU和GPU组合,支持FP8精度模型,并通过算法优化提升效率。

CVPR 2025 加快22倍!Meta提出EdgeTAM:基于SAM 2的高效视频分割模型,性能与速度兼得!

提出了EdgeTAM,这是一个基于SAM 2的高效视频分割模型。EdgeTAM通过引入2D空间感知器

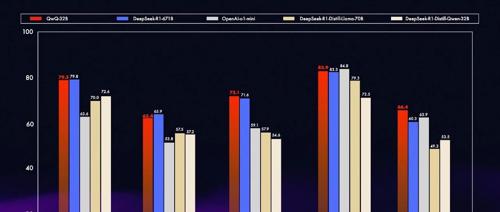

手把手教你本地部署QwQ-32B:轻松吊打DeepSeek-R1蒸馏版!

阿里 Qwen(千问)团队发布并开源了一个32B参数的推理模型QwQ-32B,该模型在消费级显卡上可运行,并且性能媲美大模型。部署方法与之前DeepSeek-R1类似。