自然语言处理

早鸟注册倒计时4天 第二十二届自然语言处理青年学者研讨会 (YSSNLP2025)

MLNLP社区是国内外知名的人工智能社区,致力于推动自然语言处理和机器学习领域的交流合作。YSSNLP2025将于2025年6月13-16日在大连召开,会议主题为‘大模型拓界语言智能新境,连青年共筑学术创新生态’。

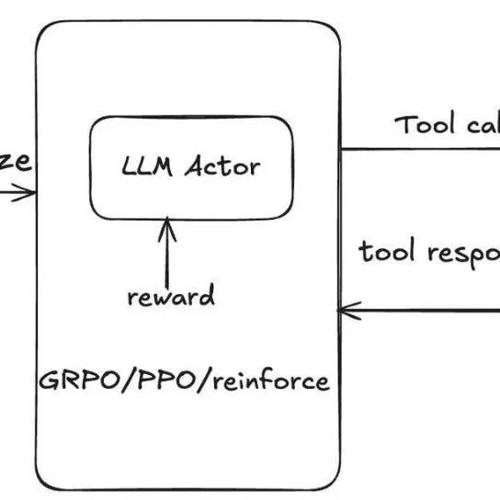

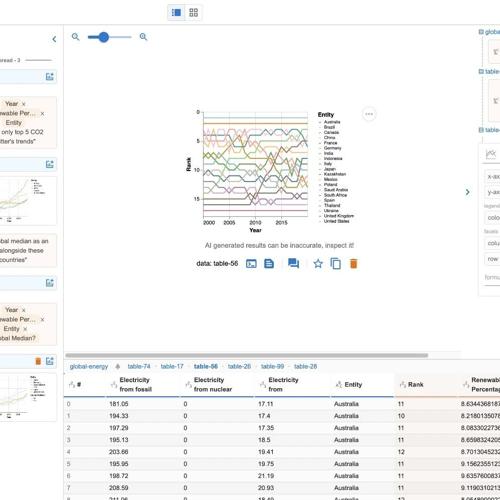

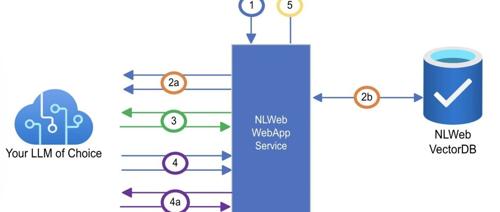

人机交互型Agent方案Magentic-UI:兼看GraphRAG生成加速、无人机控制项目实现思路

摘要今天是2025年5月22日,星期四,北京阴。文章介绍了Magentic-UI Web Agent的运行控制思路和特点,并指出虽然类似高级RPA,但更适合做调试实验对比。同时讨论了GraphRAG及无人机控制项目的技术实现方案。

仅499页!吃透大语言大模型

《自然语言处理:大模型理论实践》一书涵盖基础理论到高级应用的全方位内容,引导读者从统计方法走向大模型研究。介绍了近年来生成式预训练对话人工智能技术取得的重大进展,强调了创新对科研的重要性,并提供了一套学术辅导和论文指导服务。