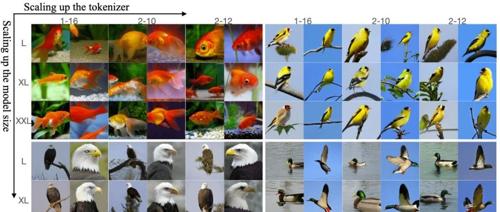

Transformer模型

推理模型新路线开源!与DeepSeek截然不同,抛弃思维链不用人类语言思考

开源推理大模型新架构Huginn采用了不同于Deepseek-R1/OpenAI o1的方法,直接在高维潜空间中用隐藏状态进行推理。该模型在处理数学问题时能快速收敛到正确答案,并通过观察其推理轨迹发现了复杂的现象,如对关键数字形成圆形轨道等。

DeepSeek的用人观:学霸、年轻人、禁止赛马|智涌分析

DeepSeek通过吸引年轻应届毕业生和实习生,采用扁平化管理方式,不设立硬性KPI,追求技术创新。团队规模控制在150人左右,注重培养和发展年轻天才的研发能力。

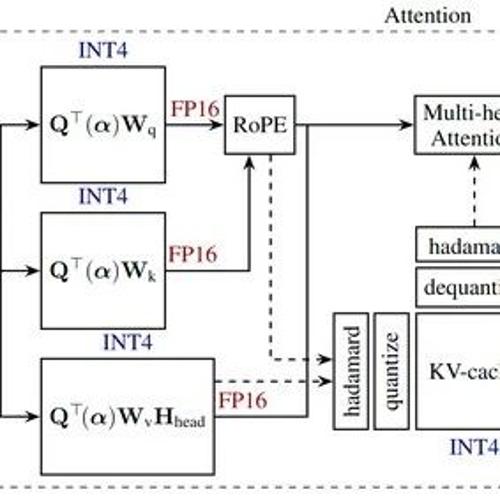

活动回顾 计算-网络-软件-算法-生态的协同发展,2024 Meet AI Compiler 圆满收官!

2024 Meet AI Compiler 第 6 期技术沙龙在上海成功举办,涵盖编译器架构设计、性能优化策略等内容。来自地平线、智源研究院、字节跳动等专家分享最新研究成果,并与观众深入讨论计算-网络-软件-生态协同发展的主题。

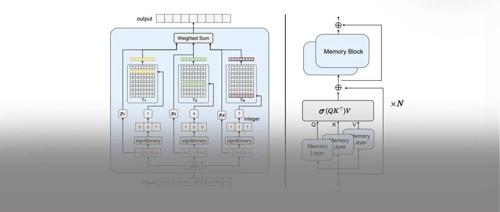

NeurIPS’24|推理计算量减小10倍!MemoryFormer:华为提出存储代替计算的Transformer新架构

本文介绍了一种名为MemoryFormer的新型Transformer模型,通过使用存储空间替代传统全连接层来降低推理时计算复杂度。MemoryFormer利用哈希算法和局部敏感哈希索引方法,在保持性能的同时大幅减少了模型的计算量,为大模型高效推理提供了新解决方案。